一、前言

本篇文章将解析 QWen1.5 系列模型的微调代码,帮助您理解其中的关键技术要点。通过阅读本文,您将能够更好地掌握这些关键技术,并应用于自己的项目中。

开源模型应用落地-qwen1.5-7b-chat-LoRA微调(二)

二、术语介绍

2.1. LoRA微调

LoRA (Low-Rank Adaptation) 用于微调大型语言模型 (LLM)。 是一种有效的自适应策略,它不会引入额外的推理延迟,并在保持模型质量的同时显着减少下游任务的可训练参数数量。

2.2.参数高效微调(PEFT)

仅微调少量 (额外) 模型参数,同时冻结预训练 LLM 的大部分参数,从而大大降低了计算和存储成本。

三、前置条件

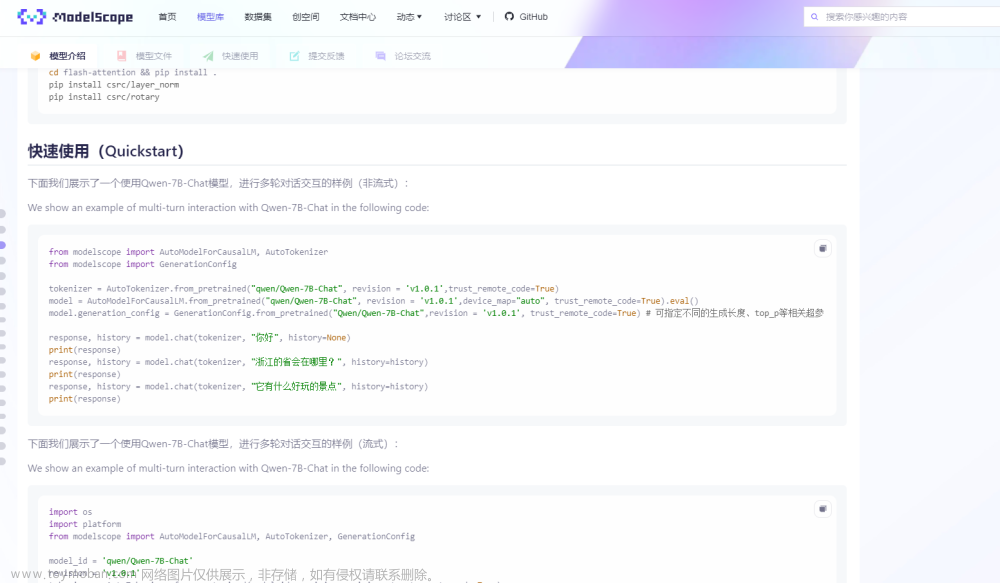

3.1.下载完整qwen1.5项目

方式一:直接下载文章来源:https://www.toymoban.com/news/detail-849349.html

地址:

GitHub - QwenLM/Qwen1.5: Qwen1.5 is the improved version of Qwen, the large文章来源地址https://www.toymoban.com/news/detail-849349.html

到了这里,关于开源模型应用落地-qwen1.5-7b-chat-LoRA微调代码拆解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!