今天介绍transformer模型的Feed Forward network前馈网络和Relu激活函数

背景

位置感知Position-Wise前馈网络(FFN)由两个全连接层(fully connected dense layers,就是线性层(Linear Layer),或密集层(Dense Layer))组成,或者也可以称为多层感知机(MLP:multi-layer perceptron)。

参见:Transformer模型-线性层(Linear Layer),全连接层(Fully Connected Layer)或密集层(Dense Layer)的简明介绍-CSDN博客https://blog.csdn.net/ank1983/article/details/137212380

隐藏层,也被称为d_ffn,通常被设置为d_model值的四倍左右。这也是它有时被称为扩展-收缩网络的原因。

根据《动手学深度学习》一书的描述,它被称为“位置感知”网络是因为它“使用相同的MLP在所有序列位置转换表示”。

换句话说,FFN的第一层大小为(d_model,d_ffn),这意味着在进行张量乘法时,它需要在每个序列上进行广播。这意味着每个序列都乘以相同的权重。如果输入的是相同的序列,那么输出也将是相同的。这个逻辑同样适用于大小为(d_ffn,d_model)的第二全连接层,它使张量返回到其原始大小。

在层与层之间,使用ReLU激活函数,即max(0, X)。任何大于0的值保持不变,而任何小于或等于0的值都将变为0。它引入了非线性,有助于防止梯度消失。

ReLU(Rectified Linear Unit,修正线性单元)

ReLU(Rectified Linear Unit,修正线性单元)是一种在神经网络中广泛使用的激活函数。ReLU函数将所有负值映射为0,而正值则保持不变。其数学表达式为:

f(x) = max(0, x)

对于任何输入x,如果x是正数或零,则ReLU函数返回x本身;如果x是负数,则返回0。

ReLU激活函数有几个关键优点:

计算效率:ReLU函数及其导数都是分段线性的,这使得它在计算上非常高效,尤其是在使用现代GPU进行大规模并行计算时。

稀疏性:ReLU可以产生稀疏的激活,即许多神经元的输出为0。这有助于网络学习更加有效的特征表示,因为网络可以专注于对任务重要的输入。

缓解梯度消失问题:在深度神经网络中,当使用Sigmoid或Tanh等激活函数时,由于它们的导数在大部分输入空间内都非常小,可能导致梯度消失问题。而ReLU在正值区域的导数为1,这有助于缓解梯度消失问题,使得深层网络更容易训练。

FFN基本实现-举例

准备:目前输出是(3,6,8)。这表示有3个序列,每个序列包含6个标记,每个标记有8维嵌入。

第一步:这个输出可以通过FFN(前馈网络)。这将把8维嵌入转换为32维嵌入。这个转换过程还通过了ReLU激活函数。新的形状将是(3, 6, 8) x (8, 32) → (3, 6, 32)。

第二步:这个张量可以通过第二层全连接层返回到其正常大小,即(3, 6, 32) x (32, 8) = (3, 6, 8)。这些值已经根据权重和激活函数发生了改变。

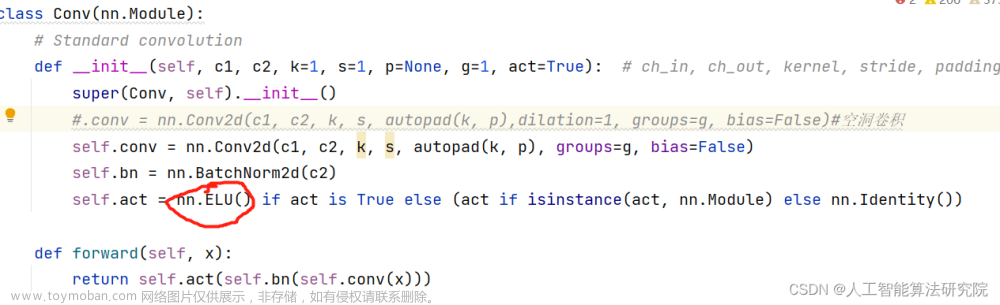

FFN 在Transformers的实现:

跟上面2步一模一样,max()就是Relu()文章来源:https://www.toymoban.com/news/detail-850475.html

原文链接:https://medium.com/@hunter-j-phillips/position-wise-feed-forward-network-ffn-d4cc9e997b4c文章来源地址https://www.toymoban.com/news/detail-850475.html

到了这里,关于Transformer模型-Feed Forward前馈网络和Relu激活函数的简明介绍的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!