前言

在当今的人工智能领域,部署大型深度学习模型是一个挑战,尤其是对于那些不熟悉复杂技术栈的用户而言。然而,随着开源技术的不断发展,出现了一些强大的工具,如 Ollama 和 Open WebUI,使得部署大型模型变得更加简单和高效。

Ollama 是一个功能强大的开源平台,专门用于部署深度学习模型。

与此同时,Open WebUI 是一个开源的 Web 用户界面工具,为用户提供了友好的界面来与 Ollama 平台进行交互。通过 Open WebUI,用户可以直观地浏览模型的性能指标、调整模型参数,并进行部署和监控。

本文将介绍如何利用 Ollama 和 Open WebUI 在 Linux 平台上部署大型深度学习模型。通过简单的步骤,您将能够快速搭建起一个高效的模型部署环境

一、Ollama 安装

Ollama 的安装步骤如下:

-

安装 Docker:

首先,确保您的系统已经安装了 Docker。您可以按照 Docker 官方文档提供的指南来安装 Docker:https://docs.docker.com/get-docker/

-

拉取 Ollama 镜像:

打开终端或命令提示符,运行以下命令来拉取 Ollama 镜像:

docker pull ollama/ollama这将从 Docker Hub 上下载 Ollama 的最新版本。

-

运行 Ollama 容器:

运行以下命令来启动 Ollama 容器:

docker run -d --restart=always -v /home/docker/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama这将在后台运行一个名为 “ollama” 的容器,并将

/home/docker/ollama目录挂载到容器内的/root/.ollama目录,同时将容器内的端口 11434 映射到宿主机的端口 11434。 -

访问 Ollama Web 界面:

打开您的浏览器,并访问

http://localhost:11434(如果您的 Docker 守护进程运行在远程主机上,则将localhost替换为相应的 IP 地址)。您将会看到 Ollama 的 Web 界面,通过它您可以开始构建、训练和部署深度学习模型。

通过按照以上步骤,您将能够在您的系统上成功安装和运行 Ollama。请注意,确保您的系统满足 Docker 的要求,并且具有足够的存储空间来存储 Ollama 容器中的数据。

二、Open WebUI 安装

要使用 Docker 安装 Open-webui,您可以创建一个 Docker 容器,并在其中运行 Open-webui 服务。以下是安装 Open-webui 的步骤:

-

拉取 Open WebUI 镜像:

首先,您需要从 Docker Hub 上拉取 Open WebUI的镜像。在终端或命令提示符中运行以下命令:

docker pull openwebui/open-webui -

运行 Open WebUI 容器:

使用以下命令在容器中运行 Open WebUI 服务:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main这将在后台运行一个名为 “open-webui” 的容器,并将容器内的端口 3000 映射到宿主机的端口 3000。

-

访问 Open WebUI:

打开您的浏览器,并访问

http://localhost:3000。您应该会看到 Open WebUI的用户界面,通过它您可以与 Ollama 平台进行交互,管理模型和监控训练过程。

三、配置及使用

-

下载模型

进入到 Open WebUI 页面点击设置,在设置里面点击模型,输入我们需要下载的模型并点击下载,等下载完成之后我们就可以使用了。

以下是目前支持的大模型

-

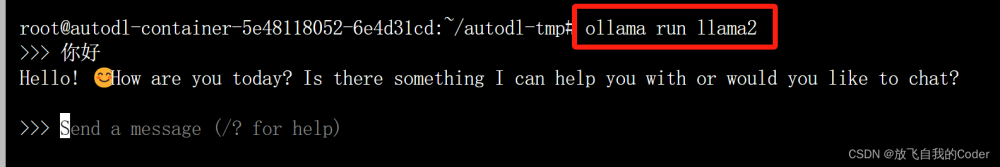

使用

选择希望使用的模型,就可以无限的畅玩啦

总结

本文介绍了使用 Docker 安装 Ollama 平台和 Open-webui 工具的方法。Ollama 提供深度学习模型部署环境,而 Open-webui 则提供直观的 Web 用户界面来与 Ollama 平台进行交互。通过简单的步骤,用户可以快速部署和使用这些工具,加速深度学习模型的开发和部署过程。文章来源:https://www.toymoban.com/news/detail-850621.html

提示:更多内容可以访问Clang’s Blog:https://www.clang.asia文章来源地址https://www.toymoban.com/news/detail-850621.html

到了这里,关于Linux平台利用Ollama和Open WebUI部署大模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[最新搭建教程]0基础Linux CentOS7系统服务器本地安装部署ChatGPT模型服务搭建/免费域名绑定网页Https访问/调用open AI的API/GPT3/GPT3.5/GPT4模型接口](https://imgs.yssmx.com/Uploads/2024/02/499065-1.png)