1.背景介绍

Hidden Markov Model(HMM)是一种概率模型,用于描述一系列随机过程中的隐藏状态。它在许多领域得到了广泛应用,例如语音识别、自然语言处理、计算机视觉、生物信息学等。在这篇文章中,我们将深入探讨HMM的核心概念、算法原理、具体操作步骤以及数学模型公式。

1.1 HMM的基本概念

1.1.1 隐藏状态和观测值

在HMM中,我们假设存在一系列隐藏的状态,这些状态随时间发生变化。这些状态是随机的,但是我们只能通过观测到的数据来推断它们。观测值是隐藏状态与观测值之间的关系的一个实例。

1.1.2 状态转移和观测概率

我们需要两种概率来描述HMM:

- 状态转移概率:表示从一个状态到另一个状态的概率。

- 观测概率:表示在某个状态下观测到某个值的概率。

1.1.3 状态图

我们可以使用有向图来表示HMM,其中节点表示状态,有向边表示状态转移。每个节点还附带两个概率值:出度和入度,分别表示从该状态转移到其他状态的概率和从其他状态转移到该状态的概率。

1.2 HMM的核心概念与联系

1.2.1 隐藏马尔科夫链

HMM是一种隐藏马尔科夫链,因为当前状态只依赖于前一个状态,而不依赖于之前的状态。这种依赖关系使得HMM具有马尔科夫性质。

1.2.2 观测值的生成过程

在HMM中,观测值是通过隐藏状态生成的。给定一个隐藏状态,观测值会根据该状态生成,并独立地生成。

1.2.3 状态转移和观测概率的联系

状态转移概率和观测概率之间存在联系,因为它们共同决定了观测值的生成过程。我们可以通过估计这些概率来学习HMM的参数。

1.3 HMM的核心算法原理和具体操作步骤

1.3.1 前向算法

前向算法用于计算给定观测序列的概率。具体步骤如下:

- 初始化:计算初始状态的概率。

- 迭代:对于每个时间步,计算当前状态的概率。

- 累加:将所有时间步的概率累加,得到观测序列的概率。

1.3.2 后向算法

后向算法用于计算给定观测序列的概率。具体步骤如下:

- 反向迭代:从最后一个时间步开始,计算每个状态的概率。

- 累加:将所有时间步的概率累加,得到观测序列的概率。

1.3.3 Baum-Welch算法

Baum-Welch算法用于估计HMM的参数。具体步骤如下:

- 初始化:根据观测序列初始化隐藏状态的概率。

- 迭代:对于每个时间步,计算当前状态的概率。

- 更新:根据当前状态的概率更新隐藏状态的概率。

1.4 HMM的数学模型公式

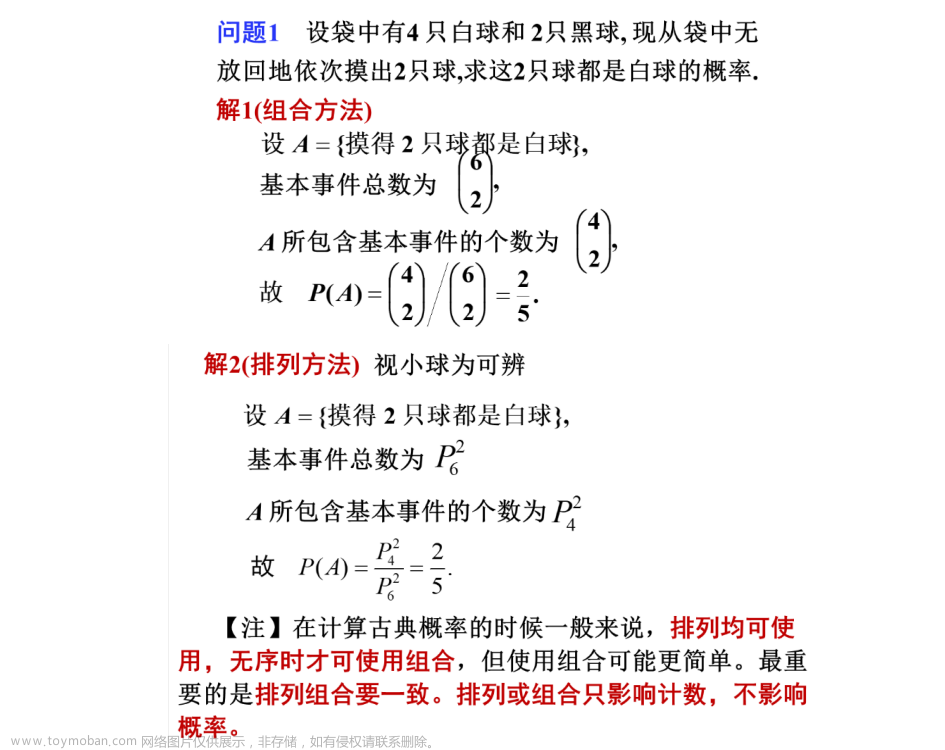

1.4.1 状态转移概率

状态转移概率表示从一个状态到另一个状态的概率,记为$A_{ij}$,其中$i$和$j$分别表示从状态$i$到状态$j$的转移。

$$ A{ij} = P(qt = j | q_{t-1} = i) $$

1.4.2 观测概率

观测概率表示在某个状态下观测到某个值的概率,记为$Bj(ot)$,其中$j$表示状态,$o_t$表示观测值。

$$ Bj(ot) = P(ot | qt = j) $$

1.4.3 初始状态概率

初始状态概率表示隐藏状态在开始时的概率,记为$\pi_i$,其中$i$表示状态。

$$ \pii = P(q1 = i) $$

1.4.4 前向算法

前向算法用于计算给定观测序列的概率,记为$\alpha_t(i)$,其中$i$表示状态,$t$表示时间步。

$$ \alphat(i) = P(o^t, qt = i) $$

1.4.5 后向算法

后向算法用于计算给定观测序列的概率,记为$\beta_t(i)$,其中$i$表示状态,$t$表示时间步。

$$ \betat(i) = P(o^{t+1}, qt = i) $$

1.4.6 Baum-Welch算法

Baum-Welch算法用于估计HMM的参数,包括状态转移概率、观测概率和初始状态概率。具体公式如下:

- 状态转移概率:

$$ A{ij} = \frac{\sum{t=1}^T P(qt = j | q{t-1} = i, o^t)}{\sum{t=1}^T P(q{t-1} = i, o^t)} $$

- 观测概率:

$$ Bj(ot) = \frac{\sum{t=1}^T P(qt = j, ot | o^{t-1})}{\sum{t=1}^T P(q_t = j | o^{t-1})} $$

- 初始状态概率:

$$ \pii = \frac{\sum{t=1}^T P(q1 = i, o^t)}{\sum{t=1}^T P(o^t)} $$

1.5 具体代码实例和详细解释说明

在这里,我们将提供一个使用Python实现的HMM示例代码,以及对其中的关键部分进行详细解释。

```python import numpy as np

初始化HMM参数

numstates = 3 numobservations = 4 A = np.array([[0.5, 0.3, 0.2], [0.2, 0.5, 0.3], [0.3, 0.2, 0.5]]) B = np.array([[0.1, 0.2, 0.3, 0.4], [0.2, 0.3, 0.2, 0.3], [0.3, 0.2, 0.1, 0.4]]) start_prob = np.array([0.4, 0.3, 0.3])

前向算法

def forward(obs): numstates = len(A) numobs = len(obs) alpha = np.zeros((numobs, numstates)) alpha[0, :] = start_prob * B[obs[0]]

for t in range(1, num_obs):

alpha[t, :] = np.dot(alpha[t-1, :], A) * B[obs[t]]

return alpha后向算法

def backward(obs): numstates = len(A) numobs = len(obs) beta = np.zeros((numobs, numstates)) beta[-1, :] = np.ones(num_states)

for t in range(num_obs-2, -1, -1):

beta[t, :] = np.dot(A.T, beta[t+1, :]) * B[:, obs[t+1]]

return beta计算概率

def prob(obs): num_obs = len(obs) alpha = forward(obs) beta = backward(obs) prob = np.dot(alpha[-1, :], beta[0, :]) return prob

使用示例数据

obs = [0, 1, 2, 0, 1, 2, 0] print(prob(obs)) ```

在这个示例中,我们首先初始化了HMM的参数,包括隐藏状态的数量、观测值的数量、状态转移概率矩阵、观测概率矩阵和初始状态概率向量。然后我们实现了前向算法、后向算法和概率计算函数。最后,我们使用了示例数据来计算给定观测序列的概率。

1.6 未来发展趋势与挑战

HMM在许多领域得到了广泛应用,但仍然存在一些挑战。这些挑战包括:

- 当观测值的数量很大时,计算概率可能变得非常耗时。

- HMM无法直接处理连续观测值,例如音频信号。

- HMM无法处理观测值之间的依赖关系,例如,当观测到一个单词时,某些单词更容易出现。

为了解决这些挑战,研究人员正在寻找新的概率模型和算法,例如隐藏马尔科夫模型的拓展(如条件随机场、循环隐藏马尔科夫模型等)以及更复杂的模型(如深度隐藏马尔科夫模型)。

1.7 附录常见问题与解答

1.7.1 HMM与其他概率模型的区别

HMM与其他概率模型(如Naive Bayes、条件随机场等)的主要区别在于其隐藏状态的特性。HMM的隐藏状态是随机的,而其他模型的隐藏状态是已知的。

1.7.2 HMM与深度学习的结合

深度学习可以用于处理HMM的一些挑战,例如处理大量观测值和捕捉观测值之间的依赖关系。一种常见的方法是将HMM与递归神经网络(RNN)结合,以创建深度隐藏马尔科夫模型(Deep HMM)。

1.7.3 HMM的优缺点

HMM的优点包括:

- 简单易理解:HMM的概念和算法相对简单,易于理解和实现。

- 灵活性:HMM可以用于处理各种类型的问题,包括语音识别、自然语言处理、计算机视觉等。

HMM的缺点包括:文章来源:https://www.toymoban.com/news/detail-851310.html

- 计算效率:当观测值的数量很大时,HMM的计算效率可能较低。

- 模型复杂度:HMM无法直接处理连续观测值和观测值之间的依赖关系。

在下一篇博客文章中,我们将讨论如何使用HMM解决实际问题,并探讨其在各种领域的应用。文章来源地址https://www.toymoban.com/news/detail-851310.html

到了这里,关于概率论中的Hidden Markov Model的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![概率论中的 50 个具有挑战性的问题 [第 6 部分]:Chuck-a-Luck](https://imgs.yssmx.com/Uploads/2024/02/767241-1.png)