1.背景介绍

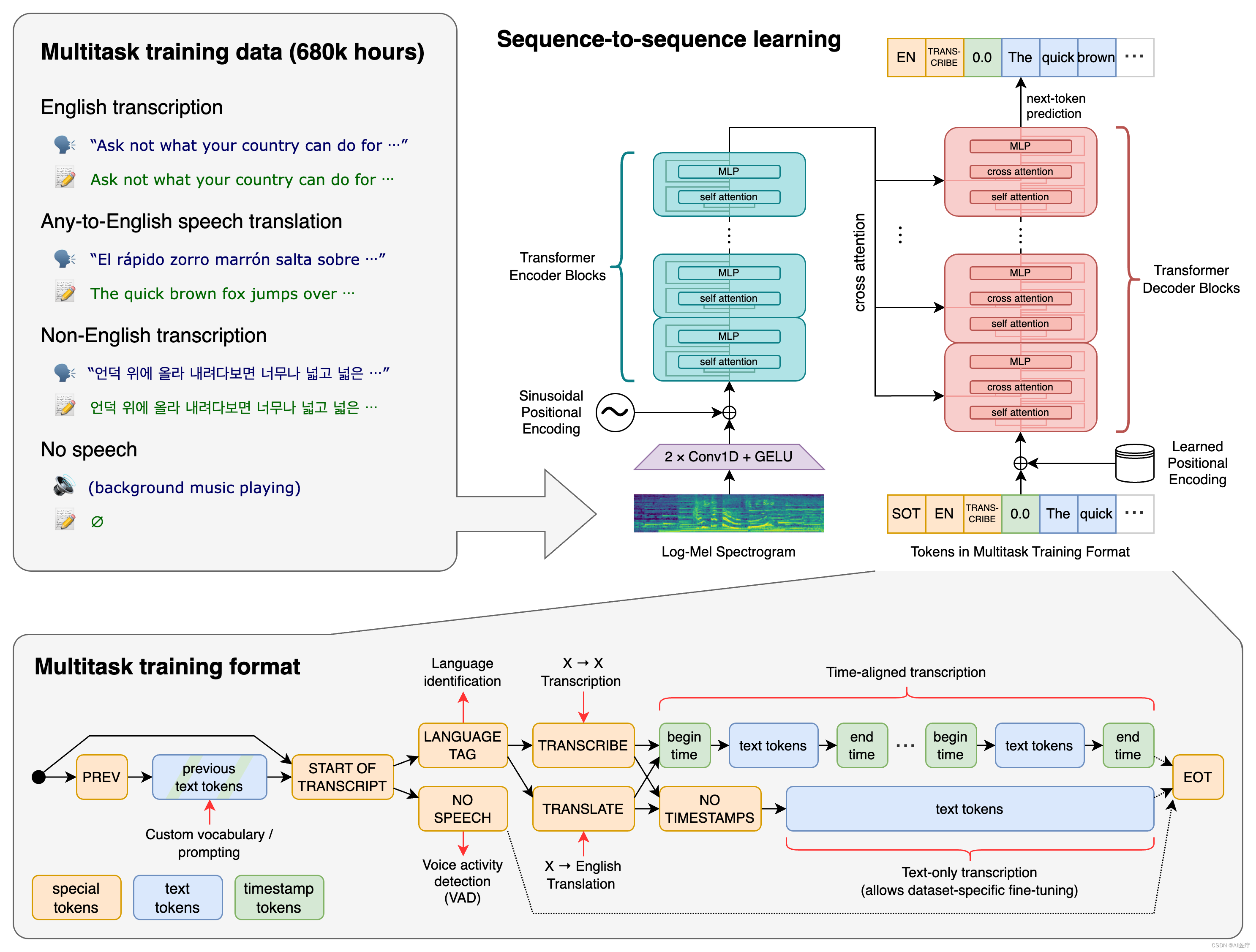

自动语音识别(Automatic Speech Recognition, ASR)是一种人工智能技术,它能将人类的语音信号转换为文本。自动语音识别技术广泛应用于智能家居、语音助手、语音搜索、语音控制等领域。在自动语音识别系统中,激活函数(Activation Function)是一种非线性函数,它在神经网络中扮演着重要的角色。本文将深入探讨激活函数在自动语音识别中的作用,并揭示其在神经网络中的核心原理。

2.核心概念与联系

2.1 激活函数的基本概念

激活函数是神经网络中的一个关键组件,它控制神经元在输入时是否激活,以及激活的程度。激活函数的主要作用是将神经元的输入映射到输出,使得神经网络具有非线性特性。常见的激活函数有sigmoid函数、tanh函数、ReLU函数等。

2.2 自动语音识别的基本概念

自动语音识别(ASR)是一种人工智能技术,它能将人类的语音信号转换为文本。自动语音识别系统主要包括以下几个模块:

- 语音采集模块:负责将人类的语音信号转换为电子信号。

- 特征提取模块:负责从语音信号中提取有意义的特征,如MFCC(Mel-frequency cepstral coefficients)。

- 语音识别模块:负责将特征信息转换为文本。

- 后处理模块:负责对识别结果进行修正和优化。

在自动语音识别系统中,神经网络技术广泛应用于语音识别模块,以提高识别准确率。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 激活函数的数学模型

3.1.1 Sigmoid函数

Sigmoid函数(S-型函数)是一种S形曲线,其数学模型如下:

$$ f(x) = \frac{1}{1 + e^{-x}} $$

其中,$e$ 是基数,$x$ 是输入值。Sigmoid函数的输出值范围在 [0, 1] 之间,表示概率。

3.1.2 Tanh函数

Tanh函数(双曲正弦函数)是一种S形曲线,其数学模型如下:

$$ f(x) = \frac{e^{x} - e^{-x}}{e^{x} + e^{-x}} $$

Tanh函数的输出值范围在 [-1, 1] 之间,表示偏置。

3.1.3 ReLU函数

ReLU函数(Rectified Linear Unit)是一种线性函数,其数学模型如下:

$$ f(x) = \max(0, x) $$

ReLU函数的输出值为正的时候保持原值,为负的时候输出为0。

3.2 自动语音识别中激活函数的应用

3.2.1 深度神经网络

在自动语音识别中,深度神经网络(Deep Neural Networks, DNN)是一种常用的神经网络结构。DNN包括多个隐藏层,每个隐藏层的神经元使用激活函数进行激活。常见的DNN结构包括:

- 卷积神经网络(Convolutional Neural Networks, CNN):主要应用于图像识别,但也可用于语音特征的提取和处理。

- 循环神经网络(Recurrent Neural Networks, RNN):主要应用于序列数据处理,如语音信号。

- 长短期记忆网络(Long Short-Term Memory, LSTM):是RNN的一种变体,能够更好地处理长期依赖关系。

3.2.2 激活函数的选择

在自动语音识别中,选择合适的激活函数对识别准确率的影响较大。常见的激活函数选择策略包括:

- 根据任务类型选择:对于需要输出概率的任务,可以选择Sigmoid或Softmax函数;对于需要处理正负值的任务,可以选择Tanh或ReLU函数。

- 根据神经网络结构选择:对于包含梯度消失问题的神经网络,可以选择ReLU或其变体(如Leaky ReLU、PReLU等);对于需要保持梯度连续性的神经网络,可以选择Tanh函数。

- 根据实验结果选择:通过实验比较不同激活函数在特定任务上的表现,选择最佳激活函数。

4.具体代码实例和详细解释说明

在本节中,我们以一个简单的卷积神经网络为例,展示如何在自动语音识别中使用激活函数。

```python import torch import torch.nn as nn import torch.optim as optim

class CNN(nn.Module): def init(self, inputchannels, outputclasses): super(CNN, self).init() self.conv1 = nn.Conv2d(inputchannels, 32, kernelsize=3, stride=1, padding=1) self.relu1 = nn.ReLU() self.conv2 = nn.Conv2d(32, 64, kernelsize=3, stride=1, padding=1) self.relu2 = nn.ReLU() self.fc1 = nn.Linear(64 * 16 * 16, 512) self.relu3 = nn.ReLU() self.fc2 = nn.Linear(512, outputclasses) self.softmax = nn.Softmax(dim=1)

def forward(self, x):

x = self.conv1(x)

x = self.relu1(x)

x = self.conv2(x)

x = self.relu2(x)

x = x.view(x.size(0), -1)

x = self.fc1(x)

x = self.relu3(x)

x = self.fc2(x)

x = self.softmax(x)

return x初始化网络、损失函数和优化器

inputchannels = 1 outputclasses = 10 model = CNN(inputchannels, outputclasses) criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001)

训练网络

for epoch in range(100): # 前向传播 outputs = model(inputs) loss = criterion(outputs, labels) # 后向传播和参数更新 optimizer.zero_grad() loss.backward() optimizer.step() ```

在上述代码中,我们定义了一个简单的卷积神经网络,其中包含两个卷积层和两个全连接层。激活函数包括ReLU函数(nn.ReLU())和Softmax函数(nn.Softmax(dim=1))。在训练过程中,我们使用了Adam优化器(optim.Adam)和交叉熵损失函数(nn.CrossEntropyLoss())。

5.未来发展趋势与挑战

自动语音识别技术的未来发展趋势主要集中在以下几个方面:

- 深度学习技术的不断发展,如Transformer、Autoencoder等,将为自动语音识别带来更高的准确率和更低的延迟。

- 数据增强技术的不断发展,如混合成像、音频增强等,将帮助解决有限数据集的问题,提高模型的泛化能力。

- 多模态技术的不断发展,如视觉语音融合、语音与文本融合等,将为自动语音识别提供更丰富的信息来源。

- 边缘计算技术的不断发展,如智能家居、自动驾驶等,将为自动语音识别带来更广泛的应用场景。

然而,自动语音识别技术仍然面临着一些挑战:

- 语音质量和环境的影响,如噪音、声音干扰等,可能导致识别准确率下降。

- 多语言和多方言的挑战,需要为各种语言和方言训练独立的模型。

- 语音数据的敏感性,如个人隐私、语言特征等,需要解决隐私和安全问题。

6.附录常见问题与解答

Q: 激活函数为什么必须是非线性的?

A: 激活函数必须是非线性的,因为线性函数无法捕捉到输入之间的复杂关系。非线性激活函数可以使神经网络具有更强的表示能力,从而更好地处理复杂的问题。

Q: 为什么Sigmoid函数在现代神经网络中较少使用?

A: Sigmoid函数在现代神经网络中较少使用,主要原因是它会导致梯度消失问题。梯度消失问题会使神经网络在训练过程中难以收敛,从而影响识别准确率。

Q: 如何选择合适的学习率?

A: 学习率是优化器的一个关键参数,它决定了模型参数在梯度下降过程中的更新速度。合适的学习率可以使模型在训练过程中更快地收敛。通常,可以通过试验不同学习率的值来选择最佳学习率。另外,可以使用学习率调整策略,如学习率衰减、Adam优化器等,以自动调整学习率。

Q: 如何解决过拟合问题?

A: 过拟合是指模型在训练数据上表现良好,但在测试数据上表现较差的现象。为解决过拟合问题,可以采取以下策略:文章来源:https://www.toymoban.com/news/detail-851564.html

- 增加训练数据:增加训练数据可以帮助模型更好地泛化到未知数据上。

- 减少模型复杂度:减少模型的参数数量,例如使用Dropout、正则化等技术。

- 使用更简单的模型:选择合适的模型结构,避免过度拟合。

在本文中,我们深入探讨了激活函数在自动语音识别中的作用,并揭示了其在神经网络中的核心原理。通过理解激活函数的数学模型、选择策略以及实际应用,我们可以更好地利用激活函数提高自动语音识别系统的准确率。同时,我们还分析了自动语音识别技术的未来发展趋势和挑战,为未来研究提供了启示。文章来源地址https://www.toymoban.com/news/detail-851564.html

到了这里,关于激活函数在自动语音识别中的作用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!