问题场景

1. 应用程序异常关闭导致Offset未提交

首先,Kafka Broker上存储的消息都有一个Offset的标记,然后Kafka的消费者是通过Offset这个标记来维护当前已经消费的一个数据的。消费者每消费一批数据,Kafka Broker就会更新OffSet的一个值,避免重复消费的一个问题。

默认情况下,消息消费完成以后,会自动提交Offset这样一个值,避免重复消费。

Kafka自动提交的逻辑里面,有一个默认5秒的一个间隔,也就是说在5秒之后的下一次向Broker去获取消息的时候来实现Offset的一个提交。所以在Consumer的消费过程中,应用程序强制被kill掉或者宕机的时候,可能会导致Offset没有提交,从而会产生重复消费的问题。

2. 消息量大导致Offset自动提交失败

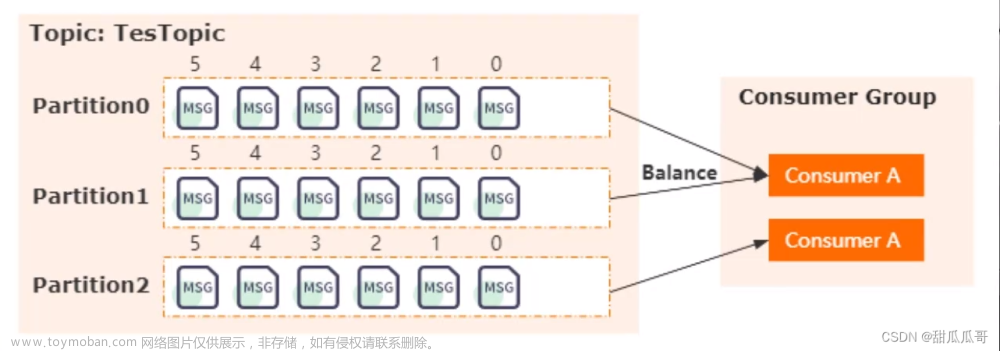

除此之外,还有另外一种情况也会出现重复消费,在Kafka里面有一个叫Partition Balance的一个机制,就是把多个Partition均衡地分配给多个消费者。那么Comsumer会从分配的Partition里面去消费消息。如果Consumer在默认的5分钟以内没办法处理完这一批消息的时候,就会触发Kafka的Rebalance的一个机制,从而导致Offset自动提交失败,而在重新Rebalance以后,Consumer端还是会从之前没有提交的Offset的位置开始去消费,从而去导致重复消费的一个问题。

解决方法

1. 提高消费端处理性能

提高消费端处理性能,避免触发Balance。

比如说我们可以用异步的方式来处理消息,缩短单个消息消费的时长。或者还可以调整消息处理的超时时间,我们可以将其调整得更长一些。同时还可以减少一次性从Broker上拉取数据的条数。

2. 生成md5用来判断是否消费过

可以针对每条消息生成md5然后保存到mysql或者redis里面,在处理消息之前先去mysql或者redis里面判断是否已经消费过。

判断是否已经存在相同的消息的md5值,如果存在那么就不需要去再消费了。

其实这个方法就是利用幂等性的这样一个思想来实现。文章来源:https://www.toymoban.com/news/detail-851801.html

参考资料:kafka怎么避免重复消费文章来源地址https://www.toymoban.com/news/detail-851801.html

到了这里,关于kafka怎么避免重复消费的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!