爬虫开发从0到1全知识教程完整教程(附代码资料)主要内容讲述:爬虫课程概要,爬虫基础爬虫概述, ,http协议复习。requests模块,requests模块1. requests模块介绍,2. response响应对象,3. requests模块发送请求,4. requests模块发送post请求,5. 利用requests.session进行状态保持。数据提取概要,数据提取概述1. 响应内容的分类,2. 认识xml以及和html的区别,1. jsonpath模块的使用场景,2. jsonpath模块的使用方法,3. jsonpath练习,1. 了解 lxml模块和xpath语法。Selenium课程概要selenium的介绍,selenium提取数据。Selenium课程概要,反爬与反反爬selenium的其它使用方法。反爬与反反爬常见的反爬手段和解决思路。反爬与反反爬验证码处理,chrome浏览器使用方法介绍。反爬与反反爬,Mongodb数据库JS的解析,介绍,内容,mongodb文档,Mongodb的介绍和安装,小结。Mongodb数据库介绍,内容,mongodb文档,mongodb的简单使用,小结,Mongodb的的增删改查。Mongodb数据库介绍,内容,mongodb文档,mongodb的聚合操作,2 mongodb的常用管道和表达式,Mongodb的索引操作。Mongodb数据库,scrapy爬虫框架介绍,内容,mongodb文档,mongodb和python交互,小结,介绍。scrapy爬虫框架,scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy的入门使用,小结,介绍。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy管道的使用,小结,scrapy的crawlspider爬虫。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy中间件的使用,小结,scrapy_redis概念作用和流程。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy_redis原理分析并实现断点续爬以及分布式爬虫,小结,scrapy_splash组件的使用。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy的日志信息与配置,小结,scrapyd部署scrapy项目。利用appium抓取app中的信息,利用appium抓取app中的信息介绍,内容,appium环境安装,介绍,内容,利用appium自动控制移动设备并提取数据。appium环境安装,Mongodb的介绍和安装,小结。scrapy的概念和流程 ,小结,selenium的介绍,常见的反爬手段和解决思路。数据提取概述1. 响应内容的分类,2. 认识xml以及和html的区别,爬虫概述,http协议复习。mongodb的简单使用,小结,scrapy的入门使用,小结。selenium提取数据,利用appium自动控制移动设备并提取数据。验证码处理。数据提取-jsonpath模块1. jsonpath模块的使用场景,2. jsonpath模块的使用方法,3. jsonpath练习,chrome浏览器使用方法介绍,Mongodb的的增删改查,小结。scrapy数据建模与请求,小结,selenium的其它使用方法。数据提取-lxml模块1. 了解 lxml模块和xpath语法,2. 谷歌浏览器xpath helper插件的安装和使用,3. xpath的节点关系,4. xpath语法-基础节点选择语法,5. xpath语法-节点修饰语法,6. xpath语法-其他常用节点选择语法。JS的解析,mongodb的聚合操作,2 mongodb的常用管道和表达式。scrapy模拟登陆,小结,Mongodb的索引操作,小结,scrapy管道的使用,小结。Mongodb的权限管理,小结,scrapy中间件的使用,小结。mongodb和python交互,小结,scrapy_redis概念作用和流程,小结,scrapy_redis原理分析并实现断点续爬以及分布式爬虫,小结。scrapy_splash组件的使用,小结,scrapy的日志信息与配置,小结。scrapyd部署scrapy项目,13.Gerapy,13.Gerapy。1.2.1-简单的代码实现,目标urlscrapy的crawlspider爬虫。

,http协议复习。requests模块,requests模块1. requests模块介绍,2. response响应对象,3. requests模块发送请求,4. requests模块发送post请求,5. 利用requests.session进行状态保持。数据提取概要,数据提取概述1. 响应内容的分类,2. 认识xml以及和html的区别,1. jsonpath模块的使用场景,2. jsonpath模块的使用方法,3. jsonpath练习,1. 了解 lxml模块和xpath语法。Selenium课程概要selenium的介绍,selenium提取数据。Selenium课程概要,反爬与反反爬selenium的其它使用方法。反爬与反反爬常见的反爬手段和解决思路。反爬与反反爬验证码处理,chrome浏览器使用方法介绍。反爬与反反爬,Mongodb数据库JS的解析,介绍,内容,mongodb文档,Mongodb的介绍和安装,小结。Mongodb数据库介绍,内容,mongodb文档,mongodb的简单使用,小结,Mongodb的的增删改查。Mongodb数据库介绍,内容,mongodb文档,mongodb的聚合操作,2 mongodb的常用管道和表达式,Mongodb的索引操作。Mongodb数据库,scrapy爬虫框架介绍,内容,mongodb文档,mongodb和python交互,小结,介绍。scrapy爬虫框架,scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy的入门使用,小结,介绍。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy管道的使用,小结,scrapy的crawlspider爬虫。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy中间件的使用,小结,scrapy_redis概念作用和流程。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy_redis原理分析并实现断点续爬以及分布式爬虫,小结,scrapy_splash组件的使用。scrapy爬虫框架介绍,内容,scrapy官方文档,scrapy的日志信息与配置,小结,scrapyd部署scrapy项目。利用appium抓取app中的信息,利用appium抓取app中的信息介绍,内容,appium环境安装,介绍,内容,利用appium自动控制移动设备并提取数据。appium环境安装,Mongodb的介绍和安装,小结。scrapy的概念和流程 ,小结,selenium的介绍,常见的反爬手段和解决思路。数据提取概述1. 响应内容的分类,2. 认识xml以及和html的区别,爬虫概述,http协议复习。mongodb的简单使用,小结,scrapy的入门使用,小结。selenium提取数据,利用appium自动控制移动设备并提取数据。验证码处理。数据提取-jsonpath模块1. jsonpath模块的使用场景,2. jsonpath模块的使用方法,3. jsonpath练习,chrome浏览器使用方法介绍,Mongodb的的增删改查,小结。scrapy数据建模与请求,小结,selenium的其它使用方法。数据提取-lxml模块1. 了解 lxml模块和xpath语法,2. 谷歌浏览器xpath helper插件的安装和使用,3. xpath的节点关系,4. xpath语法-基础节点选择语法,5. xpath语法-节点修饰语法,6. xpath语法-其他常用节点选择语法。JS的解析,mongodb的聚合操作,2 mongodb的常用管道和表达式。scrapy模拟登陆,小结,Mongodb的索引操作,小结,scrapy管道的使用,小结。Mongodb的权限管理,小结,scrapy中间件的使用,小结。mongodb和python交互,小结,scrapy_redis概念作用和流程,小结,scrapy_redis原理分析并实现断点续爬以及分布式爬虫,小结。scrapy_splash组件的使用,小结,scrapy的日志信息与配置,小结。scrapyd部署scrapy项目,13.Gerapy,13.Gerapy。1.2.1-简单的代码实现,目标urlscrapy的crawlspider爬虫。

全套笔记资料代码移步: 前往gitee仓库查看

感兴趣的小伙伴可以自取哦,欢迎大家点赞转发~

全套教程部分目录:

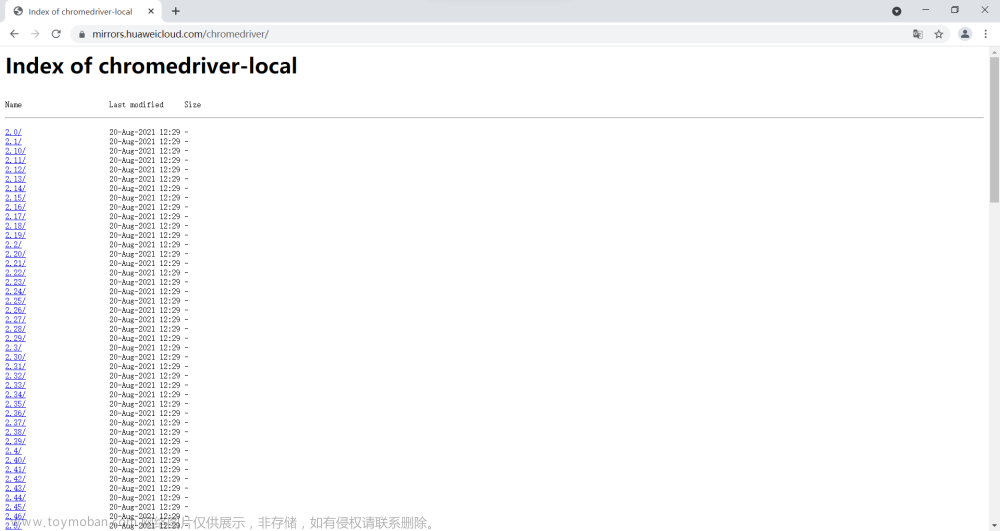

部分文件图片:

Selenium课程概要

本阶段课程主要学习selenium自动化测试框架在爬虫中的应用,selenium能够大幅降低爬虫的编写难度,但是也同样会大幅降低爬虫的爬取速度。在逼不得已的情况下我们可以使用selenium进行爬虫的编写。

selenium的其它使用方法

知识点:

- 掌握 selenium控制标签页的切换

- 掌握 selenium控制iframe的切换

- 掌握 利用selenium获取cookie的方法

- 掌握 手动实现页面等待

- 掌握 selenium控制浏览器执行js代码的方法

- 掌握 selenium开启无界面模式

- 了解 selenium使用ip

- 了解 selenium替换user-agent

1. selenium标签页的切换

当selenium控制浏览器打开多个标签页时,如何控制浏览器在不同的标签页中进行切换呢?需要我们做以下两步:

- 获取所有标签页的窗口句柄

-

利用窗口句柄字切换到句柄指向的标签页

-

这里的窗口句柄是指:指向标签页对象的标识

-

[关于句柄请课后了解更多,本小节不做展开](

-

具体的方法

# 1. 获取当前所有的标签页的句柄构成的列表

current_windows = driver.window_handles

# 2. 根据标签页句柄列表索引下标进行切换

driver.switch_to.window(current_windows[0])

- 参考代码示例:

import time

from selenium import webdriver

driver = webdriver.Chrome()

driver.get("

time.sleep(1)

driver.find_element_by_id('kw').send_keys('python')

time.sleep(1)

driver.find_element_by_id('su').click()

time.sleep(1)

# 通过执行js来新开一个标签页

js = 'window.open("

driver.execute_script(js)

time.sleep(1)

# 1. 获取当前所有的窗口

windows = driver.window_handles

time.sleep(2)

# 2. 根据窗口索引进行切换

driver.switch_to.window(windows[0])

time.sleep(2)

driver.switch_to.window(windows[1])

time.sleep(6)

driver.quit()

知识点:掌握 selenium控制标签页的切换

2. switch_to切换frame标签

iframe是html中常用的一种技术,即一个页面中嵌套了另一个网页,selenium默认是访问不了frame中的内容的,对应的解决思路是driver.switch_to.frame(frame_element)。接下来我们通过qq邮箱模拟登陆来学习这个知识点

- 参考代码:

import time

from selenium import webdriver

driver = webdriver.Chrome()

url = '

driver.get(url)

time.sleep(2)

login_frame = driver.find_element_by_id('login_frame') # 根据id定位 frame元素

driver.switch_to.frame(login_frame) # 转向到该frame中

driver.find_element_by_xpath('//*[@id="u"]').send_keys('1596930226@qq.com')

time.sleep(2)

driver.find_element_by_xpath('//*[@id="p"]').send_keys('hahamimashicuode')

time.sleep(2)

driver.find_element_by_xpath('//*[@id="login_button"]').click()

time.sleep(2)

"""操作frame外边的元素需要切换出去"""

windows = driver.window_handles

driver.switch_to.window(windows[0])

content = driver.find_element_by_class_name('login_pictures_title').text

print(content)

driver.quit()

-

总结:

-

切换到定位的frame标签嵌套的页面中

driver.switch_to.frame(通过find_element_by函数定位的frame、iframe标签对象)

-

利用切换标签页的方式切出frame标签

- ```python windows = driver.window_handles driver.switch_to.window(windows[0])

---

##### 知识点:掌握 selenium控制frame标签的切换

---

### 3. selenium对cookie的处理

>

selenium能够帮助我们处理页面中的cookie,比如获取、删除,接下来我们就学习这部分知识

#### 3.1 获取cookie

>

`driver.get_cookies()`返回列表,其中包含的是完整的cookie信息!不光有name、value,还有domain等cookie其他维度的信息。所以如果想要把获取的cookie信息和requests模块配合使用的话,需要转换为name、value作为键值对的cookie字典

```python

# 获取当前标签页的全部cookie信息

print(driver.get_cookies())

# 把cookie转化为字典

cookies_dict = {cookie[‘name’]: cookie[‘value’] for cookie in driver.get_cookies()}

3.2 删除cookie

#删除一条cookie

driver.delete_cookie("CookieName")

# 删除所有的cookie

driver.delete_all_cookies()

知识点:掌握 利用selenium获取cookie的方法

4. selenium控制浏览器执行js代码

selenium可以让浏览器执行我们规定的js代码,运行下列代码查看运行效果

import time

from selenium import webdriver

driver = webdriver.Chrome()

driver.get("

time.sleep(1)

js = 'window.scrollTo(0,document.body.scrollHeight)' # js语句

driver.execute_script(js) # 执行js的方法

time.sleep(5)

driver.quit()

- 执行js的方法:

driver.execute_script(js)

知识点:掌握 selenium控制浏览器执行js代码的方法

5. 页面等待

页面在加载的过程中需要花费时间等待网站服务器的响应,在这个过程中标签元素有可能还没有加载出来,是不可见的,如何处理这种情况呢?

- 页面等待分类

- 强制等待介绍

- 显式等待介绍

- 隐式等待介绍

- 手动实现页面等待

5.1 页面等待的分类

首先我们就来了解以下selenium页面等待的分类

- 强制等待

- 隐式等待

- 显式等待

5.2 强制等待(了解)

- 其实就是time.sleep()

- 缺点时不智能,设置的时间太短,元素还没有加载出来;设置的时间太长,则会浪费时间

5.3 隐式等待

-

隐式等待针对的是元素定位,隐式等待设置了一个时间,在一段时间内判断元素是否定位成功,如果完成了,就进行下一步

-

在设置的时间内没有定位成功,则会报超时加载

-

示例代码

from selenium import webdriver

driver = webdriver.Chrome()

driver.implicitly_wait(10) # 隐式等待,最长等20秒

driver.get('

driver.find_element_by_xpath()

5.4 显式等待(了解)

-

每经过多少秒就查看一次等待条件是否达成,如果达成就停止等待,继续执行后续代码

-

如果没有达成就继续等待直到超过规定的时间后,报超时异常

-

示例代码

from selenium import webdriver

from selenium.webdriver.support.wait import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.common.by import By

driver = webdriver.Chrome()

driver.get('

# 显式等待

WebDriverWait(driver, 20, 0.5).until(

EC.presence_of_element_located((By.LINK_TEXT, '好123')))

# 参数20表示最长等待20秒

# 参数0.5表示0.5秒检查一次规定的标签是否存在

# EC.presence_of_element_located((By.LINK_TEXT, '好123')) 表示通过链接文本内容定位标签

# 每0.5秒一次检查,通过链接文本内容定位标签是否存在,如果存在就向下继续执行;如果不存在,直到20秒上限就抛出异常

print(driver.find_element_by_link_text('好123').get_attribute('href'))

driver.quit()

5.5 手动实现页面等待

在了解了隐式等待和显式等待以及强制等待后,我们发现并没有一种通用的方法来解决页面等待的问题,比如“页面需要滑动才能触发ajax异步加载”的场景,那么接下来我们就以[淘宝网首页](

-

原理:

-

利用强制等待和显式等待的思路来手动实现

-

不停的判断或有次数限制的判断某一个标签对象是否加载完毕(是否存在)

-

实现代码如下:

import time

from selenium import webdriver

driver = webdriver.Chrome('/home/worker/Desktop/driver/chromedriver')

driver.get('

time.sleep(1)

# i = 0

# while True:

for i in range(10):

i += 1

try:

time.sleep(3)

element = driver.find_element_by_xpath('//div[@class="shop-inner"]/h3[1]/a')

print(element.get_attribute('href'))

break

except:

js = 'window.scrollTo(0, {})'.format(i*500) # js语句

driver.execute_script(js) # 执行js的方法

driver.quit()

知识点:掌握 手动实现页面等待

6. selenium开启无界面模式

绝大多数服务器是没有界面的,selenium控制谷歌浏览器也是存在无界面模式的,这一小节我们就来学习如何开启无界面模式(又称之为无头模式)

-

开启无界面模式的方法

-

实例化配置对象

options = webdriver.ChromeOptions()

-

配置对象添加开启无界面模式的命令

options.add_argument("--headless")

-

配置对象添加禁用gpu的命令

options.add_argument("--disable-gpu")

-

实例化带有配置对象的driver对象

driver = webdriver.Chrome(chrome_options=options)

-

注意:macos中chrome浏览器59+版本,Linux中57+版本才能使用无界面模式!

- 参考代码如下:

from selenium import webdriver

options = webdriver.ChromeOptions() # 创建一个配置对象

options.add_argument("--headless") # 开启无界面模式

options.add_argument("--disable-gpu") # 禁用gpu

# options.set_headles() # 无界面模式的另外一种开启方式

driver = webdriver.Chrome(chrome_options=options) # 实例化带有配置的driver对象

driver.get('

print(driver.title)

driver.quit()

知识点:掌握 selenium开启无界面模式

7. selenium使用ip

selenium控制浏览器也是可以使用ip的!

-

使用ip的方法

-

实例化配置对象

options = webdriver.ChromeOptions()

-

配置对象添加使用ip的命令

- `options.add_argument('--proxy-server=

-

实例化带有配置对象的driver对象

driver = webdriver.Chrome('./chromedriver', chrome_options=options)

-

参考代码如下:文章来源:https://www.toymoban.com/news/detail-852770.html

from selenium import webdriver

options = webdriver.ChromeOptions() # 创建一个配置对象

options.add_argument('--proxy-server= # 使用ip

driver = webdriver.Chrome(chrome_options=options) # 实例化带有配置的driver对象

driver.get('

print(driver.title)

driver.quit()

知识点:了解 selenium使用ip

8. selenium替换user-agent

selenium控制谷歌浏览器时,User-Agent默认是谷歌浏览器的,这一小节我们就来学习使用不同的User-Agent

-

替换user-agent的方法

-

实例化配置对象

options = webdriver.ChromeOptions()

-

配置对象添加替换UA的命令

options.add_argument('--user-agent=Mozilla/5.0 HAHA')

-

实例化带有配置对象的driver对象

driver = webdriver.Chrome('./chromedriver', chrome_options=options)

-

参考代码如下:

from selenium import webdriver

options = webdriver.ChromeOptions() # 创建一个配置对象

options.add_argument('--user-agent=Mozilla/5.0 HAHA') # 替换User-Agent

driver = webdriver.Chrome('./chromedriver', chrome_options=options)

driver.get('

print(driver.title)

driver.quit()

知识点:了解 selenium替换user-agent

反爬与反反爬

本阶段课程主要学习爬虫的反爬及应对方法。文章来源地址https://www.toymoban.com/news/detail-852770.html

未完待续, 同学们请等待下一期

全套笔记资料代码移步: 前往gitee仓库查看

感兴趣的小伙伴可以自取哦,欢迎大家点赞转发~

到了这里,关于【爬虫开发】爬虫从0到1全知识md笔记第5篇:Selenium课程概要,selenium的其它使用方法【附代码文档】的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!