简单一款不需要GPU就可以在Win 机器跑的模型:Ollama;用于本地运行和部署大型语言模型(LLMs)的开源工具

关于Ollama的简要介绍

- 平台兼容性:Ollama支持多种操作系统,包括macOS、Linux和Windows,这使得它在不同用户之间具有较好的可访问性。

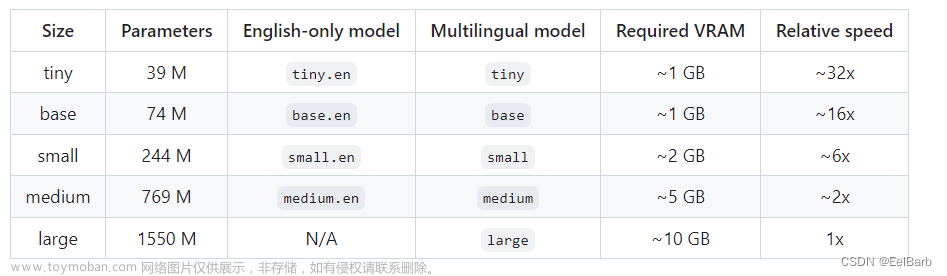

- 模型支持:它能够支持多种大型语言模型,如Llama 2、Code Llama、Gemma等,为用户提供了广泛的选择。

- 框架功能:Ollama提供了一个强大的框架,能够在Docker容器中管理LLMs的推理过程,这对于模型的隔离和性能优化非常有帮助。

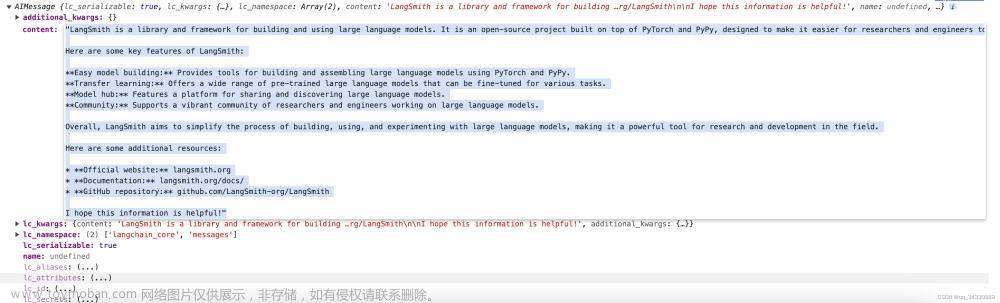

- API接口和聊天界面:它还提供了类似OpenAI的API接口和聊天界面,使得开发者可以更容易地集成和使用这些模型。

- 自定义模型:Ollama允许用户自定义和创建自己的模型,这为研究和开发特定应用提供了灵活性。

- 简化部署:Ollama简化了大型语言模型的安装和使用过程,使得即使是非专业人士也能较容易地部署和管理这些模型。

- 工具集成:它还支持与多种工具的集成,为用户提供了更多的操作便利性和功能性。

- 模型捆绑:Ollama将模型权重、配置和数据捆绑在一起,使得管理和使用变得更加高效。

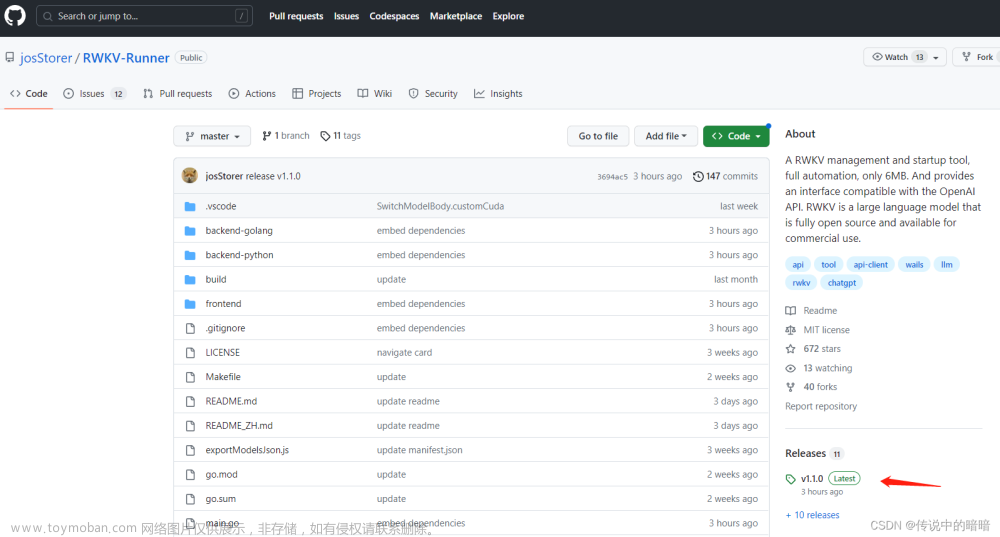

- 架构迁移:由于Llama架构的流行,Ollama的量化和推理能力能够无缝地迁移应用至相同架构的开源大语言模型,如阿里云的Qwen系列、零一万物的Yi系列等。

总的来说,Ollama是一个功能强大且用户友好的工具,它使得本地运行和部署大型语言模型变得更加简单和高效。无论是研究人员、开发者还是对AI感兴趣的普通用户,都可以通过Ollama来探索和应用大型语言模型的潜力。

运行方式:

在本地启动并运行大型语言模型

1 macOS地址:https://ollama.com/download/Ollama-darwin.zip

2 Windows地址:https://ollama.com/download/OllamaSetup.exe

3 Linux地址:curl -fsSL https://ollama.com/install.sh | sh

手头上有Win 机器,故使用window 进行尝试,执行步骤如下:

1 先下载上文链接地址 https://ollama.com/download/OllamaSetup.exe

2 运行命令:ollama run llama2

3 安装可视化过程,稍微有点慢,请耐心等待

4 开始使用如下所示:文章来源:https://www.toymoban.com/news/detail-853080.html

文章来源地址https://www.toymoban.com/news/detail-853080.html

文章来源地址https://www.toymoban.com/news/detail-853080.html

到了这里,关于不需要GPU就可以玩转模型,同时支持本地化部署的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!