【背景】

还是继续致力于实践可以保护数据隐私的本地化LLM部署。

这次用的是Llama 2 + GPT4All + Chroma实现RAG。文章来源:https://www.toymoban.com/news/detail-853517.html

【概念】

基于LangChain模板的各个部分的作用:文章来源地址https://www.toymoban.com/news/detail-853517.html

- Llama2-》语言模型管理

- GPT4ALL-》embedding

- Chroma-》文件内容的向量存储,作为内部知识库,不需要网络就可以存储。

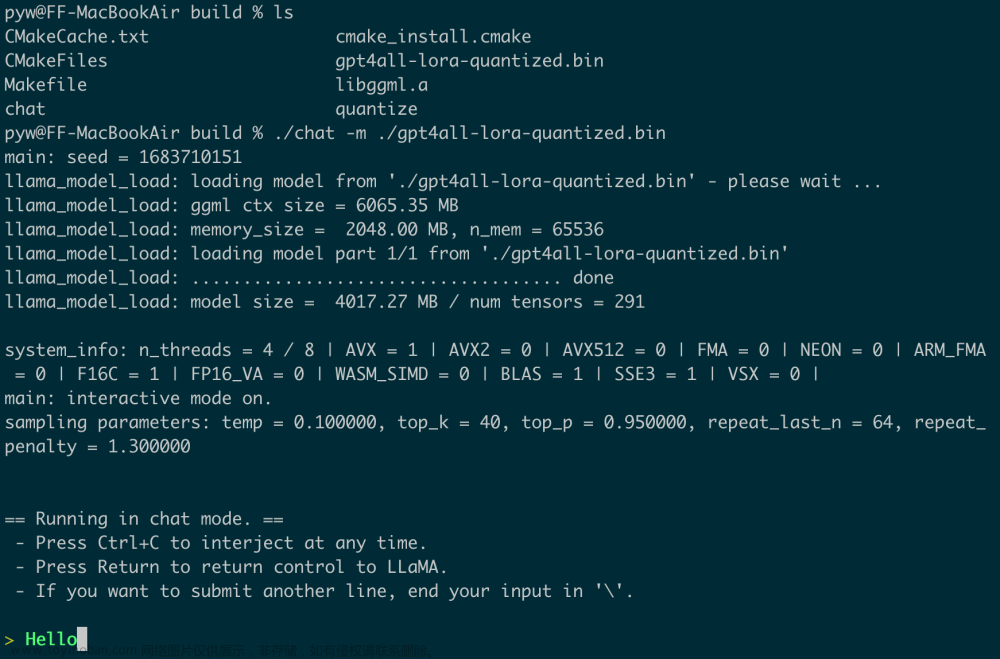

【环境构建】

- 安装Ollama

在Linux或Windows的WSL下,使用命令:

curl https://ollama.ai/install.sh | sh

- 利用Ollama下载一款LLM模型

比如,下载一个llama2 7b chat模型:

ollama pull llama2:7b-chat

- 安装LangChain命令行工具CLI:

pip install -U langchain-cli

到了这里,关于【AI】本地部署可以与文件沟通的GPT:Llama 2 + GPT4All + Chroma的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[最新搭建教程]0基础Linux CentOS7系统服务器本地安装部署ChatGPT模型服务搭建/免费域名绑定网页Https访问/调用open AI的API/GPT3/GPT3.5/GPT4模型接口](https://imgs.yssmx.com/Uploads/2024/02/499065-1.png)