一、前言

刚开始接触AI时,您可能会感到困惑,因为面对众多开源模型的选择,不知道应该选择哪个模型,也不知道如何调用最基本的模型。但是不用担心,我将陪伴您一起逐步入门,解决这些问题。

在信息时代,我们可以轻松地通过互联网获取大量的理论知识和概念。然而,仅仅掌握理论知识并不能真正帮助我们成长和进步。实践是将理论知识转化为实际技能和经验的关键。

本章将学习如何在低成本下,连续批处理提升LLM推理吞吐量,同时减少延迟。

二、术语

2.1. 批量推理

一次加载模型参数,然后使用它们来处理多个输入序列。这可以更有效地使用芯片的内存带宽,从而实现更高的计算利用率、更高的吞吐量和更低的 LLM 推理成本。

三、前置条件

3.1. windows or linux操作系统均可

3.2. 下载chatglm3-6b模型

从huggingface下载:https://huggingface.co/THUDM/chatglm3-6b/tree/main

从魔搭下载:魔搭社区汇聚各领域最先进的机器学习模型,提供模型探索体验、推理、训练、部署和应用的一站式服务。https://www.modelscope.cn/models/ZhipuAI/chatglm3-6b/fileshttps://www.modelscope.cn/models/ZhipuAI/chatglm3-6b/files

3.3. 创建虚拟环境&安装依赖

conda create --name chatglm3 python=3.10

conda activate chatglm3

pip install protobuf transformers==4.39.3 cpm_kernels torch>=2.0 sentencepiece accelerate四、技术实现

4.1. 完整代码

# -*- coding = utf-8 -*-

from typing import Optional, Union

from transformers import AutoTokenizer, LogitsProcessorList, AutoModelForCausalLM

modelPath = "/mnt1/model/chatglm3-6b"

def batch(

prompts: Union[str, list[str]],

max_length: int = 8192,

num_beams: int = 1,

do_sample: bool = True,

top_p: float = 0.8,

temperature: float = 0.8,

):

tokenizer.encode_special_tokens = True

if isinstance(prompts, str):

prompts = [prompts]

batched_inputs = tokenizer(prompts, return_tensors="pt", padding="longest")

print(batched_inputs)

batched_inputs = batched_inputs.to(model.device)

gen_kwargs = {

"max_length": max_length,

"num_beams": num_beams,

"do_sample": do_sample,

"top_p": top_p,

"temperature": temperature,

}

batched_outputs = model.generate(**batched_inputs, **gen_kwargs)

batched_response = []

for input_ids, output_ids in zip(batched_inputs.input_ids, batched_outputs):

decoded_text = tokenizer.decode(output_ids[len(input_ids):])

batched_response.append(decoded_text.strip())

return batched_response

def main(batch_queries):

gen_kwargs = {

"max_length": 8192,

"do_sample": True,

"top_p": 0.9,

"temperature": 0.45,

"num_beams": 1,

}

batch_responses = batch( batch_queries, **gen_kwargs)

return batch_responses

def loadTokenizer():

tokenizer = AutoTokenizer.from_pretrained(modelPath, use_fast=False, trust_remote_code=True)

return tokenizer

def loadModel():

model = AutoModelForCausalLM.from_pretrained(modelPath, device_map="auto", trust_remote_code=True).cuda()

model = model.eval()

# print(model)

return model

if __name__ == "__main__":

model = loadModel()

tokenizer = loadTokenizer()

batch_queries = [

"<|user|>\n广州有什么特产\n<|assistant|>",

"<|user|>\n东莞有什么特产\n<|assistant|>",

"<|user|>\n韶关有什么景点\n<|assistant|>",

"<|user|>\n深圳有什么景点\n<|assistant|>",

]

batch_responses = main(batch_queries)

for response in batch_responses:

print("=" * 10)

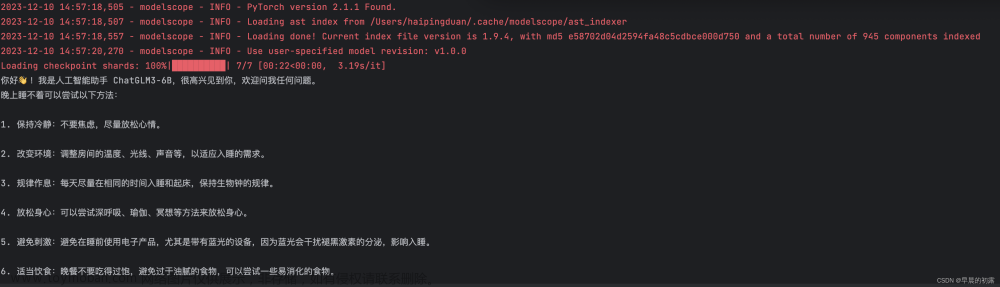

print(response)调用结果:

通过表格展示模型生成结果:

| 序号 | user | assistant |

|---|---|---|

| 1 | <|user|>\n广州有什么特产\n<|assistant|> | 广州作为我国南方的大城市,拥有丰富的特产。以下是一些著名的广州特产:1. 广式早茶:广州的早茶文化悠久,品种丰富,如虾饺、烧卖、肠粉、凤爪等。2. 广式点心:有蛋挞、莲蓉包、马蹄糕、糯米鸡等。3. 广式糖水:如红豆糖水、绿豆糖水、莲子糖水等。4. 广式奶茶:在华南地区非常受欢迎,以香浓为特点。5. 广式水果:如荔枝、菠萝包、木瓜、火龙果等。6. 广式美食:如叉烧包、烧鹅、白切鸡、梅菜扣肉等。7. 广式糖果:如鱼翅糖、虫草花糖、六仔糖等。8. 广式茶叶:如铁观音、普洱茶、广州花茶等。9. 广式凉菜:如凉拌海蜇、蒜泥白肉、夫妻肺片等。10. 广式糕点:如绿豆糕、芝麻饼、蛋黄酥等。这些特产可以在广州的各大商场、购物中心、特产店以及一些大型超市购买到。同时,您也可以通过网购平台购买到广州特产。 |

| 2 | <|user|>\n东莞有什么特产\n<|assistant|> | 东莞是中国广东省的一个城市,拥有丰富的文化和历史,同时也是一个著名的制造业中心。因此,东莞的特产主要包括各种手工艺品、家具、电子设备等工业产品。此外,东莞还有一些美食和特色小吃,如烧腊、糖水、糯米鸡等。 |

| 3 | <|user|>\n韶关有什么景点\n<|assistant|> | 韶关是中国广东省的一个地级市,拥有丰富的旅游资源,包括以下景点:1. 韶关市博物馆:韶关市博物馆是一座以韶关历史文化为主要展示内容的博物馆,展示了韶关的历史、文化、艺术和社会风俗等方面的内容。2. 韶关市人民广场:韶关市人民广场是韶关市中心的一个公共广场,是韶关市民休闲、娱乐和活动的重要场所。3. 韶关市第一中学:韶关市第一中学是韶关市的一所重点中学,有着悠久的历史和优良的教育传统。4. 韶关市皮肤病医院:韶关市皮肤病医院是一家专业治疗皮肤病的医院,提供各种皮肤病的诊断和治疗服务。5. 韶关市皮肤病医院附近的中山公园:中山公园是韶关市皮肤病医院附近的一个公共公园,提供休闲、娱乐和活动场所。6. 韶关市韶州古城:韶州古城是韶关市的一个历史悠久的古城,有着丰富的历史文化遗产。7. 韶关市乳源瑶族自治县:韶关市乳源瑶族自治县是韶关市下辖的一个瑶族自治县,有着独特的瑶族文化和风情。8. 韶关市乳源瑶族自治县的大王峰景区:大王峰景区是乳源瑶族自治县的一个风景名胜区,有着壮丽的山水和独特的瑶族文化。9. 韶关市乳源瑶族自治县的大王峰景区附近的大王寺:大王寺是大王峰景区附近的一座古寺,有着悠久的历史和独特的文化底蕴。10. 韶关市乳源瑶族自治县的大王峰景区附近的瑶族风情村:瑶族风情村是乳源瑶族自治县的一个民俗文化村,展示了瑶族的风俗、习惯和传统文化。 |

| 4 | <|user|>\n深圳有什么景点\n<|assistant|> | 深圳是一个充满活力和创新精神的城市,拥有许多著名的旅游景点,以下是一些值得一游的景点:1. 深圳世界之窗:集世界各地著名景观和建筑于一身的大型主题公园,游客可以在一天之内领略世界各地的文化和风光。2. 深圳欢乐谷:是一个集休闲、娱乐、度假为一体的大型主题公园,拥有刺激的过山车、海盗船等游乐设施。3. 深圳大梅沙海滨公园:是深圳著名的海滨度假胜地,拥有优美的沙滩和清澈的海水,适合度假、海滨游玩。4. 深圳莲花山公园:位于深圳市中心,是一个城市绿洲,拥有美丽的莲花山和各种雕塑、喷泉等景观。5. 深圳锦绣中华民俗村:是一个大型的民俗文化主题公园,游客可以领略到中国各地的传统民俗文化、建筑和表演。6. 深圳东部华侨城:包括大梅沙海滨公园、茶溪谷、生态广场等多个景区,游客可以欣赏自然风光、品尝美食、观赏表演等。7. 深圳华侨城创意园:是一个以创意为主题的公园,拥有独特的建筑和景观,适合拍照、休闲和创意产业相关的活动。8. 深圳深圳湾公园:是一个位于深圳湾的公园,可以欣赏到深圳湾跨海大桥的美丽景色和深圳湾公园的美景。9. 深圳香蜜湖公园:是一个美丽的城市湖泊公园,适合散步、骑车、划船等户外活动。10. 深圳东部华侨城中华民俗村:是一个大型的民俗文化主题公园,游客可以领略到中国各地的传统民俗文化、建筑和表演。以上只是深圳众多景点中的一部分,实际上深圳还有很多其他值得一游的景点,如深圳水围村、深圳东部华侨城茶溪谷、深圳大梅沙水上世界等。 |

五、附带说明

5.1. 批量推理的输入序列格式

- "<|user|>\n广州有什么特产\n<|assistant|>"

- "<|user|>\n东莞有什么特产\n<|assistant|>"

- "<|user|>\n韶关有什么景点\n<|assistant|>"

- "<|user|>\n深圳有什么景点\n<|assistant|>"

上述prompts经过tokenizer处理后:文章来源:https://www.toymoban.com/news/detail-853879.html

{'input_ids': tensor([[ 0, 64790, 64792, 64795, 30910, 13, 32528, 33277, 45645, 13, 64796],

[ 0, 64790, 64792, 64795, 30910, 13, 36705, 33277, 45645, 13, 64796],

[64790, 64792, 64795, 30910, 13, 57712, 54637, 33277, 35180, 13, 64796],

[ 0, 64790, 64792, 64795, 30910, 13, 32370, 33277, 35180, 13, 64796]]),

'attention_mask': tensor([[0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1],

[0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1],

[1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1],

[0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]]),

'position_ids': tensor([[ 0, 0, 1, 2, 3, 4, 5, 6, 7, 8, 9],

[ 0, 0, 1, 2, 3, 4, 5, 6, 7, 8, 9],

[ 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10],

[ 0, 0, 1, 2, 3, 4, 5, 6, 7, 8, 9]])}5.2. 生成结果多样性

上面示例生成的结果受到模型参数的影响,可以通过调整temperature值来改变结果的多样性和随机性。较低的temperature值会使生成的结果更加确定和保守,更加倾向于选择高概率的预测。而较高的temperature值会使生成的结果更加多样化和随机,更容易选择低概率的预测。所以,通过调整temperature值,可以控制生成结果的风格和变化程度。文章来源地址https://www.toymoban.com/news/detail-853879.html

到了这里,关于开源模型应用落地-chatglm3-6b-批量推理-入门篇(四)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!