Motivation

- 信息的全局处理会帮助提高整体深度估计。

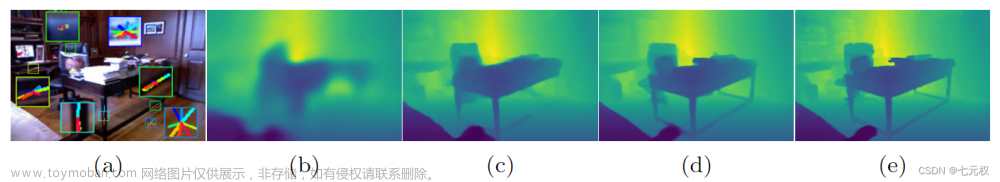

- 提出的AdaBins预测的bin中心集中在较小的深度值附近,对于深度值范围更广的图像,分布广泛。

- Fu et al. 发现将深度回归任务转化为分类任务可以提升效果,将深度范围分成固定数量的bins。本文则解决了原始方法的多个限制:

- 计算根据输入场景的特征动态变化的自适应箱。

- 分类方法导致深度值的离散化,导致视觉质量差,深度不连续明显,论文提出预测最终的深度值作为bin中心的线性组合。

- 以高分辨率全局计算信息,而不是主要是在低分辨率的瓶颈部分。

文章来源地址https://www.toymoban.com/news/detail-854281.html

文章来源地址https://www.toymoban.com/news/detail-854281.html

AdaBins design

- 首先,我们采用一个适应性分箱策略把具体的深度区间 D = ( d m i n , d m a x ) D=(d_{min},d_{max}) D=(dmin,dmax)分成N bins。

- 我们将最终深度预测为 bin 中心的线性组合,使模型能够估计平滑变化的深度值。

- 当在空间更高分辨率的张量上使用注意力时,可以获得更好的结果。因此采用了这样的结构: Encoder, Decoder, and finally attention。

- 由于内存限制,使用h=H/2,w=W/2的空间分辨率处理,最终的depth图像通过简单的bilinearly上采样到(H,W)。

- AdaBins的第一个模块是miniViT.输出:1) 向量 b , 定义了它如何将深度区间D划分为输入图像。2)Range-Attention 图 R \mathcal{R} R,形状是 h × w × C h \times w \times C h×w×C, 包含了像素级深度计算信息。

-

Bin-widths: 使用MLP头和ReLU层输出N维(bin的数量)向量b’。最后通过Softmax归一化b‘。

b i = b i ′ + ϵ ∑ j = 1 N ( b j ′ + ϵ ) b_i = \frac{b'_i + \epsilon}{\sum^N_{j=1}(b'_j + \epsilon)} bi=∑j=1N(bj′+ϵ)bi′+ϵ - Range attention maps: Transformer中包含了更多的全局信息。来自转换器的output embedding (2,C+1)作用一组1x1的卷积核,并与解码器的特征卷积获得 R \mathcal{R} R。这相当于将pixel-wise 特征视为’keys’, transformer output embedding相当于’queries’。

-

Hybrid regression:

R \mathcal{R} R 通过 1 × 1 卷积层获得 N 个通道,然后通过 Softmax。每个像素每个通道的数值作为这个bin的概率,每个depth-bin-centers可以算为:

c ( b i ) = d ( m i n ) + ( d m a x − d m i n ) ( b i / 2 + ∑ j = 1 i + 1 b j ) c(b_i) = d_(min) + (d_{max} - d_{min})(b_i/2 + \sum^{i+1}_{j=1}b_j) c(bi)=d(min)+(dmax−dmin)(bi/2+∑j=1i+1bj)

最后,对于每一个pixel, 最终的 d ~ \tilde{d} d~计算为线性组合 c ( b i ) c(b_i) c(bi),

d ~ = ∑ k = 1 N c ( b k ) p k \tilde{d}= \sum^N_{k=1}c(b_k)p_k d~=∑k=1Nc(bk)pk。

Loss function

- Pixel-wise depth loss. 使用一个尺度不变损失 (SI) 的缩放版本:

- g i = l o g d ~ i − l o g d i g_i = log \tilde{d}_i - log d_i gi=logd~i−logdi。

- Bin-center density loss: 鼓励bin centers的分布与真实标签相同。我们将 bin 中心的集合表示为 c(b),将地面实况图像中所有深度值的集合表示为 X,并使用双向倒角损失 [9] 作为正则化器:

Reference

- [1]FU H, GONG M, WANG C, et al. Deep Ordinal Regression Network for Monocular Depth Estimation[C/OL]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT. 2018. http://dx.doi.org/10.1109/cvpr.2018.00214. DOI:10.1109/cvpr.2018.00214.

文章来源:https://www.toymoban.com/news/detail-854281.html

到了这里,关于论文阅读:AdaBins: Depth Estimation using Adaptive Bins的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读笔记23]Adaptive Sparse Convolutional Networks with Global Context Enhancement for ... on drone](https://imgs.yssmx.com/Uploads/2024/02/763326-1.png)