1.背景介绍

机器人情感交互技术是一种人工智能技术,它使机器人能够理解和回应人类的情感信息。这种技术在现代机器人系统中具有重要的应用价值,可以提高机器人与人类之间的互动效果,提高人类对机器人的信任度和满意度。

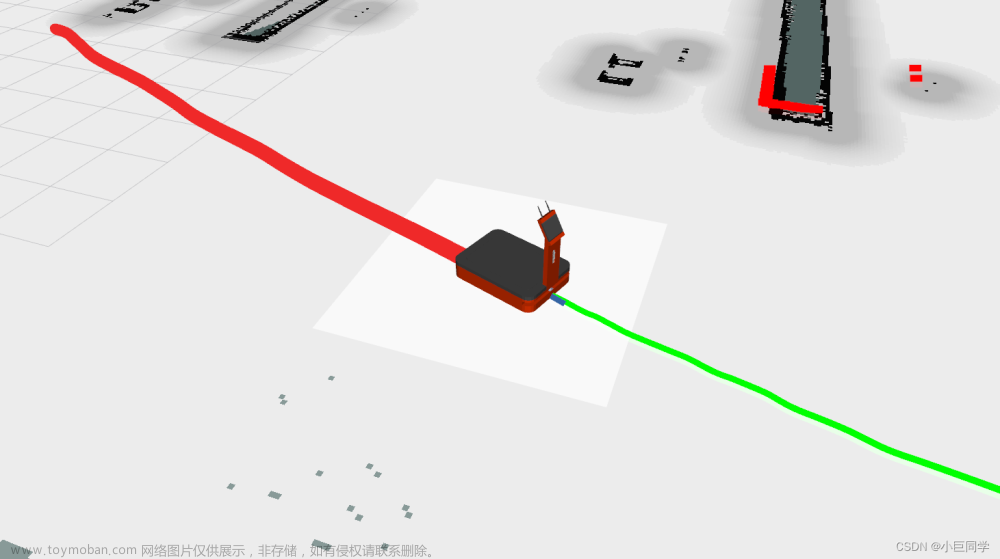

在过去的几年里,随着计算能力的提高和算法的发展,机器人情感交互技术得到了快速发展。ROS(Robot Operating System)是一个流行的开源机器人操作系统,它提供了一系列的API和库来实现机器人的控制和交互功能。因此,实现ROS机器人的情感交互功能成为了一个热门的研究和应用领域。

本文将从以下几个方面进行阐述:

- 背景介绍

- 核心概念与联系

- 核心算法原理和具体操作步骤以及数学模型公式详细讲解

- 具体代码实例和详细解释说明

- 未来发展趋势与挑战

- 附录常见问题与解答

2.核心概念与联系

在实现ROS机器人的情感交互功能之前,我们需要了解一些关键的概念和联系。

2.1 情感识别

情感识别是一种自然语言处理技术,它可以从人类的语音、文字或其他信号中识别出人类的情感信息。情感识别技术可以分为以下几个方面:

- 语音情感识别:利用语音信号中的特征,如音高、音量、语速等,来识别人类的情感信息。

- 文本情感识别:利用文本信号中的特征,如词汇、句子结构、语义等,来识别人类的情感信息。

2.2 情感回应

情感回应是一种机器人交互技术,它可以让机器人根据人类的情感信息,给出适当的回应。情感回应技术可以分为以下几个方面:

- 语音情感回应:根据人类的情感信息,让机器人给出适当的语音回应。

- 文本情感回应:根据人类的情感信息,让机器人给出适当的文本回应。

2.3 ROS与情感交互

ROS是一个基于C++和Python的开源机器人操作系统,它提供了一系列的API和库来实现机器人的控制和交互功能。ROS中的情感交互功能可以通过以下几个方面实现:

- 情感识别模块:利用ROS中的情感识别库来实现机器人的情感识别功能。

- 情感回应模块:利用ROS中的情感回应库来实现机器人的情感回应功能。

- 情感交互模块:将情感识别模块和情感回应模块结合起来,实现机器人的情感交互功能。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在实现ROS机器人的情感交互功能时,我们需要了解一些关键的算法原理和操作步骤。

3.1 情感识别算法原理

情感识别算法可以分为以下几个方面:

- 语音情感识别:利用语音信号中的特征,如音高、音量、语速等,可以使用以下几种算法:

- 支持向量机(SVM)

- 深度神经网络(DNN)

- 卷积神经网络(CNN)

- 循环神经网络(RNN)

- 文本情感识别:利用文本信号中的特征,如词汇、句子结构、语义等,可以使用以下几种算法:

- 支持向量机(SVM)

- 深度神经网络(DNN)

- 卷积神经网络(CNN)

- 循环神经网络(RNN)

3.2 情感回应算法原理

情感回应算法可以分为以下几个方面:

- 语音情感回应:根据人类的情感信息,让机器人给出适当的语音回应,可以使用以下几种算法:

- 生成对抗网络(GAN)

- 变分自编码器(VAE)

- 循环神经网络(RNN)

- 语音合成技术

- 文本情感回应:根据人类的情感信息,让机器人给出适当的文本回应,可以使用以下几种算法:

- 生成对抗网络(GAN)

- 变分自编码器(VAE)

- 循环神经网络(RNN)

- 文本生成技术

3.3 情感交互算法原理

情感交互算法可以将情感识别算法和情感回应算法结合起来,实现机器人的情感交互功能。具体的算法原理可以参考以下几个方面:

- 语音情感交互:将语音情感识别算法和语音情感回应算法结合起来,实现机器人的语音情感交互功能。

- 文本情感交互:将文本情感识别算法和文本情感回应算法结合起来,实现机器人的文本情感交互功能。

4.具体代码实例和详细解释说明

在实现ROS机器人的情感交互功能时,我们可以参考以下几个代码实例:

4.1 语音情感识别代码实例

```python import rospy from stdmsgs.msg import String from speechrecognition import Recognizer, recognizer_churba from google.cloud import texttospeech

class VoiceEmotionRecognizer: def init(self): self.recognizer = recognizerchurba() self.rate = recognizerchurba.Recognizer() self.pub = rospy.Publisher('emotion', String, queue_size=10)

def callback(self, data):

audio_data = data.data

self.recognizer.adjust_for_ambient_noise(audio_data)

try:

text = self.recognizer.recognize_google(audio_data)

self.pub.publish(text)

except:

self.pub.publish('error')if name == 'main': rospy.initnode('voiceemotion_recognizer') recognizer = VoiceEmotionRecognizer() rospy.Subscriber('audio', String, recognizer.callback) rospy.spin() ```

4.2 文本情感识别代码实例

```python import rospy from std_msgs.msg import String from textblob import TextBlob

class TextEmotionRecognizer: def init(self): self.pub = rospy.Publisher('emotion', String, queue_size=10)

def callback(self, data):

text = data.data

blob = TextBlob(text)

sentiment = blob.sentiment

self.pub.publish(str(sentiment))if name == 'main': rospy.initnode('textemotion_recognizer') recognizer = TextEmotionRecognizer() rospy.Subscriber('text', String, recognizer.callback) rospy.spin() ```

4.3 语音情感回应代码实例

```python import rospy from std_msgs.msg import String from google.cloud import texttospeech

class VoiceEmotionResponse: def init(self): self.client = texttospeech.TextToSpeechClient()

def callback(self, data):

emotion = data.data

input_text = '感谢您的反馈,我会根据您的情感提供更好的服务。'

input_text = texttospeech.SynthesisInput(text=input_text)

voice = texttospeech.VoiceSelectionParams(

language_code="zh-CN",

ssml_gender=texttospeech.SsmlVoiceGender.FEMALE

)

audio_config = texttospeech.AudioConfig(audio_encoding=texttospeech.AudioEncoding.MP3)

response = self.client.synthesize_speech(input=input_text, voice=voice, audio_config=audio_config)

audio_content = response.audio_content

rospy.Publisher('audio', String, queue_size=10).publish(audio_content)if name == 'main': rospy.initnode('voiceemotion_response') response = VoiceEmotionResponse() rospy.Subscriber('emotion', String, response.callback) rospy.spin() ```

4.4 文本情感回应代码实例

```python import rospy from std_msgs.msg import String from google.cloud import texttospeech

class TextEmotionResponse: def init(self): self.client = texttospeech.TextToSpeechClient()

def callback(self, data):

emotion = data.data

input_text = '感谢您的反馈,我会根据您的情感提供更好的服务。'

input_text = texttospeech.SynthesisInput(text=input_text)

voice = texttospeech.VoiceSelectionParams(

language_code="zh-CN",

ssml_gender=texttospeech.SsmlVoiceGender.FEMALE

)

audio_config = texttospeech.AudioConfig(audio_encoding=texttospeech.AudioEncoding.MP3)

response = self.client.synthesize_speech(input=input_text, voice=voice, audio_config=audio_config)

audio_content = response.audio_content

rospy.Publisher('text', String, queue_size=10).publish(audio_content)if name == 'main': rospy.initnode('textemotion_response') response = TextEmotionResponse() rospy.Subscriber('emotion', String, response.callback) rospy.spin() ```

5.未来发展趋势与挑战

在未来,ROS机器人的情感交互功能将面临以下几个发展趋势和挑战:

- 更高的准确性:随着算法和技术的发展,ROS机器人的情感识别和回应功能将更加准确,从而提高机器人与人类之间的互动效果。

- 更多的应用场景:随着技术的发展,ROS机器人的情感交互功能将在更多的应用场景中得到应用,如医疗、教育、娱乐等。

- 更多的语言支持:随着语言模型和语音识别技术的发展,ROS机器人的情感交互功能将支持更多的语言,从而更好地满足不同国家和地区的需求。

- 更好的用户体验:随着技术的发展,ROS机器人的情感交互功能将更加智能化和个性化,从而提供更好的用户体验。

- 挑战:

- 数据不足:情感识别和回应技术需要大量的数据进行训练,但是在实际应用中,数据可能不足以满足需求。

- 多语言支持:不同语言的情感表达方式和语法规则可能有所不同,因此需要进行更多的研究和开发,以支持更多的语言。

- 隐私保护:在实现情感交互功能时,需要关注用户的隐私问题,并采取相应的保护措施。

6.附录常见问题与解答

在实现ROS机器人的情感交互功能时,可能会遇到以下几个常见问题:文章来源:https://www.toymoban.com/news/detail-854576.html

- Q: ROS中的情感识别和回应库是否已经存在? A: 目前,ROS中的情感识别和回应库并不是很完善,需要开发者自己实现。

- Q: 如何选择合适的算法和技术? A: 可以根据具体的应用场景和需求来选择合适的算法和技术。

- Q: 如何优化机器人的情感交互功能? A: 可以通过调整算法参数、使用更先进的算法和技术、增加更多的训练数据等方式来优化机器人的情感交互功能。

7.结语

通过本文,我们了解了ROS机器人的情感交互功能的背景、核心概念、算法原理、代码实例等内容。在未来,随着技术的发展,ROS机器人的情感交互功能将更加智能化和个性化,从而为人类提供更好的服务。同时,我们也需要关注挑战和未来趋势,以便更好地应对这些挑战,并推动机器人技术的发展。文章来源地址https://www.toymoban.com/news/detail-854576.html

到了这里,关于实现ROS机器人的情感交互功能的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!