摘要

在强化学习( RL )中有效地利用以前收集的大量数据集是大规模实际应用的关键挑战。离线RL算法承诺从先前收集的静态数据集中学习有效的策略,而无需进一步的交互。然而,在实际应用中,离线RL是一个主要的挑战,标准的离线RL方法可能会由于数据集和学习到的策略之间的分布偏移而导致的过高估计,特别是在复杂和多模态数据分布上的训练时。在本文中,我们提出了保守Q学习( CQL ),旨在通过学习一个保守的Q函数来解决这些限制,使得一个策略在这个Q函数下的期望值低于其真实值。我们从理论上证明了CQL对现行策略的价值产生了一个下界,可以将其纳入到一个具有理论改进保证的政策学习过程中。在实际应用中,CQL通过一个简单的Q值正则化器来增强标准的贝尔曼错误目标,该正则化器在现有的深度Q学习和行动者-评论家实现的基础上更易于实现。在离散和连续控制域上,我们都表明CQL显著优于现有的离线强化学习方法,通常学习策略可以获得2 ~ 5倍的最终回报,特别是在从复杂和多模态数据分布中学习时。

论文概述

本文主要介绍了一个名为Conservative Q-Learning (CQL)的离线强化学习算法,该算法旨在克服现有离线强化学习算法在数据分布与学习策略之间存在差异时可能导致的过度估计问题。CQL通过学习一个保守的Q函数来解决这个问题,从而为离线强化学习提供了一种有效的解决方案。此外,本文还讨论了CQL的理论性质以及在各种控制领域的实验表现。

The Conservative Q-Learning (CQL) Framework(保守Q学习( Cql )框架)

保守离策略评估:

理论分析表明,CQL通过在训练过程中正则化Q值来学习一个保守的Q函数,使得该Q函数下界估计策略的真实值。

保守Q学习在离线RL中的应用:

通过将CQL应用于离线RL,可以从之前收集的静态数据集中学习有效策略,而无需进一步与环境互动。

保守策略改进保证:

理论分析证明,CQL生成的策略更新在优化过程中是“保守”的,意味着每个后续策略迭代都是根据其值的下界估计进行优化的。

实际算法和实现细节:

实际上,CQL可以通过在现有的深度Q学习和actor-critic实现上添加CQL正则化项来实现,代码量少于20行。

实验评估:

在多个领域和数据集组成上,CQL在离线RL方法方面表现优越,尤其是在学习复杂多模态数据分布时。CQL经常比现有的离线RL方法学到的策略获得2-5倍的最终回报。

-

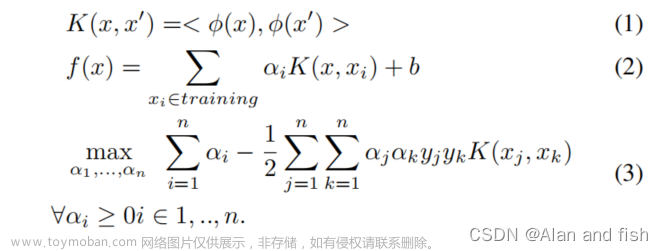

Conservative Off-Policy Evaluation

在这部分中,作者讨论了如何通过在训练过程中对Q值进行正则化来学习保守的Q函数。这个保守的Q函数的期望值在给定策略下能够下界估计真实的策略值。作者的理论分析表明,CQL产生的值是当前策略的下界,并且可以将其纳入一个具有理论改进保证的策略学习过程中。

-

Conservative Q-Learning for Offline RL

在这部分中,作者讨论了CQL家族中的两个特殊实例,并在第6节中进行了实证评估。首先,如果R(µ)是与先验分布ρ(a|s)的KL散度,即R(µ) = -D_KL(µ, ρ),那么我们得到µ(a|s)∝ρ(a|s)·exp(Q(s, a))(请参考附录A中的推导)。此外,作者还讨论了CQL的实证性能以及与其他离线RL方法的比较。文章来源:https://www.toymoban.com/news/detail-854766.html

-

Safe Policy Improvement Guarantees

在这部分中,作者定义了任何策略π的经验回报,然后证明了CQL优化了一个带有惩罚的RL经验目标。接下来,作者构建了CQL的安全策略改进保证,证明了CQL在实际MDP中提供了ζ安全的策略改进。最后,作者讨论了CQL在不同场景下的实证性能以及与其他离线RL方法的比较。文章来源地址https://www.toymoban.com/news/detail-854766.html

实用算法及实现细节

- 算法:CQL可以作为Q-learning算法(使用B * 而不是B π 在方程3,4中)或作为actor-critic算法。实际上,CQL通过在标准Bellman误差目标中添加一个简单的Q值正则化器来实现,这在现有的深度Q学习和actor-critic实现上很容易实现。

- 实现细节:CQL的实现只需在现有的软actor-critic(SAC)实现的基础上添加20行代码,以及在QR-DQN实现的基础上添加20行代码。权衡因子α通过Lagrangian对偶梯度下降进行自动调整,对于离散控制,α固定在附录F中描述的常数值。

- 超参数设置:除了策略学习率选择为3e-5(与Q函数的学习率相比,后者为3e-4或1e-4)之外,其他超参数与SAC相同。

- CQL变体:CQL可以实例化为不同的优化问题,例如CQL(H)和CQL(ρ)。实验证明,CQL在不同的任务上表现出色,尤其是在学习复杂和多模态数据分布时,往往比现有的离线RL方法高出2倍至5倍的最终回报。

到了这里,关于论文阅读--Conservative Q-Learning for Offline Reinforcement Learning的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!