1 引言

1.1 背景

随着抖音、小红书等新媒体的快速崛起,新媒体广告需求日益增大。而新媒体广告投放的图片和文案创意占用了运营工作者大量的精力和时间。文案、图片、视频广告创意制作难度大、效率低、成本高、周期长的问题日益凸显。如何快速的完成广告创意,是当前运营和设计人员最大的痛点之一。

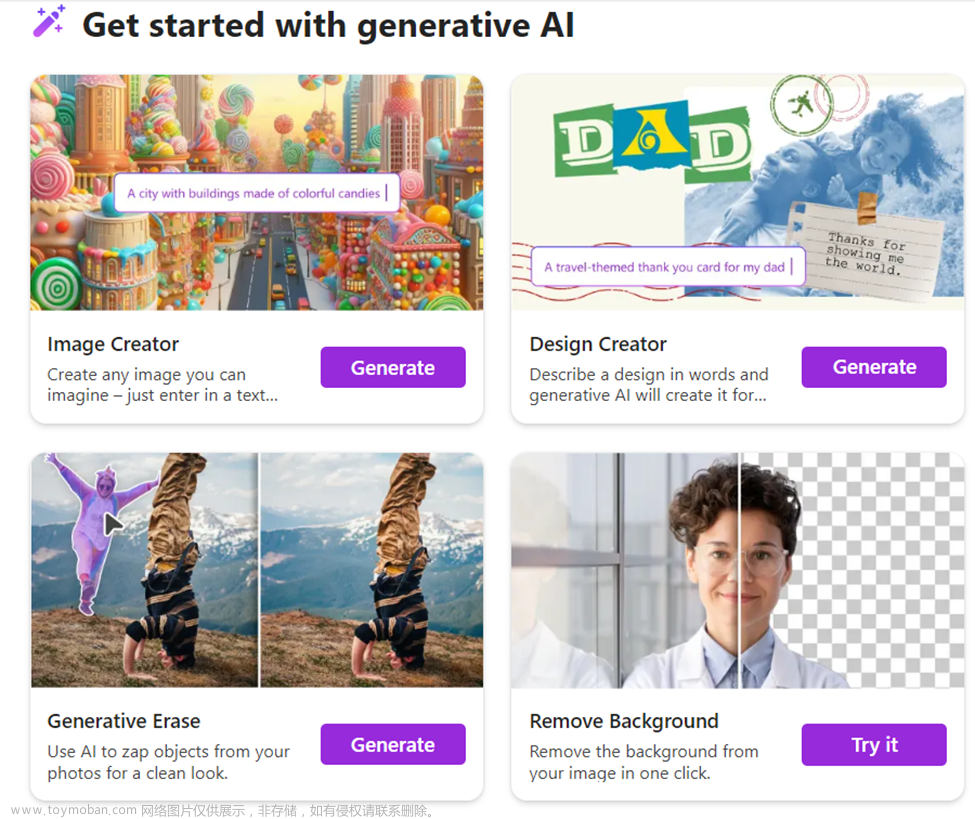

1.2 AIGC

AIGC(Artificial Intelligence Generated Content)是指借助先进的人工智能技术自动生成内容的创新实践。这一领域融合了机器学习、自然语言处理、计算机视觉等尖端科技,旨在模拟甚至超越人类的创造力。通过AIGC,机器不仅能够理解和处理大规模数据,还能在此基础上产生新颖的文本、图像、音频和视频内容。

2022年以来,ChatGPT等大语言模型的应用日益成熟,同时以Stable Diffusion 、Midjourney为代表的AI生成图片也被广泛运用。AIGC的应用范围日趋广泛,它能够在新闻撰写、文学创作、广告设计等多个领域发挥作用,提高内容生产的效率和质量。

1.3 AIGC与广告创意

AIGC能够根据品牌特性和用户需求,迅速产出大量创意方案,AIGC与广告创意结合起来,将会有效的解决广告创意领域面临的痛点,极大地丰富了广告表现形式和内容。本文主要介绍我们在AIGC和广告创意上的一些探索和实践。

2 小红书文案生成实践

2.1小红书爆款内容特点分析

结合目前小红书热门爆款内容,经分析归纳发现,爆款文章内容均具备一些共同特点。从标题来看,高质量的爆款内容往往具备一些引人入胜的标题,这些标题往往会采用一些略夸张的方式来进行创做,并且在标题中增加一些具有挑战性或悬念性等表达,外加一些标点符号增强表现力,营造惊喜感与紧迫感吸引读者,引发读者好奇心,部分标题还会融入时下热点话题以提高时效性,另外还有描述具体效果及成果的关键词加入等等,都意在利用标题来提高内容的吸引力。从正文内容部分来看,大多数爆款文章均比较注重内容的分享传播价值与实用性,内容表达简洁清晰,让读者容易理解及接受。再者爆款内容往往结合视觉元素如图片视频等增强内容的表现力,使文章看起来更加生动有趣。此外很多爆款内容强调互动性,吸引读者在评论区进行有效互动,提高话题参与度与粘性。

2.2 生成式AI关键技术GPT & LLM

Large Language Model (LLM) 即大型语言模型,也叫大语言模型,是一种基于深度学习的自然语言处理(NLP)模型,它能够学习自然语言的语法和语义,从而生成人类可读的文本。

GPT的全称是Generative Pre-Trained Transformer(生成式预训练Transformer模型)是一种基于[互联网]的、可用数据来训练的、文本生成的深度学习模型。

2.3 整体流程

结合平台文章特点,利用生成式预训练大模型,重点要进行提示词的工程化工作,首先要将用户的原始意图提炼转化为简短亮眼的标题,并提供多个选项供用户选择所需标题。然后用户在所生成的标题中选择自己认为合适的标题进行下一步内容的创作选项。用户除确定写作的角色信息、语气口吻等信息,还可以针对文章内容要介绍的重点亮点进行补充录入,平台方还会定期抽取近期热门的内容提炼成标签库,用户可以选择部分合适的近期热门标签,最终平台将这些内容进行整合加工,生成一段完整的GPT所需的prompt内容,提交prompt获取AI生成结果。

2.4 文章内容后期处理及润色

根据小红书平台特点,一般文末会有一些话题性tag标签以及部分提高文字生动表现力的表情。所以还需在生成的正文文末抽取3 - 6个SEO关键词以#号的形式放在文章末尾,并在每个段落中适当添加emoji表情,最终合成完整的文章内容 。

3 广告图片生成实践

3.1主流图像生成技术

目前比较流行的图像生成模型/工具,主要有DALL·E、Midjouney和Stable diffusion。

- Midjourney

Midjourney也是一款由人工智能驱动的工具,其能够根据用户的提示生成图像。MidJourney善于适应实际的艺术风格,创造出用户想要的任何效果组合的图像。它擅长环境效果,特别是幻想和科幻场景,看起来就像游戏的艺术效果。

夜晚的云端城堡,电影般的画面 - 图片由Midjourney生成 - DALL-E

DALL-E 2由OpenAI开发,它通过一段文本描述生成图像。其使用超过100亿个参数训练的GPT-3 Transformer模型,能够解释自然语言输入并生成相应的图像。

DALL-E 2主要由两部分组成——将用户输入转换为图像的表示(称为Prior),然后是将这种表示转换为实际的照片(称为Decoder)。

其中使用到的文本和图像嵌入来自另一个叫做CLIP(对比语言-图像预训练)的网络,这也是由OpenAI研发的。CLIP是一种神经网络,为输入的图像返回最佳的标题。它所做的事情与DALL-E 2所做的相反——它是将图像转换为文本,而DALL-E 2是将文本转换为图像。引入CLIP的目的是为了学习物体的视觉和文字表示之间的联系。

DALL-E2的工作是训练两个模型。第一个是Prior,接受文本标签并创建CLIP图像嵌入。第二个是Decoder,其接受CLIP图像嵌入并生成图像。模型训练完成之后,推理的流程如下:

l 输入的文本被转化为使用神经网络的CLIP文本嵌入。

l 使用主成分分析(Principal Component Analysis)降低文本嵌入的维度。

l 使用文本嵌入创建图像嵌入。

l 进入Decoder步骤后,扩散模型被用来将图像嵌入转化为图像。

l 图像被从64×64放大到256×256,最后使用卷积神经网络放大到1024×1024 - Stable Diffusion

Stable Diffusion是一个文转图的模型,其使用了CLIP ViT-L/14文本编码器,能够通过文本提示调整模型。它在运行时将成像过程分离成“扩散 (diffusion)”的过程——从有噪声的情况开始,逐渐改善图像,直到完全没有噪声,逐步接近所提供的文本描述。 - DALL·E 2, Stable Diffusion 和 Midjourney之间的比较

DALL-E 2使用数以百万计的图片数据进行训练,其输出结果更加成熟,非常适合企业使用。当有两个以上的人物出现时,DALL-E 2产生的图像要比Midjourney或Stable Diffusion好得多。

而Midjourney则是一个以其艺术风格闻名的工具。Midjourney使用其Discord机器人来发送以及接收对AI服务器的请求,几乎所有的事情都发生在Discord上。由此产生的图像很少看起来像照片,它似乎更像一幅画。

Stable Diffusion 是一个开源的模型,人人都可以使用。它对当代艺术图像有比较好的理解,可以产生充满细节的艺术作品。然而它需要对复杂的prompt进行解释。Stable Diffusion比较适合生成复杂的、有创意的插图。但在创作一般的图像时就显得存在些许不足。

3.2 广告图生成场景特点

与其它图像生成场景如文章配图不同,广告图本质是一种商品图,所以商品要100%保真,SD(Stable diffusion)作为一种概率模型,在现阶段生成出的图像具有很大的不确定性,即商品基本无法保真。下图为civitai上截取的一张由Lora生成的车图,尽管已经质量已经很高,但如车标等细节出现了肉眼可见的失真。

3.3 技术选型

由于上述原因,我们放弃了基于lora、hypernetworks 等方式微调SD模型的方案。转入研究基于Inpaint(局部重绘)的技术方案。

局部重绘主要包括三种应用场景:前景消除,前景重绘,背景重绘。其中背景重绘正适用于广告图生成的场景,即提供场景描述提示词+包含商品的原图。

3.4 实现方案

整个流程分为以下三步:

- 通过语义分割模型将原图中的车分割成车图和模板图。

- 通过stable diffusion + controlnet +模板提示词生成新背景车图。

- 绘制促销文案和图片logo。

4 应用

我们将AIGC和广告创意结合起来,与公司内部广告部门合作实践,该部门30%的图片由AIGC生成,广告从接单到上线的全流程用时从原来的平均4天,减少到4个小时,同时制作成本大大降低,降本增效效果显著。文章来源:https://www.toymoban.com/news/detail-855282.html

5 总结

本次实践着重于使用AIGC生成小红书文案和汽车类广告创意图片,实践证明AIGC可以有效的降低广告创意的制作周期和成本,在未来拥有广阔的前景。同时也要充分的意识到,目前的实践仅覆盖了广告创意中的一小部分场景,一些对质量要求非常高的场景目前尚无法解决。我们将持续探索出更优的方案,覆盖更多的广告创意场景。文章来源地址https://www.toymoban.com/news/detail-855282.html

到了这里,关于AIGC在广告创意上的实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!