Docker作为一个轻量级的容器化平台,使得应用程序的部署和扩展变得简单而高效。在Docker中部署Llama大型语言模型,可以确保模型运行环境的一致性和可移植性,同时也便于管理和扩展。本文将介绍如何在Docker中部署Llama模型的具体步骤和注意事项。

一、准备Docker环境

首先,确保你的系统上已经安装了Docker。你可以从Docker的官方网站(https://www.docker.com/get-started)下载并安装适合你操作系统的Docker版本。安装完成后,打开终端或命令提示符,运行以下命令来检查Docker是否安装成功:

docker --version

如果返回了Docker的版本号,说明安装成功。

二、获取模型文件和Dockerfile

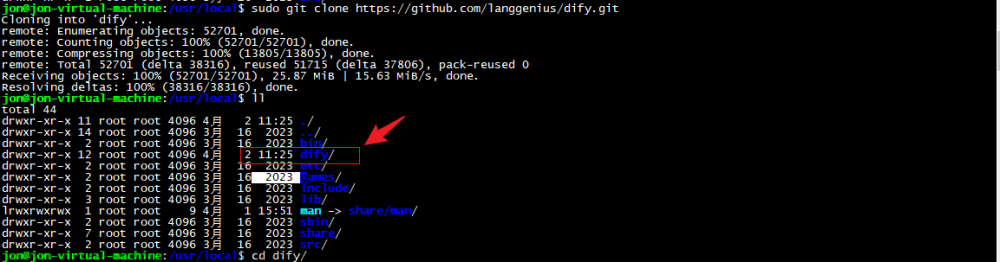

你需要从可靠的渠道获取Llama模型的权重文件。通常,这些文件会被托管在GitHub或其他代码托管平台上。下载模型文件后,你需要一个Dockerfile来描述如何构建和运行包含该模型的Docker镜像。文章来源:https://www.toymoban.com/news/detail-855415.html

Dockerfile是一个文本文件,其中包含了构建Docker镜像所需的所有指令和配置。你可以创建一个新的Dockerfile,并添加类似以下的指令:文章来源地址https://www.toymoban.com/news/detail-855415.html

# 使用基础Python镜像

FROM python:3.x

# 设置工作目录

WORKDIR /app

# 将模型文件复制到容器中

COPY llama_model /app/llama_model

# 安装到了这里,关于在Docker中部署Llama大型语言模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!