说明

- 1Panel简化了docker的部署,提供了可视化的操作,但是我在尝试创建Ollama WebUI容器时,遇到了从github拉取镜像网速很慢的问题,所以这里记录一下,同时也希望能够帮助到其他朋友

配置镜像加速

- docker配置github仓库ghcr国内镜像加速,推荐使用1panel方式二:配置镜像仓库,可视化拉取。

Ollama WebUI容器部署

- 先将镜像文件拉取到本地(可省略跳过,直接从第二步开始操作,先下载然后启动容器)

- 操作方法参看 docker配置github仓库ghcr国内镜像加速,1panel方式二:配置镜像仓库,可视化拉取,

- 打开应用商店,选择大模型,安装

ollama-webui容器

- 进行容器初始化配置,参照下图的指导即可

- 修改

docker compose文件中关于容器镜像的设置为ghcr.nju.edu.cn/open-webui/open-webui:main

- 最后点击确定即可启动容器

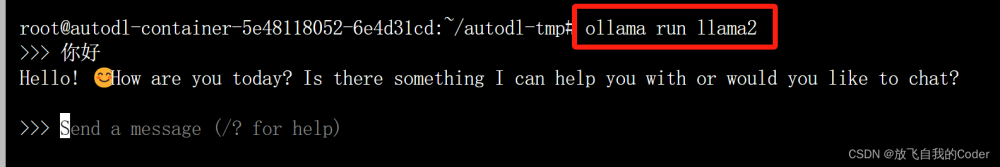

Ollama WebUI使用

- 访问

ip:3000即可进入ollama-webui初始化页面,填写名称、邮箱、密码(非容器配置的密匙)即可 - 新建聊天,选择模型,即可体验Ollama部署的大模型

- 选择设置可以进行相关的设置,包括语言、主题、Ollama连接和模型的下载和删除等相关内容,更多的内容,请各位自行研究探索

文章来源地址https://www.toymoban.com/news/detail-855516.html

文章来源地址https://www.toymoban.com/news/detail-855516.html

问题解决:访问页面空白

- 大概率是机器防火墙3000端口,没有开放,可以在1panel的防火墙面板中进行查看和开放3000端口(注意同时开放3000 udp/tcp两个类型的端口)

文章来源:https://www.toymoban.com/news/detail-855516.html

到了这里,关于使用1panel部署Ollama WebUI(dcoekr版)浅谈的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!