1.背景介绍

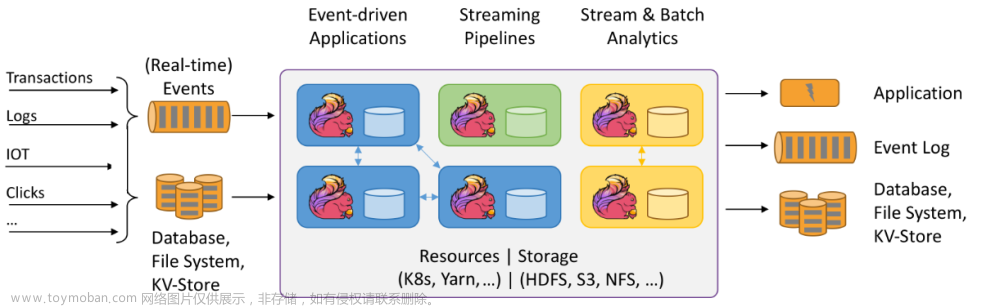

在大数据时代,数据流处理技术已经成为了一种重要的技术手段,用于处理和分析大量实时数据。Apache Flink和Apache Kafka是两个非常重要的开源项目,它们在数据流处理领域具有广泛的应用。本文将深入探讨Flink和Kafka的关系以及它们在数据流处理中的应用,并提供一些最佳实践和实际案例。

1. 背景介绍

Apache Flink是一个流处理框架,用于处理大量实时数据。它支持数据流和数据集两种操作,可以处理批量数据和流式数据。Flink提供了一种高效的、可扩展的、可靠的流处理解决方案,适用于各种应用场景,如实时分析、事件驱动应用、数据流处理等。

Apache Kafka是一个分布式消息系统,用于构建实时数据流管道和流式处理系统。Kafka可以处理大量高速数据,并提供有效的数据持久化和分布式消息传递功能。Kafka被广泛应用于日志收集、实时数据分析、流式计算等领域。

Flink和Kafka之间的关系是,Flink可以作为Kafka的消费者,从Kafka中读取数据,并进行流处理。同时,Flink也可以将处理结果写入Kafka,实现数据的持久化和分布式传输。因此,Flink和Kafka在数据流处理中具有很高的兼容性和可扩展性。

2. 核心概念与联系

2.1 Flink核心概念

- 数据流(Stream):数据流是Flink中最基本的概念,表示一种连续的数据序列。数据流中的数据元素按照时间顺序排列,可以被处理、转换和聚合。

- 数据集(Dataset):数据集是Flink中另一个基本概念,表示一种有限的数据序列。数据集中的数据元素可以被操作、计算和查询。

- 操作符(Operator):Flink中的操作符负责对数据流和数据集进行处理。操作符可以实现各种数据转换、聚合、分区等功能。

- 分区(Partition):Flink中的数据分区是一种分布式策略,用于将数据流和数据集划分为多个部分,以实现并行处理和负载均衡。

- 检查点(Checkpoint):Flink中的检查点是一种容错机制,用于保证流处理任务的可靠性。通过检查点,Flink可以在故障发生时恢复任务状态,保证数据的一致性和完整性。

2.2 Kafka核心概念

- Topic:Kafka中的Topic是一种分区的抽象概念,表示一组相关的分区。Topic可以用于存储和传输数据。

- Partition:Kafka中的Partition是Topic的基本单位,表示一组连续的数据块。Partition可以用于实现数据的分布式存储和并行处理。

- Producer:Kafka中的Producer是一种生产者组件,用于将数据发送到Topic中的Partition。

- Consumer:Kafka中的Consumer是一种消费者组件,用于从Topic中读取数据。

- Broker:Kafka中的Broker是一种服务器组件,用于存储和管理Topic和Partition。Broker负责接收Producer发送的数据,并提供Consumer读取数据的接口。

2.3 Flink与Kafka的联系

Flink和Kafka之间的关系是,Flink可以作为Kafka的消费者,从Kafka中读取数据,并进行流处理。同时,Flink也可以将处理结果写入Kafka,实现数据的持久化和分布式传输。因此,Flink和Kafka在数据流处理中具有很高的兼容性和可扩展性。

3. 核心算法原理和具体操作步骤以及数学模型公式详细讲解

在Flink和Kafka之间进行数据流处理时,主要涉及到以下算法原理和操作步骤:

3.1 Flink数据流操作

Flink数据流操作主要包括以下步骤:

- 数据源(Source):Flink需要从某个数据源读取数据,如Kafka、文件、socket等。数据源可以生成数据流或数据集。

- 数据转换(Transformation):Flink可以对数据流和数据集进行各种转换操作,如映射、筛选、连接、聚合等。这些操作可以实现数据的过滤、计算、分组等功能。

- 数据接收(Sink):Flink需要将处理结果写入某个数据接收器,如Kafka、文件、socket等。数据接收器可以将处理结果存储或传输到其他系统。

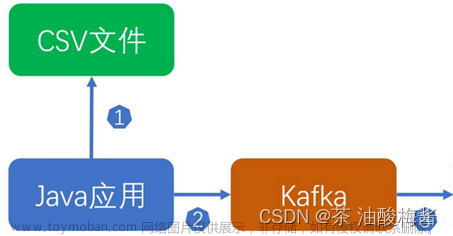

3.2 Kafka数据接收和发送

Kafka数据接收和发送主要包括以下步骤:

- 数据生产(Produce):Kafka Producer需要将数据发送到Kafka Topic中的Partition。生产者需要指定Topic和Partition,以及数据格式和编码方式。

- 数据消费(Consume):Kafka Consumer需要从Kafka Topic中读取数据。消费者需要指定Topic和Partition,以及数据格式和编码方式。

- 数据持久化(Persistence):Kafka可以将数据持久化到磁盘上,实现数据的持久化和可靠性。

3.3 Flink与Kafka的数据流处理

Flink与Kafka的数据流处理主要涉及到以下算法原理和操作步骤:

- Flink从Kafka读取数据:Flink可以作为Kafka的消费者,从Kafka中读取数据,并将读取到的数据转换为Flink数据流。

- Flink对数据流进行处理:Flink可以对读取到的数据流进行各种处理操作,如映射、筛选、连接、聚合等。这些操作可以实现数据的过滤、计算、分组等功能。

- Flink将处理结果写入Kafka:Flink可以将处理结果写入Kafka,实现数据的持久化和分布式传输。

3.4 数学模型公式

在Flink和Kafka之间进行数据流处理时,主要涉及到以下数学模型公式:

- 数据分区数(Partition):Flink和Kafka中的数据分区数可以通过公式计算:

$$ P = \frac{N}{R} $$

其中,$P$ 是分区数,$N$ 是数据元素数量,$R$ 是分区数。

- 数据流速度(Throughput):Flink和Kafka中的数据流速度可以通过公式计算:

$$ T = \frac{N}{D} $$

其中,$T$ 是数据流速度,$N$ 是数据元素数量,$D$ 是处理时间。

- 吞吐量(Throughput):Flink和Kafka中的吞吐量可以通过公式计算:

$$ Q = T \times W $$

其中,$Q$ 是吞吐量,$T$ 是数据流速度,$W$ 是数据宽度。

4. 具体最佳实践:代码实例和详细解释说明

4.1 Flink从Kafka读取数据

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

public class FlinkKafkaConsumerExample { public static void main(String[] args) throws Exception { // 设置执行环境 StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置Kafka消费者组

String groupId = "flink-kafka-consumer-group";

// 设置Kafka主题和分区

String topic = "test-topic";

int partition = 0;

// 设置Kafka消费者配置

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "localhost:9092");

properties.setProperty("group.id", groupId);

properties.setProperty("auto.offset.reset", "latest");

// 创建FlinkKafkaConsumer

FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>(topic, new SimpleStringSchema(), properties);

// 从Kafka读取数据

DataStream<String> dataStream = env.addSource(consumer);

// 进行数据处理

dataStream.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

return "processed-" + value;

}

}).print();

// 执行Flink任务

env.execute("FlinkKafkaConsumerExample");

}} ```

4.2 Flink将处理结果写入Kafka

```java import org.apache.flink.streaming.api.datastream.DataStream; import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment; import org.apache.flink.streaming.connectors.kafka.FlinkKafkaProducer;

public class FlinkKafkaProducerExample { public static void main(String[] args) throws Exception { // 设置执行环境 StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置Kafka主题和分区

String topic = "test-topic";

int partition = 0;

// 设置Kafka生产者配置

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "localhost:9092");

properties.setProperty("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

properties.setProperty("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 创建FlinkKafkaProducer

FlinkKafkaProducer<String> producer = new FlinkKafkaProducer<>(topic, new SimpleStringSchema(), properties);

// 创建数据流

DataStream<String> dataStream = env.fromElements("Hello Kafka", "Hello Flink");

// 将数据流写入Kafka

dataStream.addSink(producer).setParallelism(1);

// 执行Flink任务

env.execute("FlinkKafkaProducerExample");

}} ```

5. 实际应用场景

Flink和Kafka在数据流处理中具有很高的兼容性和可扩展性,可以应用于各种场景,如实时分析、事件驱动应用、流式计算等。以下是一些实际应用场景:

- 实时分析:Flink可以从Kafka中读取实时数据,并进行实时分析,如用户行为分析、网络流量分析、物联网设备数据分析等。

- 事件驱动应用:Flink可以从Kafka中读取事件数据,并进行事件处理,如订单处理、支付处理、消息推送等。

- 流式计算:Flink可以从Kafka中读取数据,并进行流式计算,如流式聚合、流式排名、流式机器学习等。

6. 工具和资源推荐

- Apache Flink:https://flink.apache.org/

- Apache Kafka:https://kafka.apache.org/

- FlinkKafkaConnector:https://ci.apache.org/projects/flink/flink-connectors.html#kafka-connector

- FlinkKafkaConsumer:https://ci.apache.org/projects/flink/flink-docs-release-1.12/dev/stream/operators/sources/kafka.html

- FlinkKafkaProducer:https://ci.apache.org/projects/flink/flink-docs-release-1.12/dev/stream/operators/sinks/kafka.html

7. 总结:未来发展趋势与挑战

Flink和Kafka在数据流处理领域具有很高的兼容性和可扩展性,可以应用于各种场景。在未来,Flink和Kafka将继续发展,以满足更多的应用需求。但同时,也面临着一些挑战,如性能优化、容错处理、分布式管理等。因此,Flink和Kafka的发展趋势将取决于它们如何应对这些挑战,以提供更高效、可靠、可扩展的数据流处理解决方案。

8. 附录:常见问题与解答

Q1:Flink和Kafka之间的数据流处理有哪些优势?

A1:Flink和Kafka之间的数据流处理具有以下优势:

- 高性能:Flink和Kafka可以实现高吞吐量、低延迟的数据流处理。

- 高可扩展性:Flink和Kafka可以实现水平扩展,以应对大量数据和高并发访问。

- 容错处理:Flink和Kafka具有容错机制,可以确保数据的一致性和完整性。

- 易用性:Flink和Kafka提供了简单易用的API,可以快速开发和部署数据流处理应用。

Q2:Flink和Kafka之间的数据流处理有哪些局限性?

A2:Flink和Kafka之间的数据流处理具有以下局限性:

- 学习曲线:Flink和Kafka的学习曲线相对较陡,需要掌握一定的技术知识和经验。

- 集成复杂性:Flink和Kafka之间的集成可能需要复杂的配置和调优,以实现最佳性能。

- 数据持久化:Kafka的数据持久化依赖于磁盘存储,可能受到磁盘性能和容量等限制。

Q3:Flink和Kafka之间的数据流处理有哪些应用场景?

A3:Flink和Kafka之间的数据流处理可以应用于以下场景:文章来源:https://www.toymoban.com/news/detail-856274.html

- 实时分析:Flink可以从Kafka中读取实时数据,并进行实时分析,如用户行为分析、网络流量分析、物联网设备数据分析等。

- 事件驱动应用:Flink可以从Kafka中读取事件数据,并进行事件处理,如订单处理、支付处理、消息推送等。

- 流式计算:Flink可以从Kafka中读取数据,并进行流式计算,如流式聚合、流式排名、流式机器学习等。

Q4:Flink和Kafka之间的数据流处理有哪些未来发展趋势?

A4:Flink和Kafka之间的数据流处理将有以下未来发展趋势:文章来源地址https://www.toymoban.com/news/detail-856274.html

- 性能优化:Flink和Kafka将继续优化性能,以满足更高的吞吐量和低延迟需求。

- 容错处理:Flink和Kafka将继续提高容错处理能力,以确保数据的一致性和完整性。

- 分布式管理:Flink和Kafka将提供更高效的分布式管理解决方案,以支持更复杂的数据流处理应用。

- 多语言支持:Flink和Kafka将扩展多语言支持,以满足更广泛的开发者需求。

参考文献

到了这里,关于数据流处理框架Flink与Kafka的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!