线程池使用场景(CountDownLatch、Future)

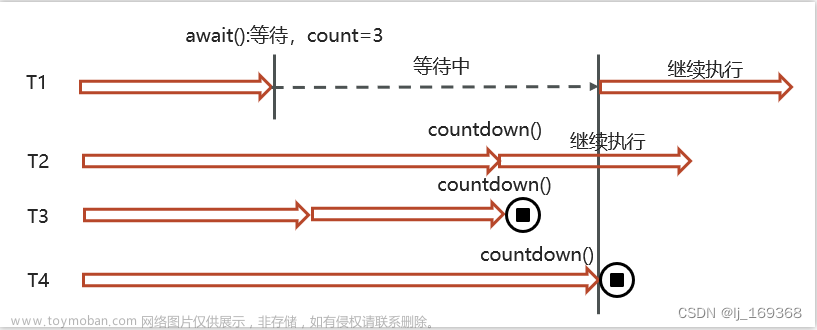

CountDownLatch(闭锁/倒计时锁) 用来进行线程同步协作,等待所有线程完成倒计时(一个或者多个线程,等待其他多个线程完成某件事情之后才能执行)

-

其中构造参数用来初始化等待计数值

-

await() 用来等待计数归零

-

countDown() 用来让计数 减一

public class CountDownLatchDemo {

public static void main(String[] args) throws InterruptedException {

//初始化了一个倒计时锁 参数为 3

CountDownLatch latch = new CountDownLatch(3);

new Thread(() -> {

System.out.println(Thread.currentThread().getName()+"-begin...");

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

//count--

latch.countDown();

System.out.println(Thread.currentThread().getName()+"-end..." +latch.getCount());

}).start();

new Thread(() -> {

System.out.println(Thread.currentThread().getName()+"-begin...");

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

//count--

latch.countDown();

System.out.println(Thread.currentThread().getName()+"-end..." +latch.getCount());

}).start();

new Thread(() -> {

System.out.println(Thread.currentThread().getName()+"-begin...");

try {

Thread.sleep(1500);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

//count--

latch.countDown();

System.out.println(Thread.currentThread().getName()+"-end..." +latch.getCount());

}).start();

String name = Thread.currentThread().getName();

System.out.println(name + "-waiting...");

//等待其他线程完成

latch.await();

System.out.println(name + "-wait end...");

}

}

多线程使用场景一:( es数据批量导入)

在我们项目上线之前,我们需要把数据库中的数据一次性的同步到es索引库中,但是当时的数据好像是1000万左右,一次性读取数据肯定不行(oom异常,内存溢出),当时我就想到可以使用线程池的方式导入,利用CountDownLatch来控制,就能避免一次性加载过多,防止内存溢出。

整体流程就是通过CountDownLatch+线程池配合去执行

多线程使用场景二(数据汇总)

在一个电商网站中,用户下单之后,需要查询数据,数据包含了三部分:订单信息、包含的商品、物流信息;这三块信息都在不同的微服务中进行实现的,我们如何完成这个业务呢?

在实际开发的过程中,难免需要调用多个接口来汇总数据,如果所有接口(或部分接口)的没有依赖关系,就可以使用线程池+future来提升性能

多线程使用场景三(异步调用)

在进行搜索的时候,需要保存用户的搜索记录,而搜索记录不能影响用户的正常搜索,我们通常会开启一个线程去执行历史记录的保存,在新开启的线程在执行的过程中,可以利用线程提交任务。

多线程使用的场景总结:

- **批量导入:**使用了线程池+CountDownLatch批量把数据库中的数据导入到了ES(任意)中,避免OOM

- **数据汇总:**调用多个接口来汇总数据,如果所有接口(或部分接口)的没有依赖关系,就可以使用线程池+future来提升性能

- **异步线程(线程池)︰**为了避免下一级方法影响上一级方法(性能考虑),可使用异步线程调用下一个方法(不需要下一级方法返回值),可以提升方法响应时间

如何控制某个方法允许并发访问线程的数量

Semaphore [ˈsɛməˌfɔr] 信号量,是JUC包下的一个工具类,我们可以通过其限制执行的线程数量,达到限流的效果。

当一个线程执行时先通过其方法进行获取许可操作,获取到许可的线程继续执行业务逻辑,当线程执行完成后进行释放许可操作,未获取达到许可的线程进行等待或者直接结束。

Semaphore两个重要的方法

-

lsemaphore.acquire(): 请求一个信号量,这时候的信号量个数-1(一旦没有可使用的信号量,也即信号量个数变为负数时,再次请求的时候就会阻塞,直到其他线程释放了信号量)

-

lsemaphore.release(): 释放一个信号量,此时信号量个数+1

线程任务类:

public class SemaphoreCase {

public static void main(String[] args) {

// 1. 创建 semaphore 对象

Semaphore semaphore = new Semaphore(3);

// 2. 10个线程同时运行

for (int i = 0; i < 10; i++) {

new Thread(() -> {

try {

// 3. 获取许可

semaphore.acquire();

} catch (InterruptedException e) {

e.printStackTrace();

}

try {

System.out.println("running...");

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("end...");

} finally {

// 4. 释放许可

semaphore.release();

}

}).start();

}

}

}

对ThreadLocal的理解

ThreadLocal是多线程中对于解决线程安全的一个操作类,它会为每个线程都分配一个独立的线程副本从而解决了变量并发访问冲突的问题。ThreadLocal 同时实现了线程内的资源共享

案例:使用JDBC操作数据库时,会将每一个线程的Connection放入各自的ThreadLocal中,从而保证每个线程都在各自的 Connection 上进行数据库的操作,避免A线程关闭了B线程的连接。

三个主要方法:

-

set(value) 设置值

-

get() 获取值

-

remove() 清除值

public class ThreadLocalTest {

static ThreadLocal<String> threadLocal = new ThreadLocal<>();

public static void main(String[] args) {

new Thread(() -> {

String name = Thread.currentThread().getName();

threadLocal.set("itcast");

print(name);

System.out.println(name + "-after remove : " + threadLocal.get());

}, "t1").start();

new Thread(() -> {

String name = Thread.currentThread().getName();

threadLocal.set("itheima");

print(name);

System.out.println(name + "-after remove : " + threadLocal.get());

}, "t2").start();

}

static void print(String str) {

//打印当前线程中本地内存中本地变量的值

System.out.println(str + " :" + threadLocal.get());

//清除本地内存中的本地变量

threadLocal.remove();

}

}

ThreadLocal的实现原理&源码解析

ThreadLocal本质来说就是一个线程内部存储类,从而让多个线程只操作自己内部的值,从而实现线程数据隔离

在ThreadLocal中有一个内部类叫做ThreadLocalMap,类似于HashMap

ThreadLocalMap中有一个属性 table数组 ,这个是真正 存储数据 的位置

set方法

get方法/remove方法

ThreadLocal的内存泄露问题

Java对象中的四种引用类型:强引用、软引用、弱引用、虚引用

- 强引用:最为普通的引用方式,表示一个对象处于有用且必须的状态,如果一个对象具有强引用,则GC并不会回收它。即便堆中内存不足了,宁可出现OOM,也不会对其进行回收

User user = new User();

- 弱引用:表示一个对象处于可能有用且非必须的状态。在GC线程扫描内存区域时,一旦发现弱引用,就会回收到弱引用相关联的对象。对于弱引用的回收,无关内存区域是否足够,一旦发现则会被回收

User user = new User();

WeakReference weakReference = new WeakReference(user);

每一个Thread维护一个ThreadLocalMap,在ThreadLocalMap中的Entry对象继承WeakReference。其中key为使用弱引用的ThreadLocal实例,value为线程变量的副本。 文章来源:https://www.toymoban.com/news/detail-857700.html

文章来源:https://www.toymoban.com/news/detail-857700.html

在使用ThreadLocal的时候,强烈建议:务必手动remove文章来源地址https://www.toymoban.com/news/detail-857700.html

到了这里,关于(线程池)多线程使用场景--es数据批量导入、数据汇总、异步调用;如何控制某个方法允许并发访问线程的数量;对ThreadLocal的理解及实现原理、源码解析、ThreadLocal的内存泄露问题的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!