private void checkRenderThreadState() {

if (mGLThread != null) {

throw new IllegalStateException(

“setRenderer has already been called for this instance.”);

}

}

也就是说,设置了Renderer后,就不能更换了,那么如果有需求:本来是渲染一个灰度滤镜的,当想变换其他滤镜的时候,又不能重新设置Renderer,此时应该如何

其实可以这样,Renderer可以只做一个调度者,Renderer里面可以写很多的滤镜,也可以变换滤镜,那么就可以满足我们的需求

那么接下来就先来定义一个基础滤镜

首先第一步,创建一个IRender

public interface IRender {

/**

- 创建

*/

void onCreate();

/**

- 设置尺寸

*/

void onChange(int width, int height);

/**

- 绘制

*/

void onDraw(int textureId);

/**

- 释放资源

*/

void onRelease();

}

和Renderer有些许不同,修改和增加了一些方法

新建BaseRender,实现IRender接口

public class BaseRender implements IRender {

/**

- Context

*/

private Context context;

/**

- 渲染数据

*/

private BaseRenderBean renderBean;

/**

- 顶点坐标

*/

private FloatBuffer vertexBuffer;

/**

- 纹理坐标

*/

private FloatBuffer coordinateBuffer;

/**

- 顶点坐标维数(即x, y, z)

*/

private int vertexSize = 2;

/**

- 纹理坐标维数(即x, y, z)

*/

private int coordinateSize = 2;

/**

- 顶点坐标步长(即维数 * 字节数)

*/

private int vertexStride = vertexSize * 4;

/**

- 纹理坐标步长(即维数 * 字节数)

*/

private int coordinateStride = coordinateSize * 4;

/**

- 顶点个数

*/

private int vertexCount = 4;

/**

- 纹理点个数

*/

private int coordinateCount = 4;

/**

- vertex shader

*/

private int vertexShader;

/**

- frag shader

*/

private int fragShader;

/**

- program

*/

private int program;

/**

- 纹理 id

*/

private int textureId;

/**

- fbo纹理id

*/

private int fboTextureId;

/**

- fbo id

*/

private int fboId;

/**

- vbo id

*/

private int vboId;

/**

- 顶点着色器代码路径

*/

private String vertexFilename;

/**

- 片元着色器代码路径

*/

private String fragFilename;

/**

- 尺寸

*/

private int width;

private int height;

/**

- 是否绑定Fbo

*/

private boolean isBindFbo = false;

/**

- 着色器顶点坐标位置

*/

private int aPosLocation;

/**

- 着色器纹理坐标位置

*/

private int aCoordinateLocation;

/**

- 着色器纹理位置

*/

private int uSamplerLocation;

/**

- 是否执行了onCreate

*/

private boolean isCreate = false;

/**

- 是否执行了onChange

*/

private boolean isChange = false;

public BaseRender(Context context) {

this(context, “render/base/base/vertex.frag”, “render/base/base/frag.frag”);

}

public BaseRender(Context context, String vertexFilename, String fragFilename) {

this.context = context;

this.vertexFilename = vertexFilename;

this.fragFilename = fragFilename;

}

@Override

public void onCreate() {

if (isCreate) {

return;

}

onCreatePre();

onClearColor();

onInitBlend();

onInitVertexBuffer();

onInitCoordinateBuffer();

onInitVbo();

onInitProgram();

onCreateAfter();

isCreate = true;

}

@Override

public void onChange(int width, int height) {

if (isChange) {

return;

}

onChangePre();

setWidth(width);

setHeight(height);

onViewport();

onInitFbo();

onChangeAfter();

isChange = true;

}

@Override

public void onDraw(int textureId) {

if (!onReadyToDraw()) {

return;

}

onDrawPre();

onClear();

onUseProgram();

onInitLocation();

onBindFbo();

onBindVbo();

onActiveTexture(textureId);

onEnableVertexAttributeArray();

onSetVertexData();

onSetCoordinateData();

onSetOtherData();

onDraw();

onDisableVertexAttributeArray();

onUnBind();

onDrawAfter();

}

@Override

public void onRelease() {

onDeleteProgram(program);

onDeleteShader(vertexShader);

onDeleteShader(fragShader);

onDeleteTexture(textureId);

onDeleteTexture(fboTextureId);

onDeleteFbo(fboId);

onDeleteVbo(vboId);

}

/**

- 创建之前

*/

public void onCreatePre() {

}

/**

- 设置背景颜色

*/

public void onClearColor() {

GLES20.glClearColor(0, 0, 0, 1);

}

/**

- 是否启用混色

*/

public boolean onEnableBlend() {

return false;

}

/**

- 初始化混色

*/

private void onInitBlend() {

if (!onEnableBlend()) {

return;

}

GLES20.glEnable(GLES20.GL_BLEND);

GLES20.glBlendFunc(GLES20.GL_SRC_ALPHA, GLES20.GL_ONE_MINUS_SRC_ALPHA);

}

/**

- 初始化顶点坐标

*/

public void onInitVertexBuffer() {

vertexBuffer = OpenGLESUtils.getSquareVertexBuffer();

}

/**

- 初始化纹理坐标

*/

public void onInitCoordinateBuffer() {

if (isBindFbo) {

coordinateBuffer = OpenGLESUtils.getSquareCoordinateReverseBuffer();

} else {

coordinateBuffer = OpenGLESUtils.getSquareCoordinateBuffer();

}

}

/**

- 初始化Vbo

*/

public void onInitVbo() {

vboId = OpenGLESUtils.getVbo(vertexBuffer, coordinateBuffer);

}

/**

- 初始化Program

*/

public void onInitProgram() {

String vertexShaderCode = OpenGLESUtils.getShaderCode(context, vertexFilename);

String fragShaderCode = OpenGLESUtils.getShaderCode(context, fragFilename);

vertexShader = OpenGLESUtils.loadShader(GLES20.GL_VERTEX_SHADER, vertexShaderCode);

fragShader = OpenGLESUtils.loadShader(GLES20.GL_FRAGMENT_SHADER, fragShaderCode);

program = OpenGLESUtils.linkProgram(vertexShader, fragShader);

}

/**

- 创建之后

*/

public void onCreateAfter() {

}

/**

- 设置尺寸之前

*/

public void onChangePre() {

}

/**

- 设置窗口尺寸

*/

public void onViewport() {

GLES20.glViewport(0, 0, width, height);

}

/**

- 初始化Fbo

*/

public void onInitFbo() {

if (!isBindFbo) {

return;

}

int[] fboData = OpenGLESUtils.getFbo(width, height);

fboId = fboData[0];

fboTextureId = fboData[1];

}

/**

- 设置尺寸之后

*/

public void onChangeAfter() {

}

/**

- 绘制之前的准备

*/

public boolean onReadyToDraw() {

return true;

}

/**

- 绘制之前

*/

public void onDrawPre() {

}

/**

- 清屏

*/

public void onClear() {

GLES20.glClear(GLES20.GL_COLOR_BUFFER_BIT);

}

/**

- 使用Program

*/

public void onUseProgram() {

GLES20.glUseProgram(program);

}

/**

- 初始化着色器各个位置

*/

public void onInitLocation() {

aPosLocation = GLES20.glGetAttribLocation(program, “aPos”);

aCoordinateLocation = GLES20.glGetAttribLocation(program, “aCoordinate”);

uSamplerLocation = GLES20.glGetUniformLocation(program, “uSampler”);

}

/**

- 绑定Fbo

*/

public void onBindFbo() {

if (!isBindFbo) {

return;

}

GLES20.glBindFramebuffer(GLES20.GL_FRAMEBUFFER, fboId);

GLES20.glFramebufferTexture2D(GLES20.GL_FRAMEBUFFER, GLES20.GL_COLOR_ATTACHMENT0,

GLES20.GL_TEXTURE_2D, fboTextureId, 0);

GLES20.glViewport(0, 0, width, height);

}

/**

- 绑定Vbo

*/

public void onBindVbo() {

GLES20.glBindBuffer(GLES20.GL_ARRAY_BUFFER, vboId);

}

/**

- 激活并绑定纹理

*/

public void onActiveTexture(int textureId) {

this.textureId = textureId;

GLES20.glActiveTexture(GLES20.GL_TEXTURE0);

GLES20.glBindTexture(GLES20.GL_TEXTURE_2D, textureId);

GLES20.glUniform1i(uSamplerLocation, 0);

}

/**

- 启用顶点坐标

*/

public void onEnableVertexAttributeArray() {

GLES20.glEnableVertexAttribArray(aPosLocation);

GLES20.glEnableVertexAttribArray(aCoordinateLocation);

}

/**

- 设置顶点坐标

*/

public void onSetVertexData() {

GLES20.glVertexAttribPointer(aPosLocation, vertexSize, GLES20.GL_FLOAT, false, vertexStride, 0);

}

/**

- 设置纹理坐标

*/

public void onSetCoordinateData() {

GLES20.glVertexAttribPointer(aCoordinateLocation, coordinateSize, GLES20.GL_FLOAT, false, coordinateStride, vertexBuffer.limit() * 4);

}

/**

- 设置其他数据

*/

public void onSetOtherData() {

}

/**

- 绘制

*/

public void onDraw() {

GLES20.glDrawArrays(GLES20.GL_TRIANGLE_STRIP, 0, vertexCount);

}

/**

- 禁用顶点坐标

*/

public void onDisableVertexAttributeArray() {

GLES20.glDisableVertexAttribArray(aPosLocation);

GLES20.glDisableVertexAttribArray(aCoordinateLocation);

}

/**

- 解除绑定

*/

public void onUnBind() {

GLES20.glBindTexture(GLES20.GL_TEXTURE_2D, 0);

GLES20.glBindFramebuffer(GLES20.GL_FRAMEBUFFER, 0);

GLES20.glBindBuffer(GLES20.GL_ARRAY_BUFFER, 0);

}

/**

- 绘制之后

*/

public void onDrawAfter() {

}

/**

- 删除Program

*/

public void onDeleteProgram(int program) {

GLES20.glDeleteProgram(program);

}

/**

- 删除Shader

*/

public void onDeleteShader(int shader) {

GLES20.glDeleteShader(shader);

}

/**

- 删除纹理

*/

public void onDeleteTexture(int textureId) {

GLES20.glDeleteTextures(1, new int[]{textureId}, 0);

}

/**

- 删除Fbo

*/

public void onDeleteFbo(int fboId) {

GLES20.glDeleteFramebuffers(1, new int[]{fboId}, 0);

}

/**

- 删除Vbo

*/

public void onDeleteVbo(int vboId) {

GLES20.glDeleteBuffers(1, new int[]{vboId}, 0);

}

public Context getContext() {

return context;

}

public void setContext(Context context) {

this.context = context;

}

public FloatBuffer getVertexBuffer() {

return vertexBuffer;

}

public void setVertexBuffer(FloatBuffer vertexBuffer) {

this.vertexBuffer = vertexBuffer;

}

public FloatBuffer getCoordinateBuffer() {

return coordinateBuffer;

}

public void setCoordinateBuffer(FloatBuffer coordinateBuffer) {

this.coordinateBuffer = coordinateBuffer;

}

public int getVertexSize() {

return vertexSize;

}

public void setVertexSize(int vertexSize) {

this.vertexSize = vertexSize;

}

public int getCoordinateSize() {

return coordinateSize;

}

public void setCoordinateSize(int coordinateSize) {

this.coordinateSize = coordinateSize;

}

public int getVertexStride() {

return vertexStride;

}

public void setVertexStride(int vertexStride) {

this.vertexStride = vertexStride;

}

public int getCoordinateStride() {

return coordinateStride;

}

public void setCoordinateStride(int coordinateStride) {

this.coordinateStride = coordinateStride;

}

public int getVertexCount() {

return vertexCount;

}

public void setVertexCount(int vertexCount) {

this.vertexCount = vertexCount;

}

public int getCoordinateCount() {

return coordinateCount;

}

public void setCoordinateCount(int coordinateCount) {

this.coordinateCount = coordinateCount;

}

public int getProgram() {

return program;

}

public void setProgram(int program) {

this.program = program;

}

public int getFboTextureId() {

return fboTextureId;

}

public void setFboTextureId(int fboTextureId) {

this.fboTextureId = fboTextureId;

}

public int getFboId() {

return fboId;

}

public void setFboId(int fboId) {

this.fboId = fboId;

}

public int getVboId() {

return vboId;

}

public void setVboId(int vboId) {

this.vboId = vboId;

}

public String getVertexFilename() {

return vertexFilename;

}

public void setVertexFilename(String vertexFilename) {

this.vertexFilename = vertexFilename;

}

public String getFragFilename() {

return fragFilename;

}

public void setFragFilename(String fragFilename) {

this.fragFilename = fragFilename;

}

public int getWidth() {

return width;

}

public void setWidth(int width) {

this.width = width;

}

public int getHeight() {

return height;

}

public void setHeight(int height) {

this.height = height;

}

public boolean isBindFbo() {

return isBindFbo;

}

public void setBindFbo(boolean bindFbo) {

isBindFbo = bindFbo;

}

public int getPosLocation() {

return aPosLocation;

}

public void setPosLocation(int aPosLocation) {

this.aPosLocation = aPosLocation;

}

public int getCoordinateLocation() {

return aCoordinateLocation;

}

public void setCoordinateLocation(int aCoordinateLocation) {

this.aCoordinateLocation = aCoordinateLocation;

}

public int getSamplerLocation() {

return uSamplerLocation;

}

public void setSamplerLocation(int uSamplerLocation) {

this.uSamplerLocation = uSamplerLocation;

}

public boolean isCreate() {

return isCreate;

}

public void setCreate(boolean create) {

isCreate = create;

}

public boolean isChange() {

return isChange;

}

public void setChange(boolean change) {

isChange = change;

}

public BaseRenderBean getRenderBean() {

return renderBean;

}

public void setRenderBean(BaseRenderBean renderBean) {

this.renderBean = renderBean;

}

public void updateRenderBean(BaseRenderBean renderBean) {

setRenderBean(renderBean);

}

}

代码有点长,但是里面尽可能地考虑到了渲染和扩展的需求

顶点着色器 vertex.frag

attribute vec4 aPos;

attribute vec2 aCoordinate;

varying vec2 vCoordinate;

void main(){

vCoordinate = aCoordinate;

gl_Position = aPos;

}

片元着色器 frag.frag

precision mediump float;

uniform sampler2D uSampler;

varying vec2 vCoordinate;

void main(){

gl_FragColor = texture2D(uSampler, vCoordinate);

}

注意到,里面有用到一个工具类OpenGLESUtils和实体类BaseRenderBean具体就不贴出来了,可以到Github上查看

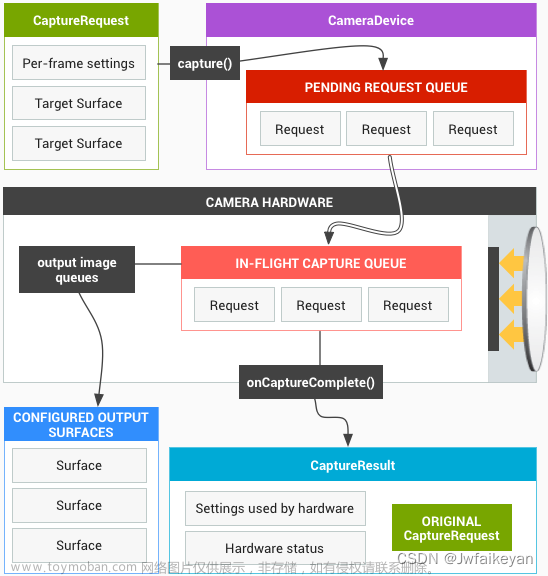

四、BaseOesRender

注意到,BaseRender里面绑定的纹理是2D纹理,而如果想实现相机预览,则需要使用Oes纹理,所以需要创建一个BaseOesRender为相机做渲染

package com.yk.media.opengles.render.base;

import android.content.Context;

import android.graphics.SurfaceTexture;

import android.opengl.GLES11Ext;

import android.opengl.GLES20;

import com.yk.media.utils.OpenGLESUtils;

public class BaseOesRender extends BaseRender {

/**

- oes纹理id

*/

private int oesTextureId;

/**

- 顶点变换矩阵位置

*/

private int uMatrixLocation;

/**

- 纹理变换矩阵位置

*/

private int uOesMatrixLocation;

/**

- oes尺寸

*/

private int oesW = -1;

private int oesH = -1;

/**

- 顶点变换矩阵

*/

private float[] mMVPMatrix = new float[16];

/**

- 纹理变换矩阵

*/

private float[] mOesMatrix = {

1, 0, 0, 0,

0, 1, 0, 0,

0, 0, 1, 0,

0, 0, 0, 1

};

/**

- 是否准备好绘制

*/

private boolean isReadyToDraw = false;

/**

- SurfaceTexture

*/

private SurfaceTexture surfaceTexture;

/**

- SurfaceTexture回调

*/

private OnSurfaceTextureListener onSurfaceTextureListener;

public BaseOesRender(Context context) {

super(context, “render/base/oes/vertex.frag”, “render/base/oes/frag.frag”);

setBindFbo(true);

oesTextureId = OpenGLESUtils.getOesTexture();

}

@Override

public void onInitCoordinateBuffer() {

setCoordinateBuffer(OpenGLESUtils.getSquareCoordinateBuffer());

}

@Override

public boolean onReadyToDraw() {

if (!isReadyToDraw) {

if (onSurfaceTextureListener != null) {

if (surfaceTexture != null) {

surfaceTexture.release();

surfaceTexture = null;

}

surfaceTexture = new SurfaceTexture(oesTextureId);

onSurfaceTextureListener.onSurfaceTexture(surfaceTexture);

isReadyToDraw = true;

} else if (surfaceTexture != null) {

surfaceTexture.attachToGLContext(oesTextureId);

isReadyToDraw = true;

} else {

return false;

}

}

return oesW != -1 && oesH != -1;

}

@Override

public void onDrawPre() {

super.onDrawPre();

mMVPMatrix = OpenGLESUtils.getMatrix(getWidth(), getHeight(), oesW, oesH);

surfaceTexture.updateTexImage();

float[] oesMatrix = new float[16];

surfaceTexture.getTransformMatrix(oesMatrix);

if (!OpenGLESUtils.isIdentityM(oesMatrix)) {

mOesMatrix = oesMatrix;

}

}

@Override

public void onInitLocation() {

super.onInitLocation();

uMatrixLocation = GLES20.glGetUniformLocation(getProgram(), “uMatrix”);

uOesMatrixLocation = GLES20.glGetUniformLocation(getProgram(), “uOesMatrix”);

}

@Override

public void onActiveTexture(int textureId) {

GLES20.glActiveTexture(GLES20.GL_TEXTURE0);

GLES20.glBindTexture(GLES11Ext.GL_TEXTURE_EXTERNAL_OES, textureId);

GLES20.glUniform1i(getSamplerLocation(), 0);

}

@Override

public void onSetOtherData() {

super.onSetOtherData();

GLES20.glUniformMatrix4fv(uMatrixLocation, 1, false, mMVPMatrix, 0);

GLES20.glUniformMatrix4fv(uOesMatrixLocation, 1, false, mOesMatrix, 0);

}

@Override

public void onRelease() {

super.onRelease();

onDeleteTexture(oesTextureId);

}

/**

- 绘制

*/

public void onDrawSelf() {

super.onDraw(oesTextureId);

}

/**

- 设置oes尺寸

*/

public void setOesSize(int width, int height) {

oesW = width;

oesH = height;

}

/**

- 设置SurfaceTexture

*/

public void setSurfaceTexture(SurfaceTexture surfaceTexture) {

this.surfaceTexture = surfaceTexture;

isReadyToDraw = false;

}

/**

- 设置SurfaceTexture回调

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数初中级Android工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则近万的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Android移动开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Android开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注:Android)

最后

对于程序员来说,要学习的知识内容、技术有太多太多,要想不被环境淘汰就只有不断提升自己,从来都是我们去适应环境,而不是环境来适应我们!

最后,我再重复一次,如果你想成为一个优秀的 Android 开发人员,请集中精力,对基础和重要的事情做深度研究。

对于很多初中级Android工程师而言,想要提升技能,往往是自己摸索成长,不成体系的学习效果低效漫长且无助。整理的这些架构技术希望对Android开发的朋友们有所参考以及少走弯路,本文的重点是你有没有收获与成长,其余的都不重要,希望读者们能谨记这一点。

为了大家能够顺利进阶中高级、架构师,我特地为大家准备了一套高手学习的源码和框架视频等精品Android架构师教程,保证你学了以后保证薪资上升一个台阶。

以下是今天给大家分享的一些独家干货:

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!文章来源地址https://www.toymoban.com/news/detail-858149.html

[外链图片转存中…(img-y1L4m8WK-1713087540265)]

[外链图片转存中…(img-VNAZQs1M-1713087540265)]

[外链图片转存中…(img-0UNrd0xk-1713087540266)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Android开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且会持续更新!

如果你觉得这些内容对你有帮助,可以扫码获取!!(备注:Android)

最后

对于程序员来说,要学习的知识内容、技术有太多太多,要想不被环境淘汰就只有不断提升自己,从来都是我们去适应环境,而不是环境来适应我们!

最后,我再重复一次,如果你想成为一个优秀的 Android 开发人员,请集中精力,对基础和重要的事情做深度研究。

对于很多初中级Android工程师而言,想要提升技能,往往是自己摸索成长,不成体系的学习效果低效漫长且无助。整理的这些架构技术希望对Android开发的朋友们有所参考以及少走弯路,本文的重点是你有没有收获与成长,其余的都不重要,希望读者们能谨记这一点。

为了大家能够顺利进阶中高级、架构师,我特地为大家准备了一套高手学习的源码和框架视频等精品Android架构师教程,保证你学了以后保证薪资上升一个台阶。

以下是今天给大家分享的一些独家干货:

[外链图片转存中…(img-raEGnOu0-1713087540266)]文章来源:https://www.toymoban.com/news/detail-858149.html

《互联网大厂面试真题解析、进阶开发核心学习笔记、全套讲解视频、实战项目源码讲义》点击传送门即可获取!

到了这里,关于Android OpenGLES + Camera1 相机预览(2)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!