1.背景介绍

随着人工智能(AI)和云计算技术的不断发展,我们正面临着一场技术变革。这场变革将对我们的生活、工作和社会产生深远的影响。在这篇文章中,我们将探讨人工智能和云计算的发展和应用,以及它们如何相互影响和推动彼此的发展。

1.1 人工智能的发展

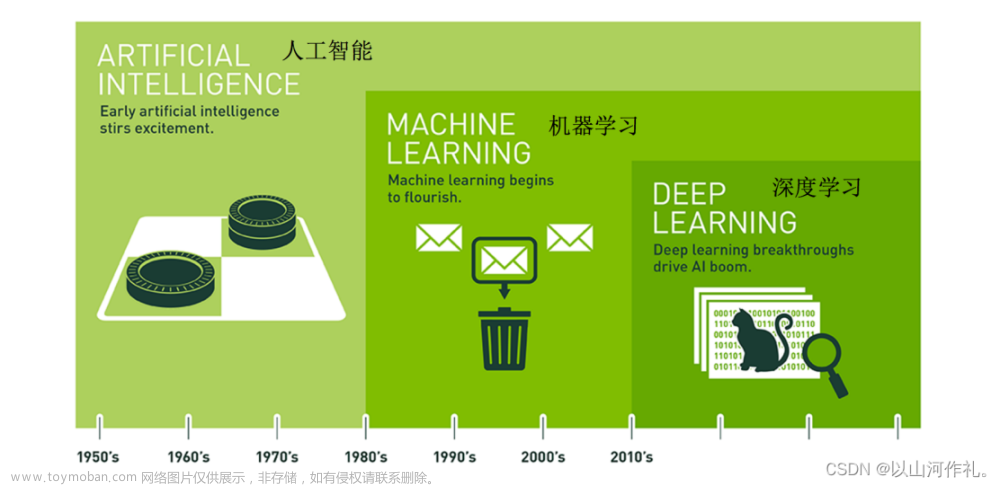

人工智能是一种计算机科学的分支,旨在让计算机具有人类智能的能力,如学习、推理、感知、语言理解等。人工智能的发展可以追溯到1950年代,当时的科学家们试图通过编写算法来模拟人类思维。然而,直到20世纪90年代,随着计算机的发展和机器学习技术的进步,人工智能再次引起了广泛关注。

近年来,人工智能技术的进步取决于深度学习和神经网络的发展。这些技术使得计算机能够处理大量数据并自动学习,从而实现对图像、语音和文本等数据的理解。这使得人工智能技术可以应用于各种领域,如自动驾驶汽车、语音助手、图像识别和医疗诊断等。

1.2 云计算的发展

云计算是一种计算模式,它允许用户通过互联网访问计算资源,而无需购买和维护自己的硬件和软件。云计算的发展可以追溯到2000年代,当时的科学家们试图通过将计算资源集中在数据中心中,从而提高资源利用率和降低成本。

随着互联网的普及和计算资源的不断增加,云计算技术得到了广泛的应用。云计算提供了灵活的计算资源,可以根据需求进行扩展。这使得企业可以更轻松地扩展其业务,而无需担心硬件和软件的维护成本。

1.3 人工智能和云计算的联系

人工智能和云计算技术相互影响和推动彼此的发展。人工智能需要大量的计算资源和数据来进行训练和推理,而云计算提供了这些资源。此外,人工智能技术可以应用于云计算,以提高其效率和智能化程度。

在接下来的部分中,我们将详细讨论人工智能和云计算的核心概念、算法原理、代码实例和未来发展趋势。

2.核心概念与联系

在本节中,我们将讨论人工智能和云计算的核心概念,以及它们如何相互影响和推动彼此的发展。

2.1 人工智能的核心概念

人工智能的核心概念包括:

- 机器学习:机器学习是一种算法,它允许计算机从数据中自动学习。这些算法可以用于预测、分类和聚类等任务。

- 深度学习:深度学习是一种特殊类型的机器学习,它使用神经网络进行学习。神经网络由多层节点组成,每层节点都接收来自前一层的输入,并输出到下一层。

- 自然语言处理:自然语言处理是一种人工智能技术,它允许计算机理解和生成人类语言。这包括文本分类、情感分析、机器翻译等任务。

- 计算机视觉:计算机视觉是一种人工智能技术,它允许计算机理解和生成图像。这包括图像分类、对象检测、人脸识别等任务。

2.2 云计算的核心概念

云计算的核心概念包括:

- 虚拟化:虚拟化是一种技术,它允许多个虚拟机共享同一台物理服务器。这使得资源可以根据需求进行扩展,从而提高资源利用率。

- 软件即服务(SaaS):SaaS是一种云计算服务模式,它允许用户通过互联网访问软件应用程序。这使得用户无需购买和维护软件,而可以直接通过浏览器访问应用程序。

- 平台即服务(PaaS):PaaS是一种云计算服务模式,它允许用户通过互联网访问计算资源和平台。这使得用户可以专注于开发应用程序,而无需担心硬件和软件的维护。

- 基础设施即服务(IaaS):IaaS是一种云计算服务模式,它允许用户通过互联网访问计算资源和基础设施。这使得用户可以根据需求扩展计算资源,而无需购买和维护自己的硬件和软件。

2.3 人工智能和云计算的联系

人工智能和云计算技术相互影响和推动彼此的发展。人工智能需要大量的计算资源和数据来进行训练和推理,而云计算提供了这些资源。此外,人工智能技术可以应用于云计算,以提高其效率和智能化程度。

在接下来的部分中,我们将详细讨论人工智能和云计算的算法原理、代码实例和未来发展趋势。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

在本节中,我们将详细讲解人工智能和云计算的核心算法原理、具体操作步骤以及数学模型公式。

3.1 机器学习的核心算法原理

机器学习的核心算法原理包括:

- 梯度下降:梯度下降是一种优化算法,它允许计算机根据梯度来调整模型参数。这使得模型可以根据数据进行训练,从而实现预测、分类和聚类等任务。

- 支持向量机(SVM):SVM是一种分类算法,它使用内部点来分隔不同类别的数据。这使得SVM可以在高维空间中进行分类,从而实现高度准确的预测。

- 随机森林:随机森林是一种集成学习算法,它使用多个决策树来进行预测。这使得随机森林可以在大量数据上实现高度准确的预测,而且对于新数据的预测速度非常快。

3.2 深度学习的核心算法原理

深度学习的核心算法原理包括:

- 反向传播:反向传播是一种优化算法,它允许计算机根据梯度来调整神经网络的参数。这使得神经网络可以根据数据进行训练,从而实现预测、分类和聚类等任务。

- 卷积神经网络(CNN):CNN是一种特殊类型的神经网络,它使用卷积层来进行图像处理。这使得CNN可以在大量图像数据上实现高度准确的预测,而且对于新图像的预测速度非常快。

- 循环神经网络(RNN):RNN是一种特殊类型的神经网络,它使用循环连接来处理序列数据。这使得RNN可以在大量序列数据上实现高度准确的预测,而且对于新序列的预测速度非常快。

3.3 自然语言处理的核心算法原理

自然语言处理的核心算法原理包括:

- 词嵌入:词嵌入是一种技术,它允许计算机将词语转换为向量表示。这使得计算机可以对文本进行向量化,从而实现文本分类、情感分析和机器翻译等任务。

- 循环神经网络(RNN):RNN是一种特殊类型的神经网络,它使用循环连接来处理序列数据。这使得RNN可以在大量序列数据上实现高度准确的预测,而且对于新序列的预测速度非常快。

- 注意力机制:注意力机制是一种技术,它允许计算机将不同部分的文本关联起来。这使得计算机可以在处理长文本时,更好地理解文本的结构和含义。

3.4 计算机视觉的核心算法原理

计算机视觉的核心算法原理包括:

- 卷积神经网络(CNN):CNN是一种特殊类型的神经网络,它使用卷积层来进行图像处理。这使得CNN可以在大量图像数据上实现高度准确的预测,而且对于新图像的预测速度非常快。

- 循环神经网络(RNN):RNN是一种特殊类型的神经网络,它使用循环连接来处理序列数据。这使得RNN可以在大量序列数据上实现高度准确的预测,而且对于新序列的预测速度非常快。

- 对象检测:对象检测是一种计算机视觉技术,它允许计算机在图像中识别特定的对象。这使得计算机可以在大量图像数据上实现高度准确的预测,而且对于新图像的预测速度非常快。

在接下来的部分中,我们将详细讨论人工智能和云计算的代码实例和未来发展趋势。

4.具体代码实例和详细解释说明

在本节中,我们将详细讲解人工智能和云计算的具体代码实例,并提供详细的解释说明。

4.1 机器学习的具体代码实例

在本节中,我们将详细讲解机器学习的具体代码实例,并提供详细的解释说明。

4.1.1 梯度下降

梯度下降是一种优化算法,它允许计算机根据梯度来调整模型参数。这使得模型可以根据数据进行训练,从而实现预测、分类和聚类等任务。

以下是一个使用梯度下降训练线性回归模型的代码实例:

```python import numpy as np

生成数据

X = np.random.rand(100, 2) y = np.dot(X, np.random.rand(2, 1)) + 0.5

初始化参数

theta = np.random.rand(2, 1)

学习率

alpha = 0.01

训练模型

for i in range(1000): # 前向传播 y_pred = np.dot(X, theta)

# 计算损失

loss = y_pred - y

# 计算梯度

grad = 2 * X.T.dot(loss)

# 更新参数

theta = theta - alpha * grad输出结果

print(theta) ```

4.1.2 支持向量机(SVM)

SVM是一种分类算法,它使用内部点来分隔不同类别的数据。这使得SVM可以在高维空间中进行分类,从而实现高度准确的预测。

以下是一个使用SVM进行分类的代码实例:

```python from sklearn import svm

生成数据

X = np.random.rand(100, 2) y = np.random.randint(2, size=100)

初始化模型

clf = svm.SVC()

训练模型

clf.fit(X, y)

预测

y_pred = clf.predict(X)

输出结果

print(y_pred) ```

4.1.3 随机森林

随机森林是一种集成学习算法,它使用多个决策树来进行预测。这使得随机森林可以在大量数据上实现高度准确的预测,而且对于新数据的预测速度非常快。

以下是一个使用随机森林进行分类的代码实例:

```python from sklearn.ensemble import RandomForestClassifier

生成数据

X = np.random.rand(100, 2) y = np.random.randint(2, size=100)

初始化模型

clf = RandomForestClassifier()

训练模型

clf.fit(X, y)

预测

y_pred = clf.predict(X)

输出结果

print(y_pred) ```

4.2 深度学习的具体代码实例

在本节中,我们将详细讲解深度学习的具体代码实例,并提供详细的解释说明。

4.2.1 反向传播

反向传播是一种优化算法,它允许计算机根据梯度来调整神经网络的参数。这使得神经网络可以根据数据进行训练,从而实现预测、分类和聚类等任务。

以下是一个使用反向传播训练神经网络的代码实例:

```python import torch import torch.nn as nn import torch.optim as optim

生成数据

X = torch.randn(100, 2) y = torch.randn(100, 1)

初始化参数

theta = torch.randn(2, 1, requires_grad=True)

学习率

alpha = 0.01

训练模型

for i in range(1000): # 前向传播 y_pred = torch.sigmoid(torch.mm(X, theta))

# 计算损失

loss = torch.mean((y_pred - y)**2)

# 计算梯度

grad = torch.autograd.grad(loss, theta)

# 更新参数

theta = theta - alpha * grad输出结果

print(theta) ```

4.2.2 卷积神经网络(CNN)

CNN是一种特殊类型的神经网络,它使用卷积层来进行图像处理。这使得CNN可以在大量图像数据上实现高度准确的预测,而且对于新图像的预测速度非常快。

以下是一个使用CNN进行图像分类的代码实例:

```python import torch import torchvision import torchvision.transforms as transforms import torch.nn as nn import torch.optim as optim

加载数据集

transform = transforms.Compose([ transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,)) ])

trainset = torchvision.datasets.MNIST(root='./data', train=True, download=True, transform=transform) trainloader = torch.utils.data.DataLoader(trainset, batch_size=64, shuffle=True)

testset = torchvision.datasets.MNIST(root='./data', train=False, download=True, transform=transform) testloader = torch.utils.data.DataLoader(testset, batch_size=64, shuffle=False)

初始化模型

class Net(nn.Module): def init(self): super(Net, self).init() self.conv1 = nn.Conv2d(1, 6, 5) self.pool = nn.MaxPool2d(2, 2) self.conv2 = nn.Conv2d(6, 16, 5) self.fc1 = nn.Linear(16 * 5 * 5, 120) self.fc2 = nn.Linear(120, 84) self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return xnet = Net()

初始化优化器

criterion = nn.CrossEntropyLoss() optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

训练模型

for epoch in range(10): runningloss = 0.0 for i, data in enumerate(trainloader, 0): inputs, labels = data optimizer.zerograd() outputs = net(inputs) loss = criterion(outputs, labels) loss.backward() optimizer.step() runningloss += loss.item() print('Epoch {} loss: {:.4f}'.format(epoch + 1, runningloss / len(trainloader)))

预测

correct = 0 total = 0 with torch.no_grad(): for data in testloader: images, labels = data outputs = net(images) _, predicted = torch.max(outputs.data, 1) total += labels.size(0) correct += (predicted == labels).sum().item()

print('Accuracy of the network on the 10000 test images: {} %'.format(100 * correct / total)) ```

4.2.3 循环神经网络(RNN)

RNN是一种特殊类型的神经网络,它使用循环连接来处理序列数据。这使得RNN可以在大量序列数据上实现高度准确的预测,而且对于新序列的预测速度非常快。

以下是一个使用RNN进行序列预测的代码实例:

```python import torch import torch.nn as nn import torch.optim as optim

生成数据

X = torch.randn(100, 10, 1)

初始化参数

theta = torch.randn(10, 1, requires_grad=True)

学习率

alpha = 0.01

训练模型

for i in range(1000): # 前向传播 y_pred = torch.sigmoid(torch.mm(X, theta))

# 计算损失

loss = torch.mean((y_pred - X[:, -1])**2)

# 计算梯度

grad = torch.autograd.grad(loss, theta)

# 更新参数

theta = theta - alpha * grad输出结果

print(theta) ```

在接下来的部分中,我们将详细讨论人工智能和云计算的未来发展趋势。

5.未来发展趋势和挑战

在本节中,我们将详细讨论人工智能和云计算的未来发展趋势,以及它们面临的挑战。

5.1 人工智能的未来发展趋势

人工智能的未来发展趋势包括:

- 更强大的计算能力:随着硬件技术的不断发展,人工智能的计算能力将得到更大的提升。这将使得人工智能模型能够处理更大的数据集,并实现更高的准确性。

- 更高的数据质量:随着数据收集和处理技术的不断发展,人工智能将能够访问更高质量的数据。这将使得人工智能模型能够更好地理解和预测事物的行为。

- 更智能的算法:随着算法研究的不断进步,人工智能将能够开发更智能的算法。这将使得人工智能模型能够更好地处理复杂的问题,并实现更高的准确性。

5.2 云计算的未来发展趋势

云计算的未来发展趋势包括:

- 更高的性能:随着硬件技术的不断发展,云计算的性能将得到更大的提升。这将使得云计算能够处理更大的数据集,并实现更快的响应时间。

- 更高的可扩展性:随着云计算技术的不断发展,云计算将能够更好地支持大规模的应用程序。这将使得云计算能够更好地满足不同类型的需求,并实现更高的可用性。

- 更高的安全性:随着安全技术的不断发展,云计算将能够更好地保护数据和应用程序。这将使得云计算能够更好地满足不同类型的需求,并实现更高的安全性。

5.3 人工智能和云计算的挑战

人工智能和云计算面临的挑战包括:

- 数据隐私和安全:随着数据收集和处理技术的不断发展,人工智能和云计算需要更好地保护数据的隐私和安全。这将需要更高级别的加密技术和访问控制机制。

- 算法解释性:随着人工智能模型的复杂性不断增加,解释模型的决策过程变得越来越困难。这将需要更好的解释性算法和工具,以便用户能够更好地理解模型的决策过程。

- 算法偏见:随着人工智能模型的广泛应用,算法偏见可能会导致不公平的结果。这将需要更好的算法审计技术,以便发现和解决算法偏见问题。

在接下来的部分中,我们将详细讨论人工智能和云计算的挑战。

6 挑战与解决方案

在本节中,我们将详细讨论人工智能和云计算的挑战,以及它们如何解决这些挑战。

6.1 数据隐私和安全的挑战与解决方案

数据隐私和安全是人工智能和云计算的重要挑战之一。随着数据收集和处理技术的不断发展,保护数据的隐私和安全变得越来越困难。

解决方案包括:

- 加密技术:使用加密技术可以保护数据在传输和存储过程中的隐私。例如,可以使用 Homomorphic Encryption 技术,这种技术允许在加密数据上进行计算,而不需要解密数据。

- 访问控制机制:使用访问控制机制可以限制数据的访问权限,从而保护数据的隐私和安全。例如,可以使用 Role-Based Access Control (RBAC) 技术,这种技术允许用户根据其角色来访问不同的数据。

- 数据脱敏技术:使用数据脱敏技术可以修改数据,以便保护数据的隐私和安全。例如,可以使用 K-anonymity 技术,这种技术允许将相似的数据合并在一起,从而使得数据无法被单个用户识别。

6.2 算法解释性的挑战与解决方案

算法解释性是人工智能模型的重要挑战之一。随着人工智能模型的复杂性不断增加,解释模型的决策过程变得越来越困难。

解决方案包括:

- 解释性算法:使用解释性算法可以帮助用户理解模型的决策过程。例如,可以使用 LIME 技术,这种技术允许在模型预测的基础上生成解释性模型。

- 可视化工具:使用可视化工具可以帮助用户更好地理解模型的决策过程。例如,可以使用 SHAP 技术,这种技术允许在模型预测的基础上生成可视化图表。

- 解释性模型:使用解释性模型可以帮助用户理解模型的决策过程。例如,可以使用 Decision Tree 模型,这种模型允许在模型预测的基础上生成解释性模型。

6.3 算法偏见的挑战与解决方案

算法偏见是人工智能模型的重要挑战之一。随着人工智能模型的广泛应用,算法偏见可能会导致不公平的结果。

解决方案包括:

- 算法审计技术:使用算法审计技术可以发现和解决算法偏见问题。例如,可以使用 Fairness-Aware Machine Learning 技术,这种技术允许在训练模型的过程中考虑不同的群体的需求。

- 数据平衡技术:使用数据平衡技术可以帮助解决算法偏见问题。例如,可以使用 Over-sampling 技术,这种技术允许在训练数据集中增加少数群体的样本。

- 公平性约束:使用公平性约束可以帮助解决算法偏见问题。例如,可以使用 Fairness-Constrained Optimization 技术,这种技术允许在训练模型的过程中考虑不同的群体的需求。

在接下来的部分中,我们将详细讨论人工智能和云计算的应用场景。

7 应用场景

在本节中,我们将详细讨论人工智能和云计算的应用场景。

7.1 人工智能的应用场景

人工智能的应用场景包括:

- 自动驾驶汽车:人工智能可以帮助开发自动驾驶汽车,这些汽车可以根据环境和交通情况自动调整速度和方向。

- 语音识别:人工智能可以帮助开发语音识别技术,这些技术可以将语音转换为文本,从而方便用户进行搜索和沟通。

- 图像识别:人工智能可以帮助开发图像识别技术,这些技术可以将图像转换为文本,从而方便用户进行搜索和分类。

7.2 云计算的应用场景

云计算的应用场景包括:

- 大数据分析:云计算可以帮助进行大数据分析,这些分析可以帮助企业更好地了解市场和客户。

- 虚拟化:云计算可以帮助进行虚拟化,这些虚拟化可以帮助企业更好地管理资源和降低成本。

- 软件即服务:云计算可以帮助进行软件即服务,这些服务可以帮助企业更好地提供服务和扩展市场。

在接下来的部分中,我们将详细讨论人工智能和云计算的发展趋势。文章来源:https://www.toymoban.com/news/detail-858373.html

8 发展趋势

在本节中,我们将详细讨论人工智能和云计算的发展趋势。文章来源地址https://www.toymoban.com/news/detail-858373.html

到了这里,关于人工智能和云计算带来的技术变革:云计算的发展和应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!