基本概念

线性代数是数学的一个分支,专注于向量、向量空间(也称为线性空间)、线性变换和矩阵的研究。这些概念在数据科学、人工智能、工程学和物理学等多个领域都有广泛应用。以下是这些基本概念的详细解释和它们在数据处理和AI中的应用。

向量

- 基本概念:向量是具有大小(magnitude)和方向的量,可以在多维空间中表示。在数据科学中,向量常用来表示数据点或特征。

- 应用:在AI中,向量用于表示观测数据、特征、状态等。例如,在自然语言处理(NLP)中,词汇可以通过词向量来表示,反映不同词汇之间的语义相似性。

向量空间(线性空间)

- 基本概念:向量空间是一组向量的集合,这些向量满足加法和标量乘法的封闭性。向量空间为我们提供了一个框架,用于研究向量的线性组合。

- 应用:在机器学习中,不同的特征空间可以表示为不同的向量空间,算法会在这些空间中寻找数据之间的线性关系或模式。

线性变换

- 基本概念:线性变换是一种特殊的函数,它将一个向量空间中的向量映射到另一个向量空间,同时保持向量加法和标量乘法的操作。矩阵是线性变换的一种表示。

- 应用:在AI中,线性变换常用于数据变换和特征提取。例如,在深度学习中,神经网络的每一层可以视为一种线性变换,用于从数据中提取高级特征。

矩阵

- 基本概念:矩阵是一个由行和列组成的矩形数组,用于表示向量和线性变换。矩阵运算,包括矩阵的加法、乘法、转置和逆等,是线性代数的核心内容。

- 应用:矩阵在AI中的应用极为广泛,从简单的数据表示到复杂的神经网络计算。例如,神经网络的权重可以表示为矩阵,神经网络的前向传播和反向传播算法本质上是对这些矩阵进行运算。

特征值和特征向量

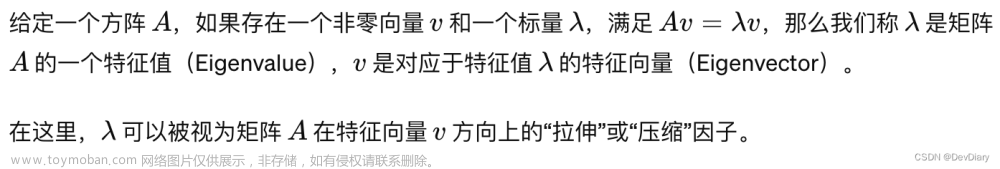

- 基本概念:对于给定的矩阵A,如果存在一个标量λ和一个非零向量v,使得Av = λv,那么λ称为A的一个特征值,v称为对应于λ的特征向量。

- 应用:特征值和特征向量在数据分析和机器学习中有重要应用,如主成分分析(PCA)就是通过寻找数据矩阵的特征值和特征向量来识别数据中最重要的特征。

通过掌握这些线性代数的基本概念,你将能够更好地理解和实施AI算法,尤其是那些涉及到大规模数据处理和复杂数学计算的算法。线性代数提供了一种强大的语言和工具,用于表述和解决数据科学和人工智能中的问题。

在AI中的应用

向量和矩阵运算

线性代数是AI特别是在机器学习和深度学习中不可或缺的数学工具。向量和矩阵运算是线性代数中最核心的部分,它们在AI的多个方面都有广泛应用。以下是这些概念在AI中应用的详细解释:

数据表示

- 向量:在AI中,向量常用来表示数据点或特征。例如,在自然语言处理(NLP)中,一个词可以通过一个向量(词向量)来表示,这个向量捕捉了词的语义特征。在图像识别中,一张图像可以展平为一个长向量,其元素表示图像中的像素值。

- 矩阵:矩阵用来表示多个数据点或多个特征。例如,一个数据集可以表示为一个矩阵,其中每一行代表一个数据点,每一列代表一个特征。这使得可以同时对多个数据点进行运算,大大提高了计算效率。

处理图像数据

- 在计算机视觉中,图像通常被表示为二维(灰度图像)或三维(彩色图像)矩阵,其中矩阵中的元素表示像素值。线性代数的矩阵运算允许我们进行图像处理操作,如旋转、缩放、平移和滤波等。深度学习模型,如卷积神经网络(CNN),进一步利用这些原理来识别和分类图像中的对象。

训练深度学习模型

- 权重和偏置:深度学习模型中的神经网络包含大量的权重和偏置,这些可以表示为矩阵和向量。在训练过程中,模型通过调整这些权重和偏置来学习数据的特征。

- 前向传播:计算输入数据通过神经网络的输出。这个过程涉及到大量的矩阵和向量乘法,以及线性变换和激活函数的应用。

- 反向传播:一种用于训练神经网络的算法,通过计算损失函数关于网络参数(权重和偏置)的梯度来更新这些参数。这个过程中大量使用了微分和线性代数的概念,包括矩阵的导数。

优化算法

- 大多数机器学习算法包括一个优化过程,旨在最小化或最大化某个目标函数(如损失函数)。线性代数在这些优化算法中扮演关键角色,尤其是在梯度下降等算法中,它需要计算目标函数相对于模型参数的梯度,这个梯度是通过矩阵和向量运算得到的。

总之,线性代数不仅为AI提供了一种强大的方式来表示和处理数据,还是构建和训练复杂模型所需计算的基础。理解和掌握向量和矩阵运算对于在AI领域取得成功至关重要。

特征值和特征向量

特征值和特征向量是线性代数中的重要概念,它们在数据分析、机器学习、物理学等多个领域有着广泛的应用。特别是在降维技术和优化问题中,它们扮演着关键的角色。

特征值和特征向量的定义

主成分分析(PCA)

主成分分析(PCA)是一种常用的数据降维技术,它通过线性变换将数据转换到新的坐标系统中,使得在新坐标系统的第一坐标轴上的数据方差最大(即第一个主成分),第二坐标轴上的数据方差次之,依此类推。PCA的目标是减少数据集的维度,同时保留数据集中最重要的方差结构。

在PCA中,数据的协方差矩阵(或相关矩阵)的特征值和特征向量有着特别的意义:

- 特征向量:协方差矩阵的特征向量指示了数据的主成分的方向。

- 特征值:每个特征值表示了其对应的特征向量方向上数据的方差量。特征值越大,表示那个方向上的数据变异(信息)越多。

通过选择最大的几个特征值对应的特征向量,我们可以将数据投影到由这些特征向量构成的较低维度空间中,从而实现降维。

优化问题

在优化问题中,特征值和特征向量也扮演着重要的角色。例如,在求解最优化问题时,我们常常需要找到函数的最大值或最小值。如果优化的目标函数可以通过矩阵表示,那么该矩阵的特征值可以帮助我们判断优化问题的性质(如凸性)和找到最优解的方向。

总结

特征值和特征向量提供了一种强大的工具,用于理解和处理线性变换。在PCA等数据降维技术中,它们帮助我们识别并保留数据中最重要的信息。在优化问题中,它们有助于我们理解问题的结构和解的性质。掌握特征值和特征向量的概念,对于进行高效的数据分析和解决复杂的数学问题至关重要。

奇异值分解(SVD)和主成分分析(PCA)

奇异值分解(SVD)和主成分分析(PCA)是两种强大的线性代数工具,广泛应用于数据分析、机器学习、图像处理等领域。它们都可以用于数据降维、特征提取、数据压缩和去噪,以及发现数据中的模式和结构。虽然SVD和PCA都可以达到相似的目的,但它们的出发点和计算方法有所不同。

奇异值分解(SVD)

定义:

应用:

- 数据压缩:通过保留最大的几个奇异值(和相应的奇异向量),可以近似重建原始数据矩阵,实现数据压缩。

- 去噪:奇异值较小的成分通常对应于噪声或不重要的信息,去除这些成分可以去噪。

- 特征提取:SVD可以揭示数据的内在结构,通过分析奇异值和奇异向量,可以发现数据中的模式和关系。

主成分分析(PCA)

定义: 主成分分析是一种统计方法,通过正交变换将可能相关的变量转换为一组线性不相关的变量,这些新的变量称为主成分。主成分是原始数据在新坐标系下的表示,第一主成分具有最大的方差(信息量),第二主成分次之,以此类推。

应用:

- 降维:通过选择包含大部分方差的前几个主成分,可以减少数据集的维度,同时保留最重要的信息。

- 数据可视化:通过将数据投影到前两个或三个主成分构成的空间,可以可视化高维数据。

- 特征提取:PCA能够揭示数据中的主要变动方向,有助于理解数据的内在结构。

SVD与PCA的关系

SVD和PCA紧密相关。实际上,PCA可以通过对数据矩阵的协方差矩阵进行奇异值分解来实现。PCA的主成分方向对应于SVD分解中矩阵V的列向量,即右奇异向量。而PCA的主成分得分可以通过奇异值和左奇异向量的乘积得到。文章来源:https://www.toymoban.com/news/detail-858403.html

总之,SVD和PCA都是处理和分析大规模数据集的有力工具。它们通过提取数据的关键特征和结构,帮助我们更好地理解和利用数据。文章来源地址https://www.toymoban.com/news/detail-858403.html

到了这里,关于线性代数基础概念和在AI中的应用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!