论文链接:https://arxiv.org/abs/2303.10849

代码:https://github.com/FuxiVirtualHuman/ABAW5

基本自译,没有使用翻译软件进行大段翻译。包含很多意译的部分。

不确定的地方有问号标注。

“问题:"部分是一些前置知识的补充,不是论文内容。

摘要

- 介绍ABAW这个比赛:识别情感表现(高质量、大规模;真实应用场景下的准确率、实用性)

- 本论文使用的方法(重点)

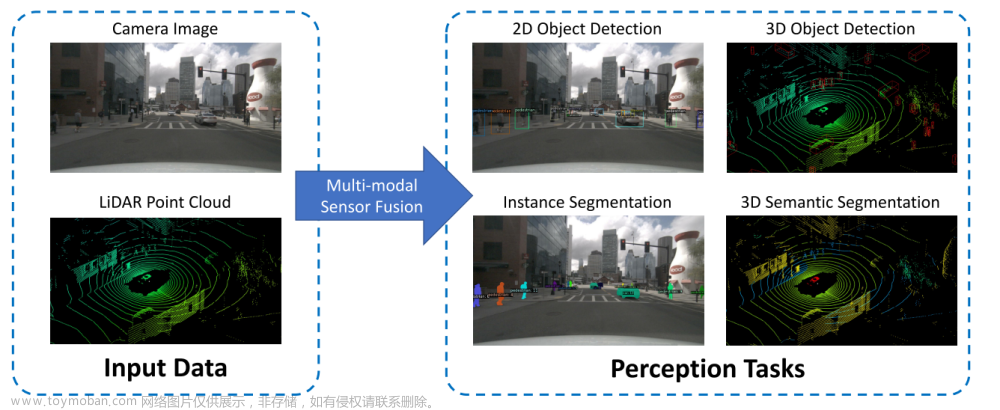

- 首先利用来自MAE(Masked Autoencoder)的视觉数据,该数据已经在大规模面部图像数据集上自监督地预训练过。

- 然后微调(finetune)MAE的图像框架(image frame)。(可看作是静态的单模型训练)

- 并利用这些视频(指的应是Aff-wild2)的多模态的时序信息(temporal information),构建一个基于transformer的深度学习框架来融合多模态的特征。

- 该方法在第五届比赛ABAW5中的优秀表现,以及进一步实验证明的有效性。

问题:

-

fine-tune,即微调,是什么意思?指在一个已经预训练好的神经网络模型的基础上,通过更改一小部分的参数或者重新训练最后几层神经网络层,来适应新的数据集或任务。这种微调的目的是在保持原有模型的特征提取能力的同时,让模型更好地适应新数据集的特征和模式,从而提升模型的准确性和性能。

-

什么是Masked-Autoencoder(MAE)?什么是它的图像框架(image frame)?

Masked Autoencoder是一种自动编码器(Autoencoder)的变种,用于学习数据的压缩表示并重建原始数据。在Masked Autoencoder中,与传统的自动编码器不同,数据输入会被随机掩盖(mask),然后让模型重建完整的数据。

具体来说,Masked Autoencoder通常包括以下几个步骤:

- 掩盖(Masking):将输入数据的一部分信息通过掩盖机制隐藏起来,可以是随机掩盖其中的一部分元素,使其不参与模型的训练过程。

- 压缩表示学习:使用已掩盖的输入数据训练模型,学习数据的压缩表示。自动编码器的编码器部分会将输入数据映射为低维的编码表示。

- 解压缩重建:模型的解码器部分从学习到的压缩表示中重建完整的输入数据,即在编码器的压缩表示基础上进行解码。

通过训练自动编码器模型来最小化重建误差,Masked Autoencoder能够学习到数据的有效表示,并具有较好的能力对数据进行重建。在一些应用领域中,Masked Autoencoder也能够用于带有缺失数据的重建任务。

因此,Masked Autoencoder是一种结合了数据掩盖和自动编码器思想的模型,用于学习数据的压缩表示和重建原始数据。

在Masked Autoencoder中,输入的图像数据通常会经过编码器(encoder)和解码器(decoder)两个部分进行处理,以学习数据的特征表示,并且重建原始输入数据。具体来说,输入的图像数据首先通过编码器部分进行压缩和特征提取,得到一种低维的表示形式(也可以称之为隐表示或者潜在表示)。然后,在解码器部分,这个低维表示会经过逆过程解码成为重建的图像数据。在Masked Autoencoder中,可能使用了特殊的掩蔽(masking)技术来处理输入数据,以一定的规则隐藏或遮挡一部分输入,进而学习更加紧凑和有效的特征表示。通过训练Masked Autoencoder模型,可以学习到数据的重要特征并且实现图像的重建,用于图像去噪、图像超分辨率等任务。因此,在Masked Autoencoder中的image frame即为输入的图像数据在编码器和解码器中进行处理的过程。

-

什么是Aff-wild2?Aff-Wild2是一个用于情感识别研究的数据集,是Aff-Wild数据集的继承者。Aff-Wild2数据集被广泛用于计算机视觉和情绪识别领域的研究,帮助研究人员训练和评估面部表情识别和情感分析模型。

Aff-Wild2数据集包含来自各种情感和心理状态的面部表情视频序列,以及对应的标签和注释信息。它由近万个多模态视频序列组成,覆盖了不同情感、年龄、性别等特征的参与者。该数据集不仅包含面部表情数据,还包括声音信号和生理特征等数据。Aff-Wild2数据集的标注包括面部动作、表情、情感、心理状态等信息,为情感识别和情感分析任务提供了丰富的数据资源。Aff-Wild2数据集的发布为情感识别研究提供了重要的支持和帮助,促进了该领域的发展和进步。

-

机器学习中的temporal information是什么含义?

“temporal information” 可以翻译为"时间信息"或者"时间相关信息"“时序信息”,强调了数据中包含的时间序列特征和时间关系。在机器学习中,处理包含时间信息的数据时,需要特别关注数据的时间顺序对模型的影响,以更好地捕捉数据之间的时序关系和特征。

-

transformer-based framework是什么?

Transformer-based框架是基于Transformer模型架构构建的深度学习框架。Transformer是一种基于自注意力机制(self-attention mechanism)的模型结构,最初由Vaswani等人在2017年提出。Transformer模型在自然语言处理领域取得了巨大成功,尤其是在机器翻译、文本生成和语言理解等任务上表现出色。

基于Transformer模型结构设计的深度学习框架通常被称为Transformer-based框架。这些框架将Transformer的结构和机制用于各种不同类型的任务,如文本处理、语音识别、计算机视觉等。Transformer-based框架的特点包括:

- 自注意力机制:Transformer模型使用自注意力机制来捕捉输入序列中不同位置单词或特征之间的关系,提高了模型的表示能力和上下文理解能力。

- 多头注意力机制:Transformer模型中引入了多头注意力机制,可以并行地学习多个不同的表示子空间,从而提高了模型的泛化能力和表示能力。

- 编码器-解码器结构:Transformer模型包括编码器(encoder)和解码器(decoder)两部分,适用于序列到序列(seq2seq)任务,如机器翻译。

由于Transformer模型在处理序列数据方面表现出色,因此基于Transformer模型构建的框架被广泛应用于各种自然语言处理任务和其他领域,成为当前主流的深度学习框架之一。

1 介绍

1.1 常用的人类表情表征

AU、EXPR、VA(即三个赛道)

AU:表情在脸部上体现的最小单元

VA:两个在[-1,1]范围的连续的值,V(代表积极/消极程度)和A(代表情绪强烈程度)

1.2 介绍ABAW赛事的贡献、介绍Aff-wild2数据集

Aff-wild2包括598个视频,其中大部分都有三类带注释的逐帧标签:AU、VA、EXPR(基本表情分类),比赛设置的三个赛道内容就是识别这三类表情表征。

1.3 再次介绍论文使用的方法

-

首先,在大规模面部数据集上自监督地预训练一个掩盖自动编码器(Masked Autoencoder, MAE)。

-

接着选择MAE编码器作为视觉特征提取器,捕捉面部的视觉特征。由于数据量大,提取出来的特征对后阶段多样化的面部相关任务有很强的推广性。

-

(在2之前进行)对MAE编码器进行微调,以针对AU、EXPR、VA三种任务;这个训练过程只用到了静态的视觉模型数据。

-

(在2之前进行)为了进一步利用时序的多模态信息,设计TMF(Temporal and Multi-modal Fusion,时序多模态融合)来把视频切分成几个片段,逐片段进行上述的后阶段任务。

-

在这个过程中,利用经过微调的MAE编码器从每个帧中提起视觉特征,同时捕捉声学特征(后者利用的是预训练过的Hubert、Wav2vec2、Vggish音频模型)。视觉和声学特征结合在一起后喂给一个Transformer,用于捕捉时序信息,用于之后阶段的任务。

-

额外提出几个在处理后的方法,来有效地让预测结果更平滑,从而提高模型表现。

2 相关工作

介绍ABAW5比赛中AU、EXPR、PA的相关工作,以及脸部情感分析中的自监督学习方法。

2.1 AU检测

难题:有限的身份信息,不同姿势、光照、遮挡的影响,会限制模型生成,并导致对这些噪声信息的过拟合。

解决办法:

- 使用一个多模态框架,来囊括附加的辅助信息,作为会增加额外标签限制的正则化方法。如Zhang的流式模型,可以同时进行AU、EXPR、VA;Jin和Thinh将AU和EXPR的工作结合到一起;JAA-Net同时进行特征点和AU的检测。

- 另一个提高模型泛化效果的方法是利用其他相关任务与训练过的backbone(主干结构).如Jiang、Savchenko、Zhang等人的工作。

多模态信息:Zhang捕捉了视觉、声学、文字信息,并利用一个转换解码器结构来把它们融合在一起;Jin提取视觉信息和声学信息,同样用一个转换解码器结构来把它们融合。

问题:

什么是backbone?在深度学习中,“backbone"通常指代模型的主干网络结构或基础架构。在许多深度学习任务中,比如目标检测、图像分类、语义分割等任务,通常会使用由多个层叠的卷积神经网络(CNN)或其他深度学习模型构成的主干网络。这个主干网络就被称为"backbone”。

"backbone"通常用作特征提取器,负责对输入数据进行特征提取、抽象和表示学习。通过在"backbone"网络中传递输入数据,可以逐层提取图像、文本或其他类型数据中的特征。这些在"backbone"中提取的特征通常会被后续的任务特定头部网络(task-specific head network)用来执行具体的任务,比如分类、定位、分割等。

在训练过程中,通常会根据数据集和任务的要求选择不同的"backbone"网络结构,例如常用的ResNet、VGG、MobileNet等。选择适合的"backbone"结构可以帮助提高模型的性能、准确性和泛化能力。

2.2 EXPR(识别表情)

EXPR是识别出一张输入图片的基本情绪(开心,悲伤等)。接下来介绍了五组人的工作,包括如何采集额外的信息正则化(?)。

2.3 VA评估

几个研究利用了VA和AU,或VA和EXP之间的关系,有助于在其他不含VA标签的任务中检测AU或EXPR。

进一步地,许多研究使用多模态框架,利用视觉、声学、文字中的隐藏信息,并用Transformer结构进行特征融合,用于VA任务中。

2.5 SSL

SSL(Self-Supervised Learning,自监督学习)可以利用大规模的无标签数据,从而降低面部情绪识别所需的大量时间/劳动,提高准确率。如Shu等的工作。

3 方法

包括两步(同1.3所述):MAE(Masked Autoencoder)预训练,TMF(Temporal and Multi-modal Fusion)

3.1 MAE预训练

图片数据集约2.17M,MAE模型自监督训练。

MAE模型以Vision Transformer(ViT)为基础,包括一个编码器和一个解码器(两个都以ViT为基础)。

预训练的方法是先掩盖,然后重构。图片先被分为16x16的小块,其中75%被随机掩盖,送入MAE编码器,其解码器应该要重构出完整图片(看那个安妮海瑟薇)。预训练的损失函数是逐像素的L2损失,来让重构的图片尽量接近原图。

自监督训练完成后,移除解码器,替换为一个和编码器全连接的层,来微调后续任务(Aff-wild2数据集上AU、EXPR、VA)。注意这个过程是逐帧训练,没有考虑时序或其他模型信息。三个任务对应的损失函数如下。

y(有帽帽): 模型预测的AU

z(有帽帽): 模型预测的情感分类

v(有帽帽): 模型预测的V(valence,VA中正面/负面)

a(有帽帽): 模型预测的A(Arousal,VA中情感强烈程度)

没有帽帽的是真实数据。

δ:标准差

μ:平均数

ρ:相关系数

AU和EXPR任务中,使用加权交叉熵作为损失函数(头两个式子)。W代表不同分类的权重,与训练集中的分类数字成反比。

3.2 时序多模态融合

-

首先,将视频分为几个小片段,每个片段的帧数都相等,为K(除不尽的怎么办?)。构建TMF(Temporal and Multi-modal Fusion,即时序多模态融合)进行基于顺序的训练,利用上音频的信息。

-

给定一个视频片段Ci和其对应的音频片段Ai,使用微调过的MAE解码器和一些现存的预训练音频特征提取模型(Hubert、Wav2vec2、vggish)来提取每一帧的视觉特征Fvis和声学特征Faud(每一帧是分开的)。

-

结合Fvis和Faud,送入Transformer解码器结构,发掘其中时序的相关性。该Transformer解码器包含四层解码器,随机失活比率为0.3。

-

Transformer解码器的输出将作为一个全连接层的输入,这个层根据不同的任务要求,调整最终输出的大小(?)。

注:在训练过程中MAE编码器和音频特征提取器的参数是固定的(没经过训练);

计算损失时,使用损失函数1、2、3,并使一个片段的序列结果(序列指有一定顺序)变得平坦。

平滑措施(Smoothing):推论是逐帧作出的,因此平滑对提高推论稳定性很重要。有时视频中裁剪出的人脸图像会丢失一些帧(可能是因为这些帧中无法检测到人脸)。

为了保证连续性,使用最近的一帧来替换丢失帧,并对每一帧进行推论。

接着使用高斯滤波,使得AU、EXPR或VA的概率结果变得平滑。高斯滤波的sigma根据不同任务设置为不同的值,详见下一节。(sigma越大,高斯曲线约扁平,图像越模糊,数据越平滑)。

问题

-

Dropout 随机失活是什么?让隐层的神经元以一定的概率不被激活。

实现方式:训练过程中,对某一层使用Dropout,就是随机将该层的一些输出舍弃(输出值设置为0),这些被舍弃的神经元就好像被网络删除了一样。

随机失活比率( Dropout ratio):是被设为 0 的特征所占的比例,通常在 0.2~0.5范围内。例:假设某一层对给定输入样本的返回值应该是向量:[0.2, 0.5, 1.3, 0.8, 1.1]。

使用Dropout后,这个向量会有几个随机的元素变成:[0, 0.5, 1.3, 0, 1.1]。Dropout是通过遍历神经网络每一层的节点,然后通过对该层的神经网络设置一个 Dropout ratio(随机失活比率),即该层的节点有Dropout ratio的概率失活。以这种方式“dropped out”的神经元既不参与前向传播,也不参与反向传播。

随机失活能够防止过拟合:

解释1:随机失活使得每次更新梯度时参与计算的网络参数减少了,降低了模型容量,所以能防止过拟合。

解释2:随机失活鼓励权重分散,从这个角度来看随机失活也能起到正则化的作用,进而防止过拟合。

总的来说通过Dropout每次输入一个样本,就相当于该神经网络就尝试了一个新的结构,但是所有这些结构之间共享权重。因为神经元不能依赖于其他特定神经元而存在,所以这种技术降低了神经元复杂的互适应关系。正因如此,网络需要被迫学习更为鲁棒的特征(泛化性更强)。 -

平滑概率(smooth the probability)是什么?是指对模型输出的概率分布进行处理,以减小概率的变化幅度,使其更加平滑和稳定。在深度学习中,概率分布通常作为模型输出的一部分,例如在分类任务中,模型会输出各个类别的概率分布,而这些概率值可能会出现极端值或波动较大的情况。

对概率进行平滑处理有助于提高模型的鲁棒性和泛化能力,避免过拟合和减小预测结果的不确定性。常见的概率平滑方法包括使用贝叶斯平滑、加入先验知识、通过模型融合等方式来调整概率分布,使其更具有连续性和稳定性。

4 实验

4.1 实验设置

- 使用OpenCV将Aff-Wild2中所有视频处理为帧,使用OpenFace检测器裁剪出所有的面部图像,且大小均为224×224,检测错误的图像(其中没有脸)使用网易伏羲有灵众包平台来检测并去除。

- 在大规模面部数据集上预训练MAE,进行800轮次(epoch),批次大小(batch size)为4096,学习率为0.0024,并使用AdamW优化器。训练过程基于PyTorch,使用8块NVIDIA A30 GPU(图形处理器单元)。

- 微调MAE时,批次大小(batch size)设为512,学习率设为0.0001,仍使用AdamW作为优化器。

- 训练TMF:视频片段长度为100(帧?),批次大小(batch size)设为32,学习率设为0.0001,约在20轮次(epoch)内完成,仍使用AdamW作为优化器。所有的实验都是在基于面向代理编程(AOP)的伏羲有灵平台上进行的,以便于任务建模。

模型输出结果的衡量指标:

每个赛道的衡量指标如下:

AU检测、EXPR(情绪分类):计算每个分类(class)的F1分数。

VA估计:分别计算V和A的CCC(Concordance Correlation Coefficient,一致性相关系数),其定义见方程4。

问题

-

训练epoch指的是在机器学习或深度学习模型训练过程中,将整个训练数据集完整地传递给模型一次所需的次数。在每个epoch中,训练数据集将被分成多个批次(batches),每个批次包含一定数量的数据样本,模型通过一批数据进行前向传播和反向传播的计算,更新参数以优化模型。

训练epoch的数量是模型训练中一个重要的超参数,决定了模型在训练阶段需要学习的次数。通常情况下,epoch的数量越多,模型对训练数据的适应性越强,但也容易导致过拟合。因此,在实际训练中需要通过交叉验证等方法来选择合适的epoch数量,以避免模型训练不足或过度拟合的问题。

-

AdamW优化器是Adam优化算法的一种变体,它在原始Adam算法的基础上加入了权重衰减(Weight Decay)的正则化项。在AdamW中,通过将权重衰减的正则化项添加到Adam算法的梯度更新公式中,可以更精确地对权重进行正则化,避免参数值变得过大而导致过拟合。尤其对于深度神经网络和大规模数据集来说,通常能够提升模型的性能和泛化能力。

-

搭载8块NVIDIA A30 GPU的服务器通常被用于处理大规模数据集、进行复杂的深度学习模型训练,或者进行大规模并行计算任务。这样的服务器配置可以提供高性能计算能力,适合在数据中心或企业级环境中运行需要大量计算资源的工作负载。

-

**Agent-Oriented Programming (AOP)**是一种编程范式,旨在通过模拟自主的智能代理来解决复杂的问题和实现复杂的系统。在Agent-Oriented Programming中,程序被组织成一个个独立的代理(agents),每个代理都具有自主性、目标导向性和能够与其他代理进行交互的能力。

4.2 验证集上的实验结果

AU(Action Unit Detection)

使用方程5评定实验结果。为了提升泛化能力,进行五次折叠的交叉验证(5-fold cross-validation)(使用现存的有标签数据集,随机分割训练和测试视频)。结果见表1(Table 1)。

发现AU4(眉毛下降,Brow Lowerer)、AU15(嘴角下压,Lip Corner Depressor)、AU24(抿唇,Lip Pressor)在不同的数据分割上结果波动较大,可能是因为这些AU数字都相对低,无法进行足够的学习,因此对分割的依赖较重。

问题

-

在5-fold交叉验证中,数据集被分成5个大致相等的部分,其中一部分被留作测试集,其余4部分用作训练集。模型被训练4次,每次使用其中4个部分作为训练数据,然后用剩余的一部分作为测试数据来评估模型的性能。这个过程被重复5次,每次使用不同的部分作为测试集,得到5个测试性能的度量指标。最终,这些度量指标被平均以评估模型的性能。

5-fold交叉验证有助于减少模型性能估计的不确定性,因为模型在不同的数据集上进行训练和测试,可以更全面地评估模型的泛化能力。另外,5-fold交叉验证也可以提供更好的数据利用率,因为每个样本都会被用作训练和测试,而不会被浪费。

5-fold交叉验证是一种常用的交叉验证技术,通常被应用于机器学习算法的性能评估和参数调优。除了5-fold,还有其他的交叉验证技术,例如k-fold交叉验证、leave-one-out交叉验证等,它们在不同的场景下可以提供更有效的模型性能评估方法。

-

面部Action Unit (AU) Detection 是指识别和检测人脸上的表情动作单元。每个AU代表了一种特定的面部表情,例如皱眉、微笑、眼睛眯起等。在AU Detection中,模型会识别出人脸上激活的AU,并将其与特定的表情动作进行匹配。

当说“number for AU is relatively low”时,通常指的是在进行AU Detection时被检测出来的AU的数量相对较少。这可能意味着在数据集或样本中,被激活的AU的种类不多,或者模型的性能可能不太好,无法检测到多样化的面部表情。在AU Detection中,通常会有一个AU编号的列表,数字代表每个AU的唯一标识符,因此“number for AU is relatively low”意味着检测到的AU的数字或种类比较有限。

AU对应表(Environmental Psychology & Nonverbal Behavior)

EXPR(Expression Classification)

(根据上文)使用方程6评定实验结果。同样进行五次折叠的交叉验证(5-fold cross-validation)(也使用现存的有标签数据集,随机分割训练和测试视频)。结果见表2(Table 2)。

由表格可见,愤怒(Anger)、厌恶(Disgust)、恐惧(Fear)的模型表现相对不稳定,同时这三个分类在数据集中的出现频率都是最低的,导致了这个糟糕的表现。

VA(Valence-Arousal Estimation)

使用方程4评定实验结果。为了提升模型泛化能力,同样进行五次折叠的交叉验证(5-fold cross-validation)(也使用现存的有标签数据集,随机分割训练和测试视频)。结果见表3。

4.3 测试集上的实验结果

AU:平均F1为55.49%,赛道第一名。简要阐述了其他第二、三、四名的做法异同之处。

EXPR:平均F1为41.21%,赛道第一名。简要阐述了其他队伍的做法异同之处。

VA:平均CCC为0.6372,赛道第二名,与第一名的0.6414相差极小。简述了第三名CBCR的做法,其他队伍的做法和其他赛道的大致相同。

4.4 消融实验(减少方法中的模块,观察效果)

用实验阐述各个模块的重要性,包括MAE微调训练、TMF(时序多模态融合)、特征选取、处理后的平滑策略。所有实验都在官方训练和验证集上进行。

MAE微调

直接在TMF中使用原始参数的MAE,不经过微调,结果见表7(Table 7)(w/o表示without),发现三个赛道的表现都有显著降低。这表明微调MAE可以有效的发掘单张图片的静态视觉特征,为时序视觉特征的学习提供很有用的前置知识。

时序多模态融合(TMF)

去除TMF,使用单帧上训练的模型。结果同样见表7。可见TMF让三条赛道的表现都有所提高,表明了时序的、多模态的特征可以进一步发掘三种任务中的隐藏信息。值得注意的是,相比其他任务,TMF对EXPR任务的提高更显著。

多模态特征的选取

分析使用不同多模态特征的影响,结果见表8。特别地,使用两种视觉特征进行实验:之前提到过的MAE特征,以及表情嵌入(DLN的一种将表情信息转换为向量表示的技术,用于表示和捕捉表情的语义和情感信息)。

结果表明,仅使用MAE特征时,在三种任务中都有显著优势,因此在多模态信息融合时只使用了MAE提取的特征。

对于音频特征,尝试三种:Hubert、wav2vec2、Vggish。由表8看出,使用音频特征无法提升AU任务(识别面部表情单元)的表现,但对于VA(情绪积极消极、强烈程度)和EXPR(情绪分类)有用。在这两个赛道中,实验表明结合Hubert和Vggish特征的效果最好。

平滑策略

由于预测都是逐帧做出的,因此平滑策略可以有效减少一些噪音预测,提高稳定性。使用Scipy library中的滤波来进行平滑。表9第一行是没有进行平滑,其余行则是使用不同的滤波作为平滑策略时,各个赛道上评定的得分。可见使用了平滑策略,可以使得各个评定有不同程度的提升。(图中可见高斯滤波评分都是最高的)

在不同的赛道上,平滑策略的超参数有所区别:

中值和均值滤波对于AU、EXP、VA的滑动窗口大小设置为10、25、50;

高斯滤波对于AU、EXP、VA的sigma大小设置为5、25、25。

这是因为人类面部活动在小段时间中变化更频繁,因此AU(面部表情单元)要更敏感;而人类的情感状态一般变化较小,所以EXP(情感分类)、VA(情感积极/消极程度、强烈程度)变化没有那么敏感。

最终在官方测试集上的平滑策略包括了以上的一些平滑策略。

问题

-

Scipy(Scientific Python)是建立在Python语言之上的开源科学计算库,致力于提供丰富、高效和便利的工具来解决科学计算和数据分析方面的问题。Scipy库中包含了许多模块和函数,涵盖了优化、数值积分、插值、信号处理、图像处理、统计分析、线性代数等方面的功能。

-

median滤波和average滤波的sliding window是一种在信号处理中常用的技术,用于平滑或去除噪声。

- Median滤波的sliding window(中值滤波的滑动窗口): 中值滤波是一种非线性滤波方法,它使用滑动窗口在信号或图像上移动,并计算窗口中所有像素值的中值(即排序后的中间值),然后用中值来代替窗口中心像素的值。滑动窗口的大小可以根据需求选取,一般为奇数,以确保能够得到确切的中值。中值滤波的滑动窗口可以帮助去除图像中的噪声,同时保留图像的边缘信息,因此常用于图像处理领域。

- Average滤波的sliding window(均值滤波的滑动窗口): 均值滤波是一种线性滤波方法,它使用滑动窗口在信号或图像上移动,并计算窗口中所有像素值的平均值,然后用平均值来代替窗口中心像素的值。滑动窗口的大小可以根据需求选取,通常较小。均值滤波的滑动窗口可以平滑信号或图像,有助于去除高频噪声,但可能会导致图像细节的损失。

在信号处理中,通过调整滑动窗口的大小和类型,可以实现不同程度的滤波效果,以平滑信号或图像,并根据具体需求选择合适的滤波方法。Median滤波和average滤波是常用的滤波技术之一,对于不同的应用场景可能会有不同的效果。

5 结论

本论文介绍了ABAW5第一名队伍提交的结果,针对AU、EXPR、VA三个赛道。

-

首先,在大规模面部图像数据集上自监督地预训练MAE(Masked Autoencoder),使之学习到一系列人类面部的大致特征。

-

接着,利用Aff-wild2数据集的静态图像来微调MAE。

-

然后使用TMF(时序多模态融合)来发掘多模态信息(视觉、声学的时序特征)。

再次阐述各赛道排名;

消融实验表明,方法中的每个模块都可以提升模型在情感识别任务中的表现。

6 致谢

基于面向代理编程(AOP)的网易伏羲有灵平台(实验、数据管理、存储)

2022年杭州市科技创新重点项目文章来源:https://www.toymoban.com/news/detail-858755.html

浙江省重点研发计划文章来源地址https://www.toymoban.com/news/detail-858755.html

到了这里,关于【论文笔记】Multi-modal Facial Affective Analysis based on Masked Autoencoder的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!