目录

查看在运行的Spark任务

通过Spark Web界面查看任务信息

通过Spark日志查看任务信息

Spark Web

查看在运行的Spark任务

在大数据处理中,Apache Spark是一个流行的分布式计算框架,它提供了丰富的API和功能,用于处理大规模数据集。在Spark应用程序运行时,我们经常需要实时监视和跟踪正在执行的Spark任务,以便及时发现问题并进行调优。本文将介绍如何查看正在运行的Spark任务的方法。

通过Spark Web界面查看任务信息

Spark提供了一个Web界面,可以方便地查看正在运行的Spark应用程序和任务的详细信息。

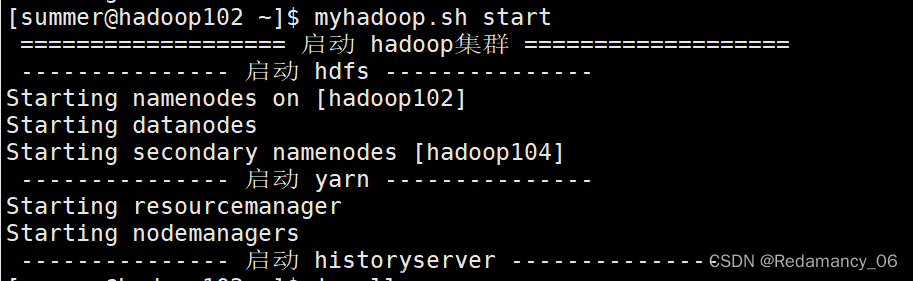

- 启动Spark集群:首先确保您的Spark集群正在运行,并且已经启动了Spark应用程序。

- 访问Spark Web界面:打开您的Web浏览器,输入Spark Master节点的URL地址(例如http://spark-master-ip:8080)即可访问Spark Web界面。

- 查看应用程序:在Spark Web界面中,您可以查看正在运行的Spark应用程序列表,包括应用程序的名称、运行状态、执行者(Executor)数量等信息。

- 查看任务信息:通过点击应用程序的链接,您可以进入应用程序的详细页面,在这里您可以查看每个作业(Job)的执行情况、任务(Task)的状态和执行详情等信息。

通过Spark日志查看任务信息

除了通过Spark Web界面查看任务信息外,您还可以通过查看Spark的日志文件来获取任务的更详细信息。

- 查看Driver日志:Spark应用程序的Driver节点会生成详细的日志文件,您可以通过查看这些日志文件来了解应用程序的整体执行情况和任务调度情况。

- 查看Executor日志:每个Executor节点也会生成相应的日志文件,您可以通过查看这些日志文件来了解任务在每个Executor上的执行情况和性能指标。

- 分析日志:通过分析日志文件中的关键信息,例如任务执行时间、数据倾斜情况、Executor资源利用率等,可以帮助您发现潜在的性能瓶颈并进行优化调整。 综上所述,通过Spark Web界面和日志文件,您可以全面了解正在运行的Spark任务的状态和执行情况,帮助您调优Spark应用程序并提高数据处理效率。 希望以上信息对您有所帮助!如果您有任何问题或想了解更多内容,请随时与我联系。谢谢!

监控和调优正在运行的Spark任务,以确保其高效执行。下面通过一个示例代码,演示如何使用Python编写一个Spark应用程序,并同时展示如何通过Spark Web界面和日志文件来查看任务信息。

pythonCopy code

from pyspark.sql import SparkSession

# 初始化SparkSession

spark = SparkSession.builder.appName("MonitorSparkJob").getOrCreate()

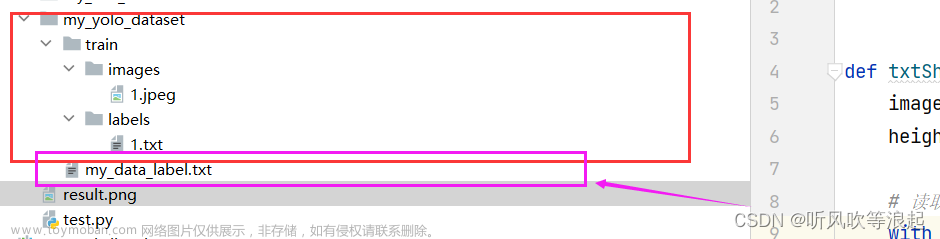

# 读取数据集

data = spark.read.csv("data.csv", header=True)

# 执行一些数据处理操作

processed_data = data.groupBy("column1").count()

# 将处理结果写出到文件

processed_data.write.csv("output")

# 停止SparkSession

spark.stop()通过上述示例代码,我们创建了一个简单的Spark应用程序,对data.csv数据集进行处理,并将处理结果写出到文件output中。 接下来,我们可以通过以下步骤来监控任务信息:文章来源:https://www.toymoban.com/news/detail-858912.html

- 使用Spark Web界面:在运行应用程序时,访问Spark Web界面,查看应用程序的执行情况、作业和任务的状态等信息。

- 查看日志文件:在Driver节点和Executor节点的日志文件中查看更详细的任务执行情况,例如任务执行时间、数据倾斜情况等。 在实际运行中,您可以根据Spark Web界面和日志文件中的信息,及时发现任务的性能瓶颈,并进行调优操作,提高Spark应用程序的执行效率和性能。

Spark Web

Spark Web是Apache Spark提供的用于监控和管理Spark应用程序的Web界面。通过Spark Web界面,用户可以实时查看Spark应用程序的运行状态、作业执行情况、任务调度情况等重要信息,帮助用户更好地监控和调优Spark应用程序。 以下是Spark Web提供的主要功能和信息:文章来源地址https://www.toymoban.com/news/detail-858912.html

- 应用程序列表:Spark Web界面会列出当前正在运行的所有Spark应用程序,用户可以看到每个应用程序的名称、运行状态、运行时间等信息。

- 应用程序详情:用户可以点击具体的应用程序,进入应用程序的详情页面,查看该应用程序的作业(Job)列表、Stages、任务(Task)信息等。

- Stage视图:在每个应用程序的详情页面中,用户可以查看每个Stage的执行情况,包括任务数量、任务完成情况、任务失败情况等。

- 任务视图:用户可以查看每个任务的详细信息,包括任务的执行时间、数据倾斜情况、任务运行日志等。

- Executor列表:Spark Web界面也会显示每个Executor节点的状态和资源利用情况,帮助用户了解Executor的运行情况。

- 日志链接:用户还可以通过Spark Web界面方便地查看Driver节点和Executor节点的日志文件,以更详细地了解任务的执行情况和可能出现的问题。 通过Spark Web界面,用户可以及时监控Spark应用程序的运行情况,发现潜在的性能瓶颈或问题,并采取相应的优化措施。同时,Spark Web界面也提供了直观、友好的交互界面,使用户能够轻松地获取和分析Spark应用程序的运行信息。

到了这里,关于查看在运行的spark任务的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!