Mac上可以本地运行大模型,作为Mac x86硬件,比较好的选择是Ollama,但有一些准备工作,需要明确一下,否则坑也会比较多。

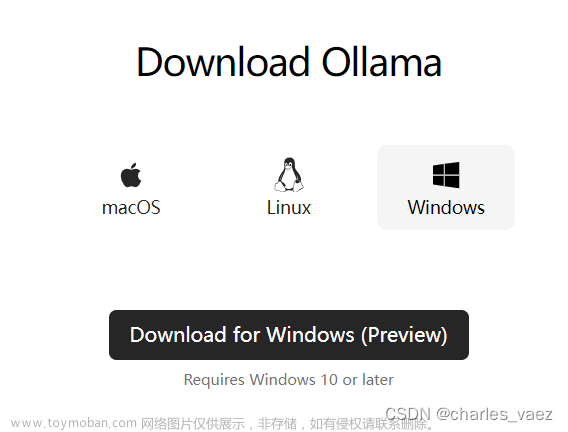

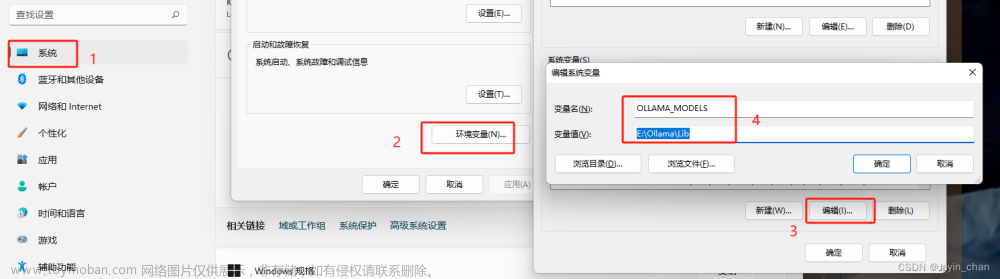

1、下载地址: 官网

2、也可以通过安装Docker Desktop(下载: x86 Docker Desktop),再下载Docker官方的Ollama。

3、安装Ollama并运行命令:ollama run gemma

4、安装并运行Docker Desktop,再选择Ollama容器后下载运行,这个容器有仅包含客户端的版本,和直接在容器内运行Ollama的版本,请大家自行选择。

使用

1、在运行命令后,直接在命令行运行聊天。

2、或使用网页: http://localhost:8505

不管理用哪种方式,都需要运行Docker来启动后台网站服务。

3、关于是否启用GPU加速,主要影响性能。文章来源:https://www.toymoban.com/news/detail-859008.html

https://ollama.com/blog/ollama-is-now-available-as-an-official-docker-image文章来源地址https://www.toymoban.com/news/detail-859008.html

到了这里,关于Mac x86 Ollama使用入门的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!