第1关:安装Spark

bash -c "$(curl -fsSL https://gitee.com/tianzhen2647/bash/raw/master/Spark%E7%8E%AF%E5%A2%83%E6%90%AD%E5%BB%BA%E4%B8%8E%E4%BD%BF%E7%94%A8/1.sh)"

第2关(略,很简单,不适合脚本)

第3关:通过Spark API编写一个独立应用程序

bash -c "$(curl -fsSL https://gitee.com/tianzhen2647/bash/raw/master/Spark%E7%8E%AF%E5%A2%83%E6%90%AD%E5%BB%BA%E4%B8%8E%E4%BD%BF%E7%94%A8/3.sh)"

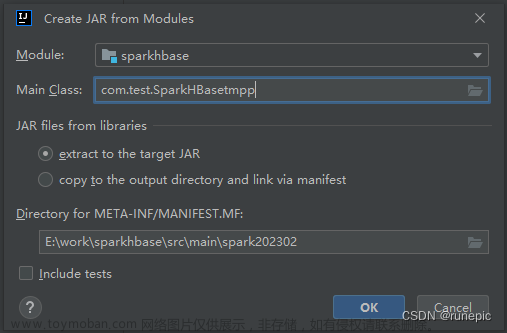

第4关:使用Maven对Java独立应用程序进行编译打包

bash -c "$(curl -fsSL https://gitee.com/tianzhen2647/bash/raw/master/Spark%E7%8E%AF%E5%A2%83%E6%90%AD%E5%BB%BA%E4%B8%8E%E4%BD%BF%E7%94%A8/4.sh)"

第5关:使用Maven对Scala独立应用程序进行编译打包

bash <(curl -sSL https://gitee.com/tianzhen2647/bash/raw/master/Spark%E7%8E%AF%E5%A2%83%E6%90%AD%E5%BB%BA%E4%B8%8E%E4%BD%BF%E7%94%A8/5.sh)

文章来源地址https://www.toymoban.com/news/detail-859537.html

文章来源:https://www.toymoban.com/news/detail-859537.html

到了这里,关于(头哥)Spark环境搭建与使用的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!