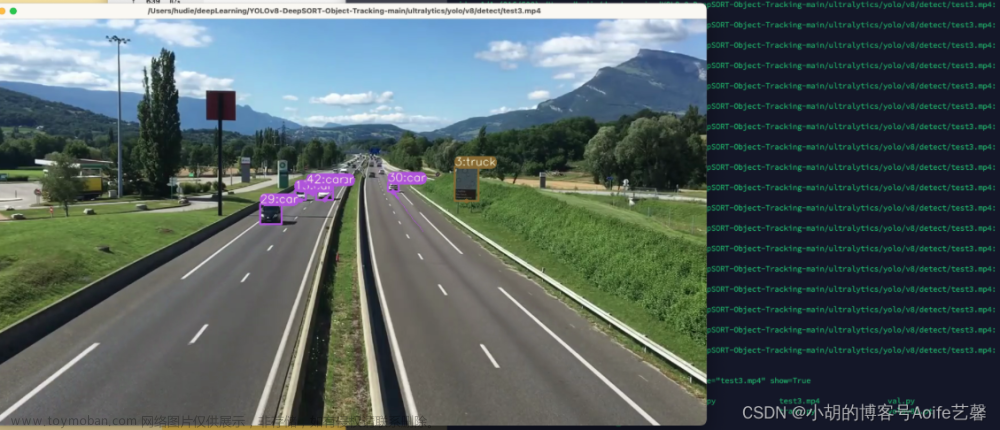

具体实现:

鼠标不点击目标,不发送任何信息,图像显示的是yolov8检测目标的所有结果

鼠标点击后,跟踪鼠标选择的目标并实时循环发布目标的坐标信息,图像显示的是目标的坐标框

若选择的目标丢失在摄像头内,暂停发送坐标信息,且图像显示的是yolov8检测目标的所有结果,等待鼠标下次点击,选择目标

实现思路:

用opencv调用摄像头

加载yolov8 track模式

Yolov8的results的plot()方法,绘制结果图片

给绘制的结果图片添加窗名

opencv鼠标响应函数绑定操作的窗口

编写鼠标响应的回调函数

编写选择目标框的一个算法

使用opencv在图像上画矩形框的函数 rectangle函数 使用方法见:python-opencv第五期:rectangle函数详解

发送选择目标的坐标信息,并只显示跟踪的目标的目标框

视频演示:

yolov8目标跟踪,坐标发送文章来源:https://www.toymoban.com/news/detail-860272.html

代码附下,含详细注释,供大家参考学习。创作不易,如有错误,欢迎大家指正,敬请谅解。文章来源地址https://www.toymoban.com/news/detail-860272.html

#!/usr/bin/env python

import cv2

from ultralytics import YOLO

import numpy as np

import rospy

from communication_yolo.msg import yolomsg

def onMouse(event, x, y, flags,param): #鼠标回调函数,每点击鼠标响应一次,所做出的动作即:选择出目标框并发送目标框的坐标信息

global start_x, start_y,n,is_mouse_clicked,boxes_id

start_x, start_y = -1, -1 #每次执行鼠标响应函数前,将坐标归零

if event == cv2.EVENT_LBUTTONDOWN: #鼠标左键下降沿触发

start_x, start_y = x, y

n = chooseobj(point, start_x, start_y) #调用选择目标框函数,传入所有目标框坐标二维列表point、鼠标点击时的坐标start_x、start_y

boxes_id = results[0].boxes[n].id #获取点击鼠标时,目标的id

is_mouse_clicked=True #记录鼠标点击的标志,为if条件判断作准备

def chooseobj(p,start_x,start_y): #选择目标框的函数,取目标框中心点与鼠标响应时坐标最短距离的目标框的编号

point_center = list() #创建列表,存储计算得来的所有目标框的中心点(为一个二维的列表)

i = 0

while i < len(p):

point_center.append([int((p[i][2] - p[i][0]) / 2 + p[i][0]), int((p[i][3] - p[i][1]) / 2 + p[i][1])]) #求各个boxes的中心点坐标,并依次赋值于列表

i=i+1

distance = list() #创建列表,存放各个目标框中心点距离与鼠标响应时坐标的距离

m = 0

while m < len(p):

pixe1 = np.array([start_x, start_y]) #鼠标响应时坐标

pixe2 = np.array([point_center[m][0], point_center[m][1]]) #各个目标框中心点坐标

distance.append(cv2.norm(pixe1, pixe2)) #计算各个目标框中心点与鼠标响应时坐标的距离(即两个像素点的距离)

m=m+1

minimum = min(distance) #找各个目标框距离列表中的最小值

boxes_index = distance.index(minimum) #通过列表索引,将最小值对应的列表下表返回

return boxes_index

rospy.init_node("yolo_ros_pub") #初始化Ros节点

pub = rospy.Publisher("yolomsg",yolomsg,queue_size=10) #创建发布对象,指定发布方的话题和消息类型

# Load the YOLOv8 model

model = YOLO("/home/zzb/yolov8_ws/src/communication_yolo/yolov8_main/yolov8n.pt") #加载yolo的模型权重

# Open the video file

cap = cv2.VideoCapture(0)

# Loop through the video frames

#初始化参数

is_mouse_clicked=False

n = 0

boxes_id=0

while cap.isOpened():

# Read a frame from the video

success, frame = cap.read()

if success:

# Run YOLOv8 inference on the frame

results = model.track(source=frame,persist=True)

# 将Tensor类型的xy坐标数据转为一个二维列表,外层列表长度为识别目标boxes的个数,内层为xyxy四个目标坐标信息

point = results[0].boxes.xyxy.tolist()

#确保results是否有目标,且由于point 是实时刷新的,防止出现之前点击选择的n很大,而导致下面实时索引results[0].boxes[n].id时n超出范围的bug,即:使n与results的n实时绑定

#且鼠标选择了目标且确保发送目标框坐标信息,是自己之前点击的id,就发送信息

if n<len(point) and is_mouse_clicked and results[0].boxes[n].id == boxes_id:

msg = yolomsg() #创建自定义消息的对象

msg.xmin= int(point[n][0]) #赋值选择出的目标框的四个坐标信息

msg.ymin = int(point[n][1])

msg.xmax =int(point[n][2])

msg.ymax = int(point[n][3])

pub.publish(msg) #发送消息

annotated_copy = frame.copy()

x_min, y_min, x_max, y_max = map(int, point[n]) # Extract coordinates

annotated_results = cv2.rectangle(annotated_copy, (x_min, y_min), (x_max, y_max), (0, 255, 0), 2) #opencv画矩形框的函数,根据选择的目标的坐标画矩形框

cv2.imshow("YOLOv8 Inference", annotated_results)

else :

# Visualize the yolov8 results on the frame

annotated_frame = results[0].plot() #Yolov8的results的plot()方法,绘制结果图片

# Display the annotated frame

cv2.imshow("YOLOv8 Inference", annotated_frame)

is_mouse_clicked = False #results无目标就将鼠标点击置0等待下次点击

cv2.setMouseCallback("YOLOv8 Inference", onMouse) #while循环监听opencv鼠标响应函数

# Break the loop if 'q' is pressed

if cv2.waitKey(1) & 0xFF == ord("q"):

break

else:

# Break the loop if the end of the video is reached

break

# Release the video capture object and close the display window

cap.release()

cv2.destroyAllWindows()到了这里,关于yolov8跟踪模式部署Ros系统上,跟踪鼠标选择的目标,实时发布目标的坐标信息(python实现)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!