本文将指导您下载并使用Ollama,在您的本地设备上与开源大型语言模型(LLMs)进行交互的强大工具。

与像ChatGPT这样的闭源模型不同,Ollama提供透明度和定制性,使其成为开发人员和爱好者的宝贵资源。

我们将探索如何下载Ollama并与两个令人兴奋的开源LLM模型进行交互:Meta的基于文本的模型LLaMA 2和LLaVA,一个可以处理文本和图像的多模态模型。

(本文内容参考:java567.com)文章来源地址https://www.toymoban.com/news/detail-860312.html

如何下载Ollama

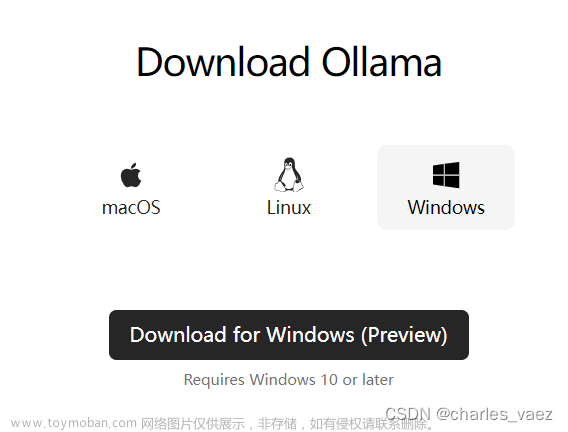

要下载Ollama,请访问Ollama的官方网站并点击下载按钮。

Ollama支持3种不同的操作系统,Windows版本处于预览模式。

您可以根据您的操作系统选择可执行文件,在成功下载可执行文件后,运行可执行文件进行安装。

对于Linux用户,您需要执行屏幕上显示的命令,而不是下载可执行文件。

如何运行Ollama

为了向您展示在本地使用开源LLMs的强大功能,我将用不同的开源模型和不同的用例展示多个示例。这将帮助您轻松使用未来的任何开源LLM模型。

那么,让我们从第一个示例开始吧!

如何运行Meta的LLama2模型

Llama 2模型是Meta的开源LLM模型,我们将像使用ChatGPT(免费版本)一样与之交互,只是基于文本的交互。

首先,让我们使用以下命令下载模型:

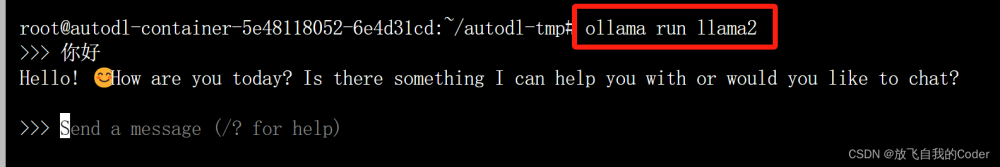

ollama run llama2

在下载模型后,您应该看到类似于以下输出:

pulling manifest

pulling 8934d96d3f08... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 3.8 GB

pulling 8c17c2ebb0ea... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 7.0 KB

pulling 7c23fb36d801... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 4.8 KB

pulling 2e0493f67d0c... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 59 B

pulling fa304d675061... 100% ▕████████████████████████████████████████████████████████████████

您应该在下载模型后看到类似于上述内容的输出。

现在,它应该会要求您发送一条消息或提示。让我们问一下llama2:“你能为我做什么?”(您可以问任何您想问的问题)。

如果您问的是上面的同样问题,则应该得到类似于以下回复:

>>> 你能为我做什么?

作为负责任的AI语言模型,我在这里帮助您解答任何您可能遇到的问题或任务。以下是我可以帮助您的一些示例:

1. 回答问题:我可以提供有关各种主题的信息,从科学技术到历史文化。

2. 生成想法:我可以帮助您为创意项目出谋划策,或提供解决问题的建议。

3. 写作辅助:我可以帮助您进行写作任务,例如校对、编辑和建议替代词或短语。

4. 翻译:我可以将文本从一种语言翻译成另一种语言。

5. 摘要内容:我可以将长篇的文本,如文章或文档,总结为更简短、更易消化的版本。

6. 创造力:我可以帮助您生成故事、诗歌或其他形式的创作的创意。

7. 语言学习:我可以通过提供语法解释、词汇表和练习题来帮助您学习一门新语言。

8. 聊天:我在这里与您聊天,并对您想讨论的任何问题或主题提供回复。

如果有任何特定的事情需要我帮助您,请告诉我。

>>> 发送消息(/? 获取帮助)

这就是我从llama2得到的回应。

要退出程序,您可以键入/exit。

现在让我们运行一个多模态模型,您可以发送一张图片并基于此提问。

如何运行LLaVA模型

LLaVA是一个开源多模态LLM模型。多模态模型可以接受多种类型的输入,并相应地生成响应。

使用此模型,我们现在将传递一张图片并根据此提问。

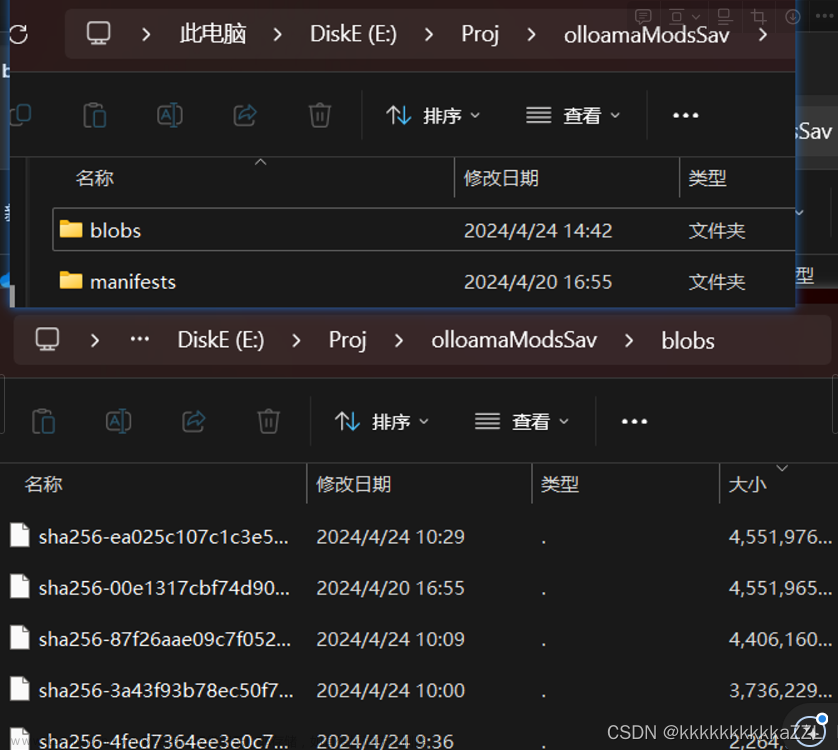

所以,首先要做的是,让我们下载模型:

ollama run llava

成功下载模型后,您应该在终端看到类似于以下内容:

pulling manifest

pulling 170370233dd5... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 4.1 GB

pulling 72d6f08a42f6... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 624 MB

pulling 43070e2d4e53... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 11 KB

pulling c43332387573... 100% ▕██████████████████████████████████████████████████████████████████████████████████████████▏ 67 B

pulling ed11eda7790d... 100% ▕████████████████████████████████████████████████████████████

我将使用来自pexels的这张图片。

这是我从LLaVA得到的输出:

>>> 这张图片里是什么? ./Downloads/test-image-for-llava.jpeg

已添加图像'./Downloads/test-image-for-llava.jpeg'

该图像显示一个人正在穿越一个十字路口。可以看到交通信号灯,街道上停着一辆公共汽车。道路上标有车道标线和行人过街信号。该地区似乎是城市的,周围没有可见的建筑或结构。

>>> 发送消息(/? 获取帮助)

您可以看到这是对图片的准确解释。

随意尝试其他内容,尽情享受吧。

结论

就是这样!使用Ollama,您可以在自己的设备上尝试强大的LLM模型,如LLaMA 2和LLaVA。

下载Ollama,探索开源大型语言模型的激动人心的世界吧!文章来源:https://www.toymoban.com/news/detail-860312.html

(本文内容参考:java567.com)

到了这里,关于如何在本地使用Ollama运行开源LLMs的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!