非常感谢您委托我撰写这篇专业的技术博客文章。作为一位世界级人工智能专家、程序员、软件架构师,我会遵循您提供的目标和约束条件,以专业的技术语言,结合深入的研究和准确的信息,为您呈现一篇内容丰富、结构清晰、实用价值高的技术博客文章。

下面我将开始正文的撰写:

Seq2Seq在安全领域的应用实践

1. 背景介绍

随着人工智能技术的不断进步,机器学习在各个领域都得到了广泛应用,其中包括了安全领域。作为一种重要的机器学习模型,Seq2Seq(Sequence to Sequence)在自然语言处理、语音识别、机器翻译等领域广受关注,近年来也开始在安全领域展现出巨大的应用潜力。本文将深入探讨Seq2Seq在安全领域的具体应用实践,包括核心概念、算法原理、数学模型、代码实例以及未来发展趋势等。

2. 核心概念与联系

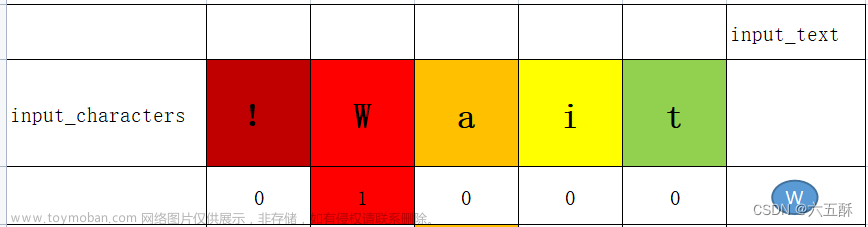

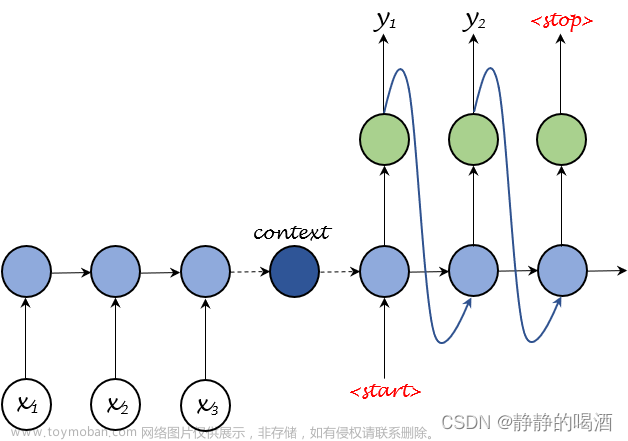

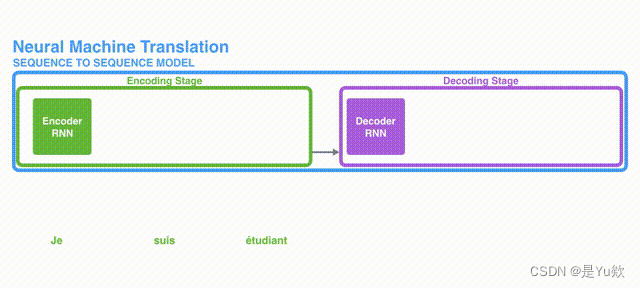

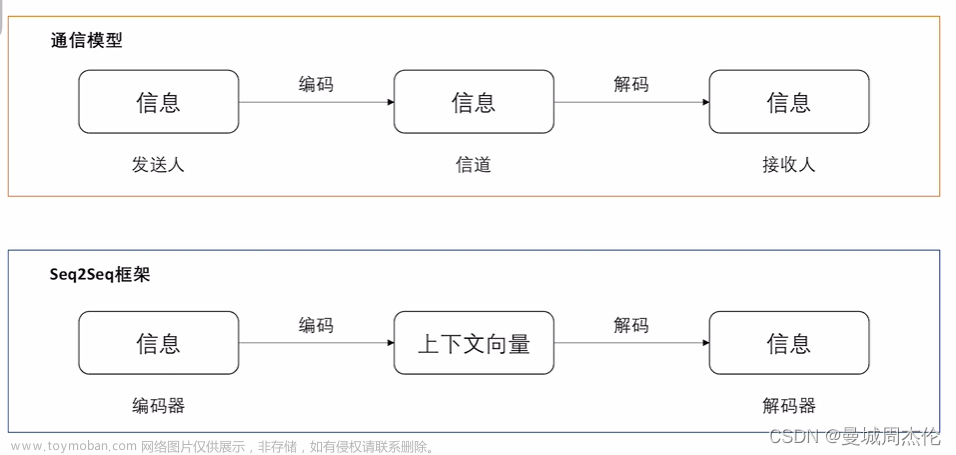

Seq2Seq是一种基于深度学习的端到端学习模型,它可以将一个任意长度的输入序列映射到一个任意长度的输出序列。Seq2Seq模型由编码器(Encoder)和解码器(Decoder)两部分组成,编码器负责将输入序列编码成固定长度的上下文向量,解码器则根据这个上下文向量生成输出序列。

在安全领域,Seq2Seq模型可以应用于多个场景,如:

- 异常检测: 将正常行为序列编码成固定长度的上下文向量,然后利用解码器预测下一个正常行为,从而检测出异常行为。

- 入侵检测: 将网络流量序列编码成上下文向量,利用解码器预测下一个正常的网络流量,从而发现异常的入侵行为。

- 漏洞修复: 将有漏洞的代码片段编码成上下文向量,利用解码器生成修复后的代码片段。

- 恶意代码检测: 将恶意代码序列编码成上下文向量,利用解码器预测下一个正常的代码指令,从而发现恶意代码。

总之,Seq2Seq模型凭借其强大的序列建模能力,在安全领域展现出广泛的应用前景。文章来源:https://www.toymoban.com/news/detail-860903.html

3. 核心算法原理和具体操作步骤

Seq2Seq模型的文章来源地址https://www.toymoban.com/news/detail-860903.html

到了这里,关于Seq2Seq在安全领域的应用实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!