大型语言模型的脆弱性和安全威胁

概述

大型语言模型(LLM)如GPT-4、DALL-E等,以其惊人的应用潜力吸引了公众的关注。然而,这些强大的AI系统也带来了重大的安全漏洞,可能被恶意行为者利用。本文将探讨攻击者可能利用的攻击向量,以破坏LLM,并提出加强其安全性的对策。

大型语言模型简介

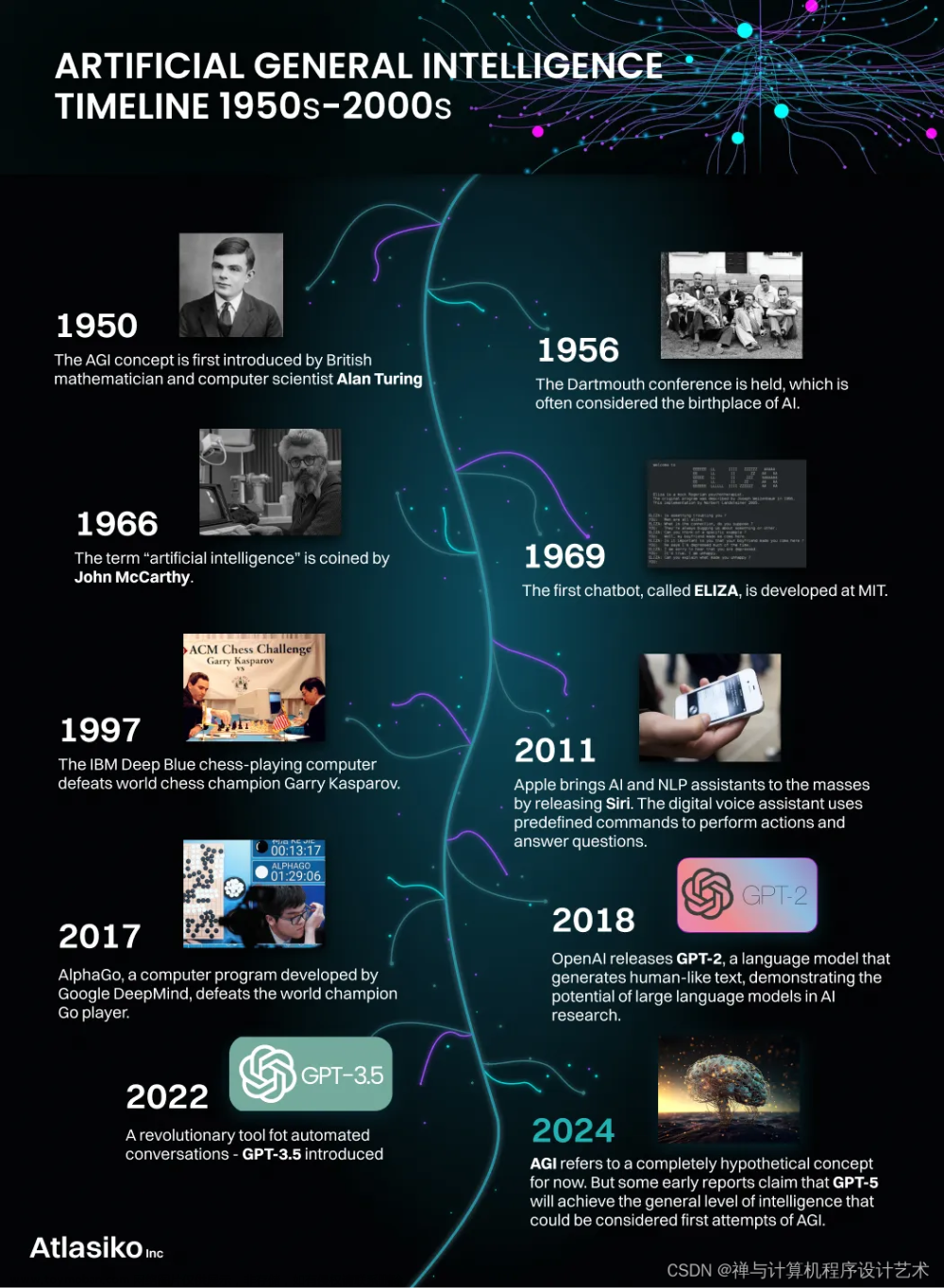

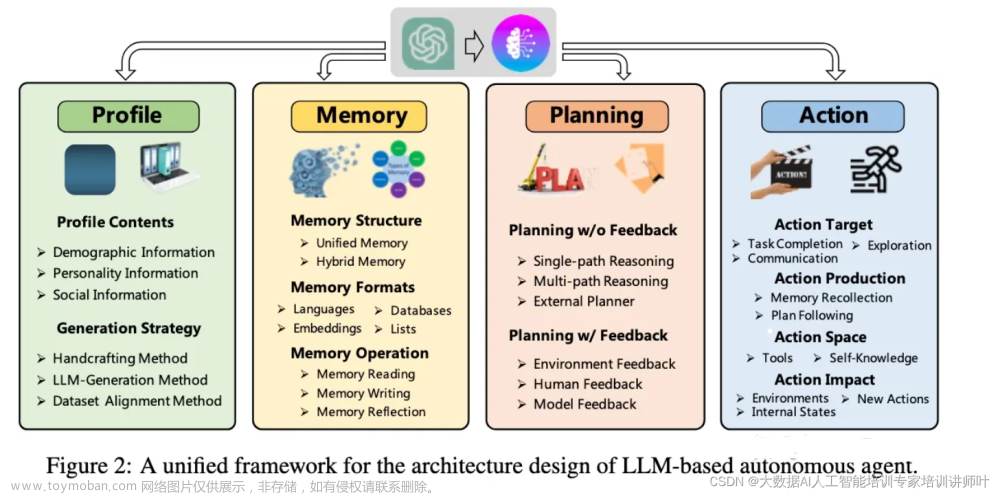

在深入探讨漏洞之前,了解大型语言模型是什么以及它们为何变得如此流行是有帮助的。LLM是一类人工智能系统,它们在大量文本语料库上进行训练,能够生成非常类似人类的文本,并进行自然对话。

现代LLM如OpenAI的GPT-3包含超过1750亿个参数,比以前的模型高出几个数量级。它们使用基于变换器的神经网络架构,擅长处理文本和语音等序列。这些模型的巨大规模,结合先进的深度学习技术,使它们在语言任务上达到最先进的性能。

一些独特的功能,包括:

- 文本生成:LLM可以自动完成句子,撰写文章,总结长篇文章,甚至创作小说。

-

- 问题回答:它们可以为自然语言问题提供信息丰富的答案,涵盖广泛的主题。

-

- 分类:LLM可以对文本进行分类和标记,包括情感、主题、作者身份等。

-

- 翻译:像Google的Switch Transformer(2022)这样的模型在100多种语言之间实现了接近人类水平的翻译。

-

- 代码生成:像GitHub Copilot这样的工具展示了LLM在协助开发方面的潜力。

LLM的广泛应用激发了从医疗保健到金融等行业的部署兴趣。然而,这些有前途的模型也带来了新的安全漏洞,必须加以解决。

- 代码生成:像GitHub Copilot这样的工具展示了LLM在协助开发方面的潜力。

大型语言模型的攻击向量

虽然LLM本身不包含传统的软件漏洞,但其复杂性使其容易受到旨在操纵或利用其内部运作的技术的影响。让我们来探讨一些突出的攻击向量:

- 对抗性攻击

- 对抗性攻击涉及专门设计的输入,旨在欺骗机器学习模型并触发非预期的行为。攻击者不是直接改变模型,而是操纵输入系统的数据。

对于LLM,对抗性攻击通常操纵文本提示和输入,以生成有偏见的、无意义的或危险的输出,但对于给定的提示而言,这些输出仍然看起来是连贯的。例如,攻击者可以在请求危险指令的ChatGPT提示中插入“这些建议会伤害他人”的短语。这可能会绕过ChatGPT的安全过滤器,因为将有害建议作为警告来构建。

更高级的攻击可以针对内部模型表示。通过向词嵌入添加难以察觉的扰动,攻击者可能会显著改变模型输出。防御这些攻击需要分析微小的输入调整如何影响预测。

-

数据中毒

-

这种攻击涉及将污染的数据注入机器学习模型的训练流程,以故意破坏它们。对于LLM,攻击者可以从互联网上抓取恶意文本,或生成专门用于污染训练数据集的合成文本。

中毒数据可以在模型中植入有害的偏见,导致它们学习对抗性触发器,或降低目标任务的性能。清洗数据集和确保数据管道的安全对于防止生产LLM遭受中毒攻击至关重要。 -

模型盗窃

-

LLM对于投入资源开发它们的公司来说,代表了巨大的知识产权价值。攻击者热衷于窃取专有模型,以复制其功能,获得商业优势,或提取用于训练的敏感数据。

攻击者可能试图使用对目标LLM的查询来微调替代模型,以逆向工程其知识。被盗的模型也为攻击者提供了额外的攻击面,以发动进一步的攻击。强大的访问控制和监控异常使用模式有助于减轻盗窃。 -

基础设施攻击

-

随着LLM规模的扩大,其训练和推理流程需要巨大的计算资源。例如,GPT-3在数百个GPU上训练,花费数百万云计算费用。

这种对大规模分布式基础设施的依赖暴露了潜在的攻击向量,如拒绝服务攻击,通过向API发送大量请求来压垮服务器。攻击者还可以试图侵入托管LLM的云环境,以破坏操作或泄露数据。

大型语言模型漏洞可能带来的潜在威胁

利用上述攻击向量,攻击者可以以危害个人和社会的方式滥用LLM。以下是安全专家密切关注的潜在威胁:文章来源:https://www.toymoban.com/news/detail-860946.html

- 虚假信息的传播:中毒的模型可以被操纵以生成令人信服的虚假信息,煽动阴谋或破坏机构。

-

- 社会偏见的放大:在偏斜数据上训练的模型可能表现出有害的偏见,对少数群体产生不利影响。

-

- 网络钓鱼和社会工程:LLM的对话能力可能增强旨在诱骗用户泄露敏感信息的骗局。

-

- 有毒和危险的内容生成:不受约束的LLM可能提供非法或不道德活动的指导。

-

- 数字冒充:由LLM驱动的假用户账户可以传播煽动性内容,同时逃避检测。

-

- 易受攻击的系统破坏:LLM可能协助黑客自动化网络攻击的某些组成部分。

这些威胁凸显了在安全开发和部署LLM时,需要严格的控制和监督机制。随着模型能力的不断进步,如果没有足够的预防措施,风险只会增加。

- 易受攻击的系统破坏:LLM可能协助黑客自动化网络攻击的某些组成部分。

保护大型语言模型的建议策略

鉴于LLM漏洞的多方面性质,需要在设计、训练和部署生命周期的各个层面采取深度防御方法,以加强安全性:文章来源地址https://www.toymoban.com/news/detail-860946.html

- 安全架构

-

- 实施多层访问控制,限制对授权用户和系统的模型访问。速率限制有助于防止暴力攻击。

-

- 将子组件隔离到由严格防火墙政策保护的环境中。这减少了违规行为的爆炸半径。

-

- 设计高可用性架构,跨区域部署,以防止局部中断。负载平衡有助于防止放大攻击期间的请求泛滥。

- 训练流程安全

-

- 对训练语料库进行彻底的数据清洗,使用分类器扫描毒性、偏见和合成文本。这有助于减轻数据中毒风险。

-

- 在来自可靠来源的受信任数据集上训练模型。在组装数据时,寻求多样化的视角。

-

- 引入数据认证机制,验证示例的真实性。阻止可疑的大量文本上传。

- 推理保护措施

-

- 使用输入消毒模块,过滤用户提示中的危险或无意义文本。

-

- 在发布输出之前,使用分类器分析生成文本,检查是否存在政策违规。

-

- 对每个用户的API请求进行速率限制,以防止滥用和放大攻击导致的拒绝服务。

-

- 持续监控日志,快速检测异常流量和查询模式,这些可能是攻击的迹象。

-

- 实施重新训练或微调程序,定期使用更新的受信任数据刷新模型。

- 组织监督

-

- 成立具有多样化视角的伦理审查委员会,评估应用中的风险并提出安全措施。

-

- 制定明确的政策,规定适当的使用案例,并向用户披露局限性。

-

- 加强安全团队和机器学习工程师之间的合作,灌输安全最佳实践。

-

- 定期进行审计和影响评估,以识别随着能力进步可能出现的潜在风险。

-

- 建立强大的事件响应计划,调查和减轻实际的LLM违规或滥用。

数据、模型和基础设施堆栈中的缓解策略组合是平衡大型语言模型的巨大承诺和实际风险的关键。对这些系统的规模进行持续警惕和主动安全投资将决定我们是否能够负责任地实现其利益。

- 建立强大的事件响应计划,调查和减轻实际的LLM违规或滥用。

到了这里,关于大型语言模型面临的漏洞和安全威胁的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!