概述

在数据驱动和定位的世界中,对数据进行解释、可视化和决策的能力变得日益重要。这表明,使用正确的工具和技术可能是项目成功的关键。在计算机视觉领域,存在许多技术来解释从视频(包括录像、流媒体或实时视频)中获取的数据,特别是在评估需要分析交通强度或某些对象(如人、车辆、动物等)行为的区域时,热力图是一个极其有效的选择。

物体运动热力图可以展示物体在一段时间内的运动轨迹和活动强度。这种图表通常通过颜色的变化来表示不同区域的运动热度,颜色的深浅代表了物体在该区域的运动频率或者速度的快慢。在物理学和计算机视觉领域,热力图可以用于分析和理解物体的运动模式,例如人流监控、交通流量分析或者运动员的运动轨迹分析。

在传统的计算机视觉图像处理,使用OpenCV库背景减除法来识别和追踪视频中的移动物体,然后将这些信息累积起来,形成热力图。可以有效地突出显示物体运动的高频区域,帮助研究者或分析师更好地理解物体的运动模式,但传统的计算机视觉图像处理在一些场景变化比较的情况下,性能并不理想。

在多目标跟踪(MOT)领域,Tracking-by-detection它可以依赖于目标检测器来识别视频中的每个目标,然后使用跟踪算法来关联检测结果,形成目标的连续轨迹。这种方法的关键在于如何有效地关联来自不同帧的检测框,以便为每个目标创建准确且连贯的轨迹。

Yolov8集成了BYTE方法,BYTE是一种创新的数据关联方法,它旨在提高多目标跟踪的准确性和连贯性。BYTE方法通过利用检测框和跟踪轨迹之间的相似性,可以在保留高置信度检测结果的同时,从低置信度检测结果中去除背景噪声,并挖掘出真正的物体。这对于处理遮挡、模糊等困难样本特别有效,因为这些情况下的目标检测往往更加具有挑战性。

BYTE能够降低漏检率并提高轨迹的连贯性。可以轻松地应用于多种现有的state-of-the-art MOT方法中,并且能够提升这些方法的IDF1指标,这表明了其强大的通用性和有效性。

基于BYTE方法,提出的跟踪方法ByteTrack进一步展示了其在MOT任务中的潜力。ByteTrack在保持高运行速度(30 FPS)的同时,在MOT17基准测试上取得了显著的性能提升,包括80.3的MOTA(Multiple Object Tracking Accuracy)、77.3的IDF1和63.1的HOTA(High Order Track Accuracy)。这些结果表明,ByteTrack在处理多目标跟踪任务时,不仅能够准确地关联检测框,还能够有效地处理目标间的交互和复杂场景,从而实现高精度的轨迹跟踪。

实现效果:

基于yolov8与OpenCV实现目标物体运动热力图

基于Yolov8的运动热力图

1.环境安装

conda create -n yolov8 python=3.8

activate ylolv8

pip install ultralytics

2.下载模型

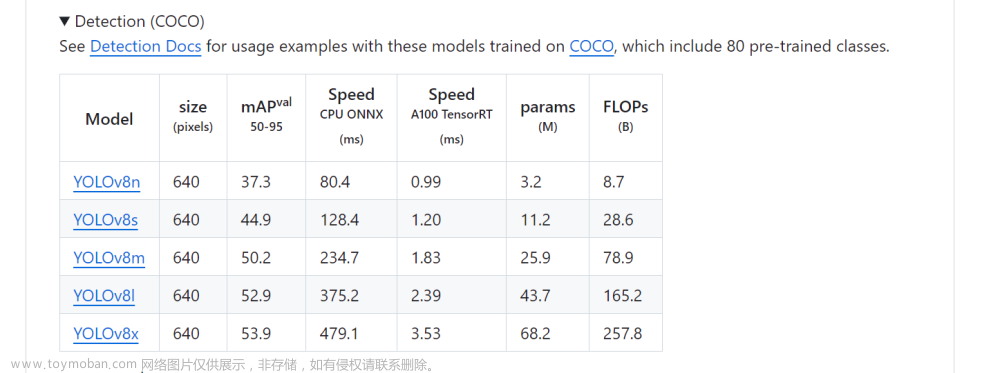

可以从官网上下载需要的模型,官网提供了几种不同尺寸的模型:

3.项目实践步骤

这里以一段航拍视频为例,视频是用俯视的一个三叉路口,目标是创建一个热力图来展示这三条路汽车流量密集热力图。实现步骤如下:

目标检测:首先,需要对视频进行分析,识别出视频中的车辆以及它们在每帧中的位置

轨迹跟踪:通过多目标跟踪BYTE方法,关联视频中连续帧中检测到的车辆,形成每个车辆的轨迹。

数据关联:利用检测框和跟踪轨迹之间的相似性,去除背景噪声,挖掘出真正的车辆,降低漏检并提高轨迹的连贯性。

热力图生成:将检测到的车辆位置信息汇总,并使用热力图库来生成热力图。热力图通过颜色的深浅来表示车辆密度的高低。

4.代码实践

导入需要的库

from collections import defaultdict

import cv2

import numpy as np

from ultralytics import YOLO

调用Yolo目标检测的模型,

model = YOLO('yolov8s.pt')

读取视频

videopath = 'video.mp4'

cap = cv2.VideoCapture(videopath)

现在创建一个空字典来存储跟踪位置(‘track_history’)和一个字典来存储每个对象的最后推断位置(‘last_positions’)。

track_history = defaultdict(lambda: [])

last_positions = {}

在计算机视觉和视频分析中,涉及点跟踪或对象运动的场景时,需要计算两个点之间的欧几里得距离。欧几里得距离是两点之间的直线距离,可以通过勾股定理来计算。在二维空间中,如果两点的坐标分别是 p 1 ( x 1 , y 1 ) p1(x_1, y_1) p1(x1,y1)和 p 2 ( x 2 , y 2 ) p2(x_2, y_2) p2(x2,y2),那么它们之间的欧几里得距离 d d d可以通过以下公式计算:

d = ( x 2 − x 1 ) 2 + ( y 2 − y 1 ) 2 d = \sqrt{(x_2 - x_1)^2 + (y_2 - y_1)^2} d=(x2−x1)2+(y2−y1)2

在Python中,你可以很容易地实现这个计算,以下是一个简单的函数示例:

def calculate_distance(p1, p2):

return np.sqrt((p1[0] - p2[0]) ** 2 + (p1[1] - p2[1]) ** 2)

这个函数euclidean_distance接受两个点作为输入,每个点由其在二维空间中的(x, y)坐标定义。函数计算并返回这两个点之间的直线距离。

在视频分析中,你可能需要比较连续视频帧中的对象位置,以确定它们是否为同一个对象,或者评估对象的运动速度。通过计算连续帧中对象位置的欧几里得距离,可以对对象的运动进行量化分析。如果距离很小,这可能表明对象几乎没有移动;如果距离较大,这可能表明对象在两帧之间有显著的移动。这种方法有助于过滤掉静止的对象(如停放的车辆),只关注移动的对象。

首先,使用numpy库初始化一个热力图,该图是一个三维矩阵,其所有元素初始值都为零。这个矩阵具有三个“层”,分别对应RGB颜色通道。

import numpy as np

# 初始化热力图,尺寸与视频帧的高和宽相匹配,具有三个颜色通道

heatmap = np.zeros((int(cap.get(4)), int(cap.get(3)), 3), dtype=np.float32)

接下来,进入一个while循环,该循环将持续运行,直到视频处理完毕。

while cap.isOpened():

success, frame = cap.read()

if not success:

break # 如果无法读取帧,则退出循环

对于成功读取的每一帧,我们利用YOLO模型进行对象检测和跟踪。这里使用了跟踪和持久性算法,这对于处理视频帧序列非常有效。由于本例专注于车辆交通记录,我们只定义了两类对象。

if success:

# 利用YOLO模型对帧进行对象检测和跟踪

results = model.track(frame, persist=True, classes=2)

对于每一次有效的检测,更新热力图,记录对象的边界框坐标。

# 假设results['boxes']和results['track_ids']包含了检测结果的边界框和跟踪ID

for box, track_id in zip(results['boxes'], results['track_ids']):

x_center, y_center, width, height = box

current_position = (float(x_center), float(y_center))

使用calculate_distance函数来检查对象是否在移动,并根据移动的距离更新热力图。

last_position = last_positions.get(track_id)

if last_position and calculate_distance(last_position, current_position) > 5:

# 如果对象移动的距离超过最小值,则在热力图上进行记录

heatmap[top_left_y:bottom_right_y, top_left_x:bottom_right_x] += 1

# 更新对象的最后位置记录

last_positions[track_id] = current_position

为了提升视觉效果,对热力图应用高斯模糊滤镜。

# 对热力图应用高斯模糊,以增强视觉效果

heatmap_blurred = cv2.GaussianBlur(heatmap, (15, 15), 0)

随后,对热力图进行归一化处理,并应用颜色映射,以便在原始视频帧上进行叠加。

# 归一化热力图并应用颜色映射,以便在视频帧上叠加

heatmap_norm = cv2.normalize(heatmap_blurred, None, 0, 255, cv2.NORM_MINMAX, dtype=cv2.CV_8U)

heatmap_color = cv2.applyColorMap(heatmap_norm, cv2.COLORMAP_JET)

最后,在while循环中,添加了一个退出键的检查,以便用户可以通过按键退出程序。视频处理完成后,释放视频捕获对象,并关闭所有OpenCV创建的窗口。

# 添加退出键检查,允许用户通过按键退出程序

if cv2.waitKey(1) & 0xFF == ord("q"):

break

# 视频处理完成后,释放资源并关闭窗口

cap.release()

cv2.destroyAllWindows()

通过上述步骤,能够创建一个动态的热力图,它不仅能够检测和跟踪视频中的对象,还能直观地展示对象的移动情况。

整体代码实现如下:文章来源:https://www.toymoban.com/news/detail-861569.html

from collections import defaultdict

import cv2

import numpy as np

from ultralytics import YOLO

def calculate_distance(p1, p2):

return np.sqrt((p1[0] - p2[0]) ** 2 + (p1[1] - p2[1]) ** 2)

def create_history(input_video,output_video,model_path):

model = YOLO(model_path)

cap = cv2.VideoCapture(input_video)

track_history = defaultdict(lambda: [])

last_positions = {}

heatmap = np.zeros((int(cap.get(4)), int(cap.get(3)), 3), dtype=np.float32)

fps = int(cap.get(5))

videoWriter = None

while cap.isOpened():

success, frame = cap.read()

if not success:

break

results = model.track(frame, persist=True, classes=2)

boxes = results[0].boxes.xywh.cpu()

track_ids = results[0].boxes.id.int().cpu().tolist()

for box, track_id in zip(boxes, track_ids):

x_center, y_center, width, height = box

current_position = (float(x_center), float(y_center))

top_left_x = int(x_center - width / 2)

top_left_y = int(y_center - height / 2)

bottom_right_x = int(x_center + width / 2)

bottom_right_y = int(y_center + height / 2)

top_left_x = max(0, top_left_x)

top_left_y = max(0, top_left_y)

bottom_right_x = min(heatmap.shape[1], bottom_right_x)

bottom_right_y = min(heatmap.shape[0], bottom_right_y)

track = track_history[track_id]

track.append(current_position)

if len(track) > 1200:

track.pop(0)

last_position = last_positions.get(track_id)

if last_position and calculate_distance(last_position, current_position) > 5:

heatmap[top_left_y:bottom_right_y, top_left_x:bottom_right_x] += 1

last_positions[track_id] = current_position

heatmap_blurred = cv2.GaussianBlur(heatmap, (15, 15), 0)

heatmap_norm = cv2.normalize(heatmap_blurred, None, 0, 255, cv2.NORM_MINMAX, dtype=cv2.CV_8U)

heatmap_color = cv2.applyColorMap(heatmap_norm, cv2.COLORMAP_JET)

alpha = 0.7

cv_dst = cv2.addWeighted(frame, 1 - alpha, heatmap_color, alpha, 0)

cv_resize = cv2.resize(cv_dst,(640,360))

if videoWriter is None:

fourcc = cv2.VideoWriter_fourcc('m', 'p', '4', 'v')

videoWriter = cv2.VideoWriter(output_video, fourcc, fps, (cv_resize.shape[1], cv_resize.shape[0]))

videoWriter.write(cv_resize)

cv2.imshow("Traffic Heatmap",cv_resize)

if cv2.waitKey(1) & 0xFF == ord("q"):

break

cap.release()

cv2.destroyAllWindows()

if __name__ == '__main__':

model_path = "yolov8s.pt"

create_history('11.mp4','21.mp4',model_path)

实现效果: 文章来源地址https://www.toymoban.com/news/detail-861569.html

文章来源地址https://www.toymoban.com/news/detail-861569.html

到了这里,关于Yolov8项目实践——基于yolov8与OpenCV实现目标物体运动热力图的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!