开源对抗性攻击库OpenAttack:强化你的AI安全实践

项目地址:https://gitcode.com/thunlp/OpenAttack文章来源地址https://www.toymoban.com/news/detail-861900.html

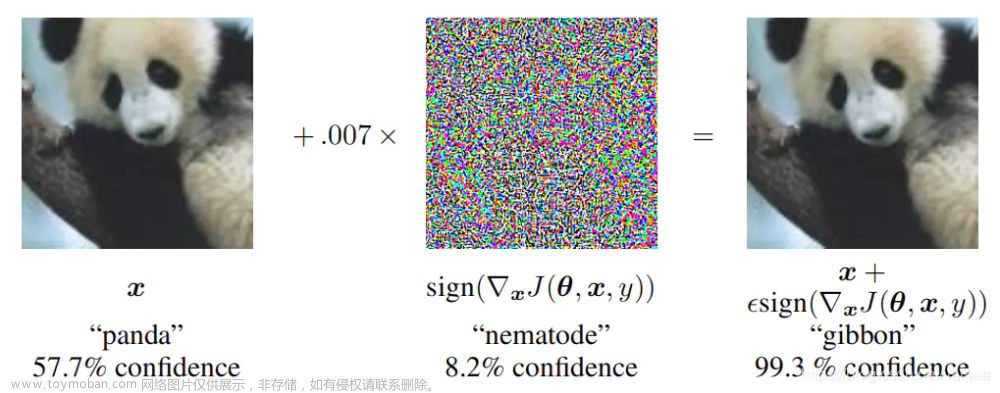

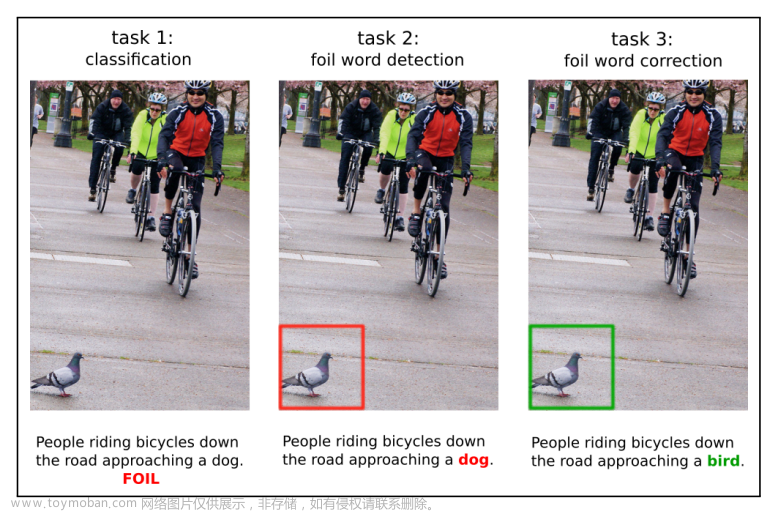

在人工智能领域,模型的安全性和鲁棒性日益受到关注。为了检验和提升AI模型的抗干扰能力,对抗性攻击是一种重要的手段。【项目名称】——OpenAttack,是由清华大学自然语言处理实验室(THUNLP)开发的开源Python库,旨在为研究者和开发者提供一个强大的工具集,用于执行各种类型的文本对抗性攻击。

项目简介

OpenAttack是一个全面的、易于使用的平台,它包含了多种已知的对抗性攻击算法,并且支持自定义攻击策略。该项目的目标是促进AI安全的研究,让开发者可以轻松地对自然语言处理(NLP)模型进行评估和优化。

技术分析

OpenAttack的核心特性包括:

-

丰富的攻击算法:提供了多种经典对抗性攻击方法,如TextFooler、DeepWordBug、HotFlip等,覆盖了基于替换、插入、删除等多种操作的攻击策略。

-

模块化设计:各个攻击算法被划分为不同的模块,如预处理器、生成器、后处理器,这使得新算法的集成变得简单且灵活。

-

兼容性:OpenAttack与多个流行的NLP框架(如Hugging Face Transformers、NLTK、spaCy等)兼容,方便在现有模型上直接应用对抗性攻击。

-

可扩展性:通过插件系统,用户可以轻松添加自己的攻击算法或者数据处理逻辑,扩展功能以满足特定需求。

-

评估工具:内置了一系列评估指标,帮助用户量化模型的鲁棒性并比较不同攻击的效果。

应用场景

OpenAttack可用于以下场景:

- 模型测试:对AI模型进行压力测试,找出其弱点和可能的漏洞。

- 训练增强:使用对抗性样本对模型进行训练,提高其抵御攻击的能力。

- 安全研究:探索新的对抗性攻击和防御策略,推动AI安全领域的进展。

特点

- 开源免费:OpenAttack遵循Apache 2.0许可证,完全开放给所有用户。

- 社区活跃:有来自全球的研究者和开发者贡献,持续更新和维护。

- 文档详尽:提供了详细的API文档和教程,便于快速上手。

- 示例丰富:包含多种示例代码,帮助用户了解如何有效地使用库中的功能。

结语

如果你正在寻求评估和提升你的人工智能系统的安全性,那么OpenAttack无疑是值得一试的强大工具。通过利用OpenAttack,你可以更好地理解模型的脆弱之处,并采取措施增强其鲁棒性。立即访问项目链接,开始你的AI安全探索之旅吧!文章来源:https://www.toymoban.com/news/detail-861900.html

项目地址:https://gitcode.com/thunlp/OpenAttack

到了这里,关于开源对抗性攻击库OpenAttack:强化你的AI安全实践的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!