低秩分解模型压缩

-

[算法前沿]--000-大模型LLaMA在docker环境搭建以及运行教程(含模型压缩)

未来已来,大模型依据压缩模型的方式,可以在普通的PC上运行. Facebook的LLaMA 模型和Georgi Gerganov 的llama.cpp的结合。 LLaMA,这是一组包含 7B 到 65B 参数的基础语言模型。我们在数万亿个令牌上训练我们的模型,并表明可以仅使用公开可用的数据集来训练最先进的模型,而无需诉诸

-

三维模型3DTILE格式轻量化压缩主要技术方法浅析

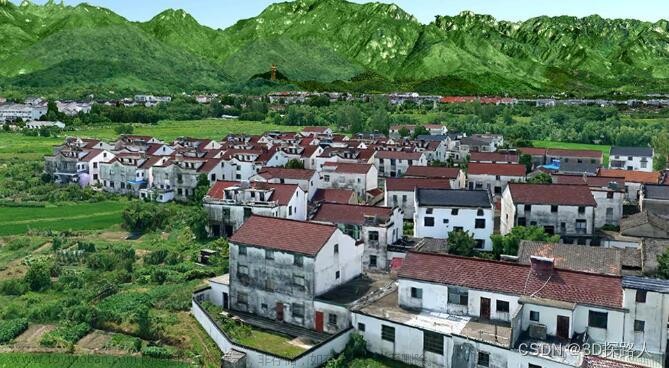

三维模型3DTILE格式轻量化压缩主要技术方法浅析 随着三维地理空间数据的应用日益广泛,为了更快速地传输和存储这些大规模数据,3DTile格式的轻量化压缩显得尤为重要。本文将浅析关于三维模型3DTile格式轻量化压缩的主要技术方法。 首先,我们需要理解3DTile的结构,它是

-

第八章:AI大模型的部署与优化8.1 模型压缩与加速8.1.2 量化与剪枝

作者:禅与计算机程序设计艺术 8.1.1 背景介绍 随着深度学习技术的不断发展,人工智能模型的规模越来越庞大。然而,这也带来了新的问题:大模型需要更多的计算资源和存储空间,同时在移动设备上运行效率较低。因此,模型压缩与加速成为了当前研究的热点。 8.1.2 核心

-

最高20倍!压缩ChatGPT等模型文本提示,极大节省AI算力

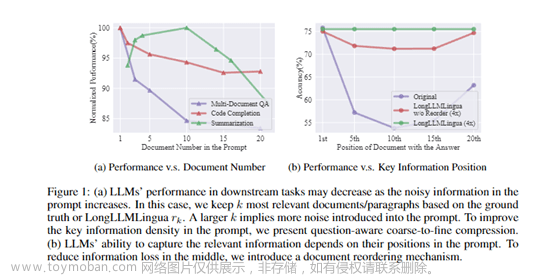

最高20倍!压缩ChatGPT等模型文本提示,极大节省AI算力_信息_段落_问题 在长文本场景中,ChatGPT 等大语言模型经常面临更高算力成本、更长的延迟以及更差的性能。为了解决这三大难题,微软开源了 LongLLMLingua。 据悉,LongLLMLingua 的核心技术原理是将“文本提示”实现最高 2

-

三维模型3DTile格式轻量化压缩处理效率提高的技术方浅析

随着三维模型在各个领域的广泛应用,对于其格式的轻量化压缩处理和效率提高的需求也越发迫切。本文将介绍一些技术方法,帮助实现三维模型3DTile格式的轻量化压缩处理并提高处理效率。 首先,针对三维模型的轻量化压缩处理,我们可以采用以下方法: 1、减少顶点数:

-

三维模型3DTile格式轻量化压缩文件大小的技术方法研究

倾斜摄影三维模型,由于数据量大、复杂度高,轻量化压缩成为其在网络传输和实时渲染中必不可少的环节。以下是几种常用的3DTile格式轻量化压缩技术方法: 几何简化:这是一种最基本也最广泛应用的轻量化压缩方法,主要通过减少模型的顶点数和面片数来降低模型的复杂

-

(最优化理论与方法)第一章最优化简介-第二节:最优化典型实例之稀疏优化和低秩矩阵恢复

考虑下面线性方程组的求解问题,其中 x ∈ R n , b ∈ R m xin R^{n},bin R^{m} x ∈ R n , b ∈ R m ,矩阵 A ∈ R m × n Ain R^{m×n} A ∈ R m × n ,且向量 b b b 的维数远小于向量 x x x 的维数,也即 m m m n n n A x = b Ax=b A x = b 在相关问题中,当我们建立这样的模型后,常常希望 解出向量

-

压缩gltf/glb模型踩坑与解决 three.js DRACOLoader

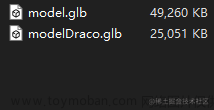

使用前端three.js加载3d模型过程中,往往会出现模型大小过大导致前端加载时间过长,降低用户体验。 本文所记录的是笔者在使用gltf-pipeline压缩3d模型中踩坑DRACOLoader与解决的一个过程。 所采用的three库版本为 ^0.138.2 通过gltf-pipeline可以大幅度压缩gltf/glb模型文件。 并且有如下

-

【分布鲁棒和多目标非负矩阵分解】基于DR-NMF的对NMF问题噪声模型的识别鲁棒性研究(Matlab代码实现)

💥💥💞💞 欢迎来到本博客 ❤️❤️💥💥 🏆博主优势: 🌞🌞🌞 博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。 ⛳️ 座右铭: 行百里者,半于九十。 📋📋📋 本文目录如下: 🎁🎁🎁 目录 💥1 概述 📚2 运行结果 🎉3 参考文献 🌈4 Matlab代码、数据、文章

-

【YOLOv7/YOLOv5系列算法改进NO.49】模型剪枝、蒸馏、压缩

作为当前先进的深度学习目标检测算法YOLOv7,已经集合了大量的trick,但是还是有提高和改进的空间,针对具体应用场景下的检测难点,可以不同的改进方法。此后的系列文章,将重点对YOLOv7的如何改进进行详细的介绍,目的是为了给那些搞科研的同学需要创新点或者搞工程

-

利用 device_map、torch.dtype、bitsandbytes 压缩模型参数控制使用设备

为了更好的阅读体验,请点击这里 以下内容参考 Huggingface Accelerate文档:超大模型推理方法 在 HuggingFace 中有个重要的是 device_map,它可以简单控制模型层部署在哪些硬件上。 设置参数 device_map=\\\"auto\\\" ,Accelerate会自动检测在哪个设备放置模型的哪层参数(自动根据你的硬

-

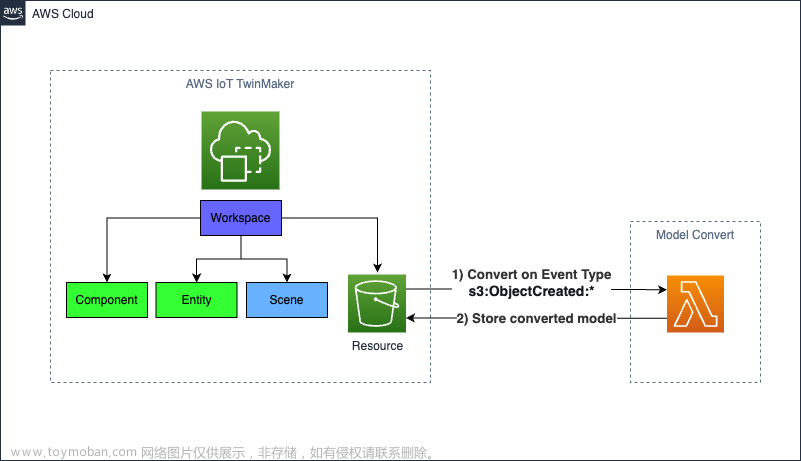

如何将 OBJ 模型转换和压缩为 GLTF 以与 AWS IoT TwinMaker 配合使用

推荐:使用NSDT场景编辑器快速搭建3D应用场景 在这篇博文中,引用了几种文件扩展名和模型格式。在开始之前,最好了解以下内容: OBJ – 对象文件,一种标准的 3D 图像格式,可以通过各种 3D 图像编辑程序导出和打开。 MTL – 材料库文件,包含一个或多个材料定义,每个定

-

大模型入局传统算法,LLMZip基于LLaMA-7B实现1MB文本压缩率90%!

论文链接: https://arxiv.org/abs/2306.04050 随着以 ChatGPT、GPT-4为代表的AI大模型 逐渐爆火进入公众视野,各行各业都开始思考如何更好的使用和发展自己的大模型,有一些评论甚至认为大模型是以人工智能为标志的第四次产业革命的核心竞争产品。 例如在5月26日的北京中关村202

-

目标检测YOLO实战应用案例100讲-道路场景下目标检测与分割模型的压缩研究与实现

目录 前言 目标检测方法 语义分割方法 相关理论基础 2.1 YOLO

-

【人工智能】大模型的本质:在超高维空间上对人类全部知识的高度压缩映射

在计算机科学和人工智能领域,大模型成为了当前研究的热门话题之一。大模型通常指拥有上亿参数数量的深度神经网络模型。近年来,GPT-3等巨型自然语言处理模型的出现,引起了广泛的关注和探讨。本文将从理论和实践两个角度,详细介绍大模型的本质和应用。 大模型是

-

人工智能领域:面试常见问题超全(深度学习基础、卷积模型、对抗神经网络、预训练模型、计算机视觉、自然语言处理、推荐系统、模型压缩、强化学习、元学习)

【深度学习入门到进阶】必看系列,含激活函数、优化策略、损失函数、模型调优、归一化算法、卷积模型、序列模型、预训练模型、对抗神经网络等 专栏详细介绍:【深度学习入门到进阶】必看系列,含激活函数、优化策略、损失函数、模型调优、归一化算法、卷积模型、

-

刀具磨损状态识别(Python代码,MSCNN_LSTM_Attention模型,初期磨损、正常磨损和急剧磨损分类,解压缩直接运行)

环境库: NumPy 版本: 1.19.4 Pandas 版本: 0.23.4 Matplotlib 版本: 2.2.3 Keras 版本: 2.4.0 TensorFlow 版本: 2.4.0 sklearn 版本: 0.19.2 如果库版本不一样, 一般也可以运行,这里展示我运行时候的库版本,是为了防止你万一在你的电脑上面运行不了,可以按照我的库版本进行安装并运行 试验

-

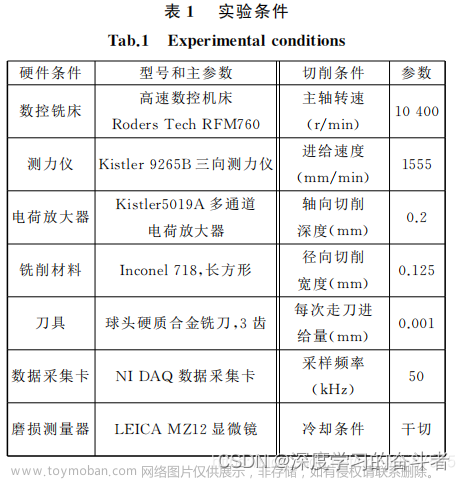

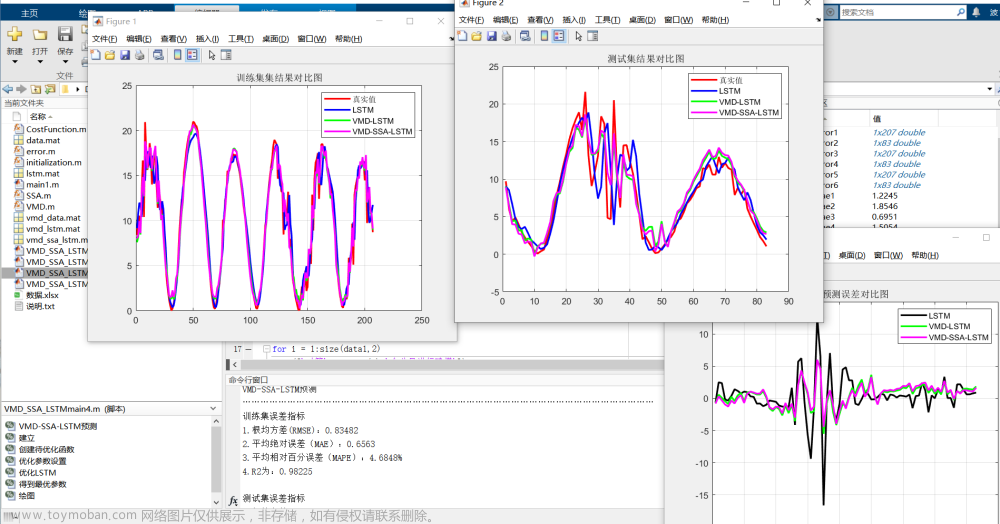

VMD-SSA-LSTM基于变分模态分解和麻雀算法优化长短期记忆网络的时间序列预测MATLAB代码(含LSTM、VMD-LSTM、VMD-SSA-LSTM等模型的对比)。

clc; clear all close all %% VMD-SSA-LSTM预测 tic load vmd_data.mat load lstm.mat disp(\\\'…………………………………………………………………………………………………………………………\\\') disp(\\\'VMD-SSA-LSTM预测\\\') disp(\\\'………………………………………………………………………………………

-

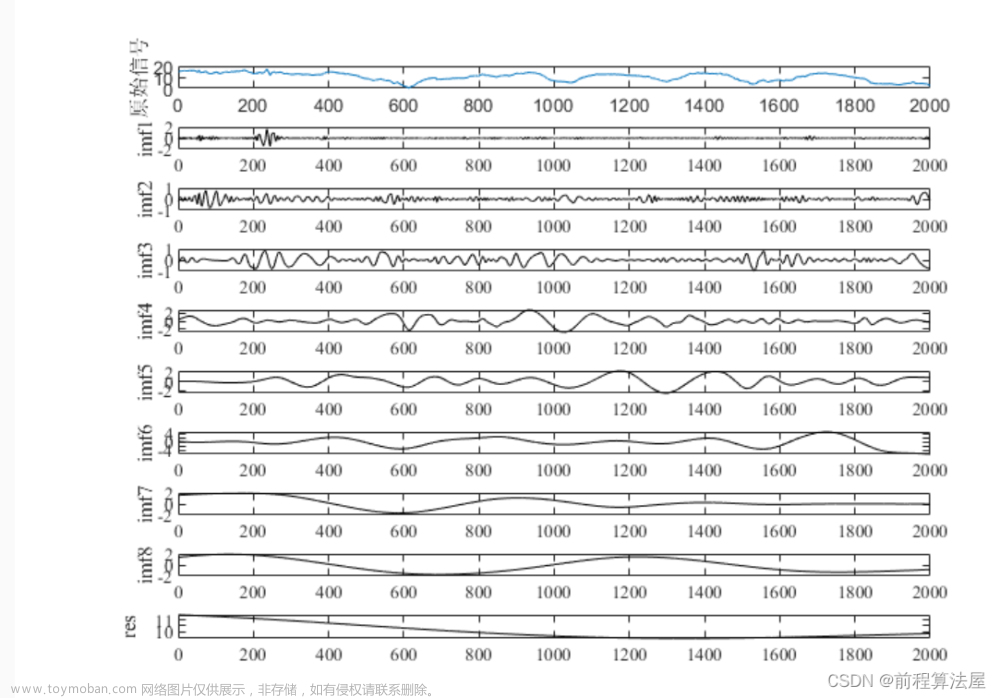

时间序列分解 | Matlab经验模态分解(EMD)的信号分解

效果一览 文章概述 时间序列分解 | Matlab经验模态分解(EMD)的信号分解 部分源码

-

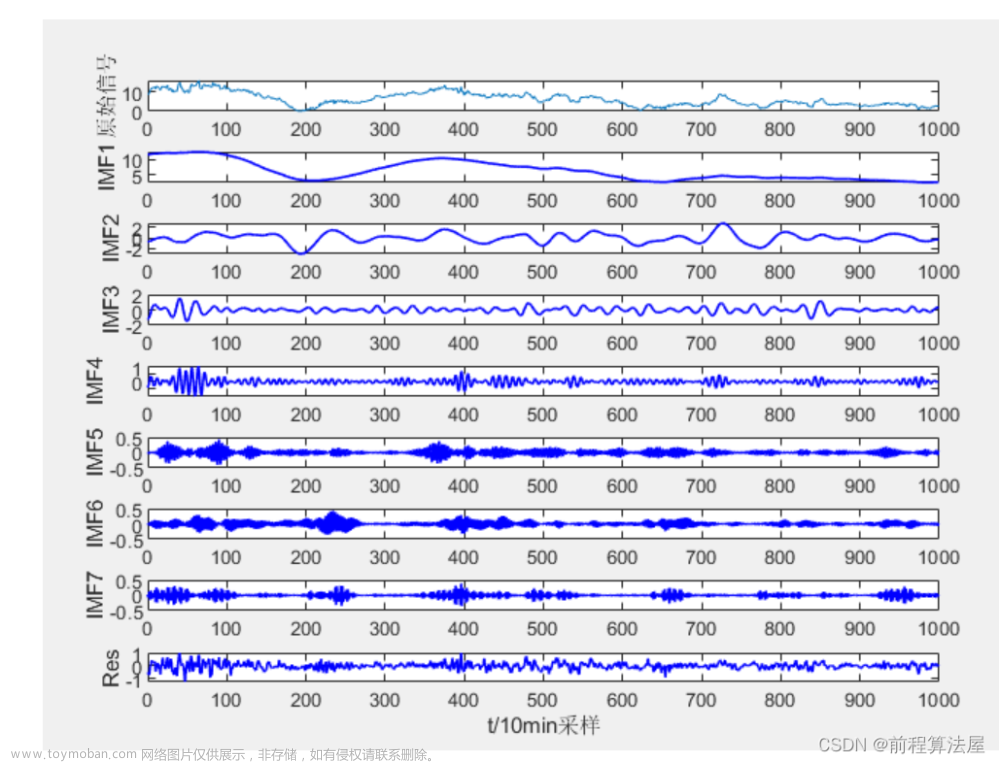

时间序列分解 | Matlab变分模态分解(VMD)的信号分解

效果一览 文章概述 时间序列分解 | Matlab变分模态分解(VMD)的信号分解 部分源码

![[算法前沿]--000-大模型LLaMA在docker环境搭建以及运行教程(含模型压缩)](https://imgs.yssmx.com/Uploads/2024/02/463119-1.gif)