torch.backends.cudnn.enabled

-

报错解决ValueError: did not find a match in any of xarray‘s currently installed IO backends

最近在服务器上配置环境遇到了xarray读取nc数据的相关问题,折腾了一下午终于解决了,记录下来,希望帮助后来人。具体报错如下 想要解决该问题只需要 两步: 【1】下载相关依赖包 可以发现已经明显提示了 缺少IO backends ,可到给出的网址中寻求解答。

-

IDEA开启预览选项--enable-preview

最近在研究loom,我的idea版本是2022.5(2023.1开始支持jdk20,低版本需要自己调) 用到了预览功能 virtualThread报错 is a preview API and is disabled by default. 但是改了sdk到20也一直提示报错 看编译参数是把--source 20 --enable-preview放到了最后(必须放最前面) 解决办法是: 添加VM选项

-

从gradient_checkpointing_enable中学习

1.背景 最近在使用官网的教程训练chatGLM3,但是出现了“RuntimeError: element 0 of tensors does not require grad and does not have a grad_fn”错误,查阅了官方的文档,目前这个问题还没什么解决方案 但是其中有人回复说:是注释掉503行的model.gradient_checkpointing_enable() 。个人验证确实是可以成功的

-

vue报错:We‘re sorry but doesn‘t work properly without JavaScript enabled. Please enable it to continue

vue报错:We‘re sorry but doesn‘t work properly without JavaScript enabled. Please enable it to continue 这个错误感觉是个万能的错误,各种原因都会报这个错误,只能一件一件排查,总结一下出现这种错误的情况: 路由模式是history需要后端修改映射关系的,如果配置错误会出现报错;解决方式

-

解决报错 We‘re sorry but doesn‘t work properly without JavaScript enabled. Please enable it to continue.

vue项目打包发布到线上之后报错 doesn\\\'t work properly without JavaScript enabled. Please enable it to continue. 修改router模式之后重新打包上传就可以了。 把history改成hash即可

-

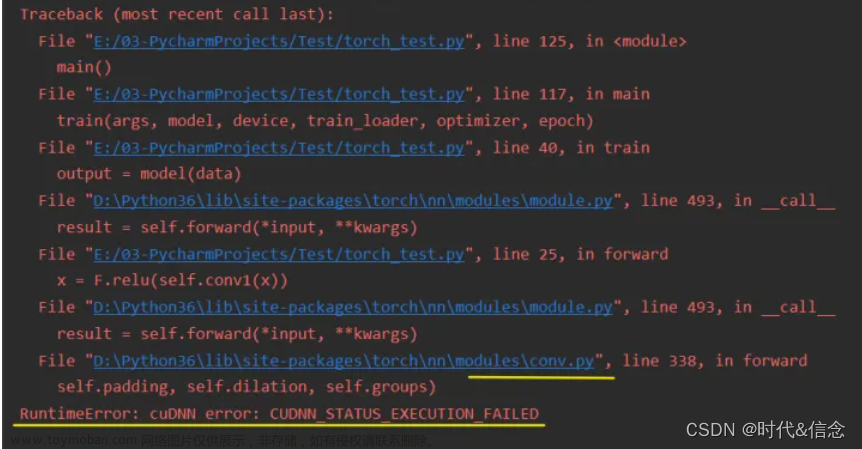

RuntimeError:cuDNN error:CUDNN_STATUS_EXECUTION_FAILED

最近在服务器上跑Deeplabv3进行语义分割时,需要使用GPU版的pytorch。 我在Anaconda下配置了适配服务器CUDA的pytorch,但是报错如下,(下图无限接近于我的错误,但是我忘记截图我的报错了,所以用了下面这张网图) 可以看到每次报错都在 conv.py 这个文件,就是在做 CNN 运算时出

-

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6%的 IPC 相关性。

-

backend.js:748 An error occurred in hook ‘getInspectorState‘ registered by plugin ‘org.vuejs.vue2-in

问题 vue项目控制台操报错 backend.js:748 An error occurred in hook \\\'getInspectorState\\\' registered by plugin \\\'org.vuejs.vue2-internal\\\' with payload: 出现这个问题是你的Vue.js devtools版本搞错了 解决 重新下载插件 旧版本下载 确保禁用任何其他版本的 Vue 开发工具。一次只能启用一个版本。

-

Spring boot 事务无效,报错:Transaction not enabled

使用spring boot + mybatis plus时添加的事务不生效,并且有些方法操作会出现如下异常: 追踪SqlHelper类,找到报错的位置,如下: 可以看到只有批量插入才会报错,单条插入不报错。报错是因为得不到事务标识,猜测可能是事务注解没生效。 查找spring boot的事务使用方式,大多数

-

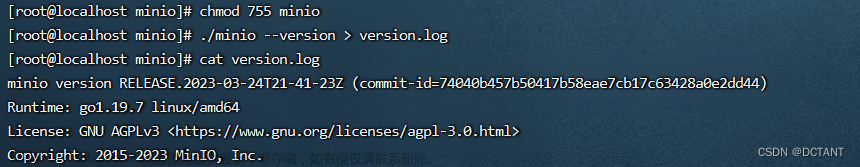

【】解决minio启动报ERROR Unable to use the drive ** found backend type fs, expected xl or xl-single

由于minio报了一个安全漏洞(MinIO verify 接口敏感信息泄露漏洞分析(CVE-2023-28432)_minio 漏洞_超酸柠檬的博客-CSDN博客),以至于公司需要升级minio版本,但是我发现使用最新版本的minio后minio无法正常启动了。由于之前就是单机部署,因此这次还是单机部署,结果却启动不起来了

-

文献阅读:Deep Learning Enabled Semantic Communication Systems

作者 Huiqiang Xie Zhijin Qin Geoffrey Ye Li Biing-Hwang Juang 发表期刊or会议 《IEEE TRANSACTIONS ON SIGNAL PROCESSING》 发表时间 2021.4 这篇论文由《Deep Learning based Semantic Communications: An Initial Investigation》扩展而来 框架或结构 作用 DeepSC 最大化系统容量、最小化语义误差 设计两个Loss函数 理解语义

-

zookeeper 启动失败,报错 “ZooKeeper JMX enabled by default”

zookeeper启动时,出现如下情况: 显示JMX是默认关闭的 通过jps命令查看进程时,没有QuorumPeerMain这个进程 网上有很多方法,有说关闭防火墙的, 也有说把命令改成 ./zkServer.sh start 我都尝试过,和上面效果一样,均无法启动(可能每一个人的解决办法都不一样) 在 zkServer.sh 文

-

MongoDB配置安全选项(security:authorization enabled)后启动不了服务

1、如果将mongod.conf 或者 mongod.cfg 文件里面的security修改为了 authorization: enabled 如果无法启动MongoDB服务,先排除是否是配置文件的格式是否正确 2、如果配置没有问题了,mongodb无法启动,有可能是你没有使用配置文件安装服务 先使用了mongod --remove 或者 sc delete MongoDB 先清除了之

-

IDEA弹出`Lombok requires enabled annotation processing`错误信息

问题背景 项目启动时,弹出一个报错窗口 问题原因 当您使用 Lombok 库时,您可能会遇到 Lombok requires enabled annotation processing 的错误消息。这是因为 Lombok 库使用了 Java 注解处理器(annotation processor),而在默认情况下,Java编译器不会启用注解处理器。为了解决这个问题,您需

-

C++中std::enable_if和SFINAE介绍

作为一个标准的C++模板类,我们先看下enable_if的定义: 再说清楚这部分代码之前,我们先来说明一下 SFINAE( Substitution failure is not an error)的原理,先给一个实例:

-

c++ std::enable_shared_from_this作用

std::enable_shared_from_this 是一个类模板,用来返回指向当前对象的shared_ptr智能指针。在说明它的作用前我们可以看一下如下代码: demo.cpp 类 A 中有一个函数 getSharedPtr() 函数,用来返回指向当前对象的一个shared智能打针。其实就是用 this 构造了一个智能指针进行返回,执行结果

-

【TensorRT】TensorRT was linked against cudnn 8.6.0 but loaded cudnn 8.3.2

文章指引:Win10 安装 Tensorrt和torch2trt教程 系统 :Win10 显卡 :NVIDIA GeForce RTX 3090 cuda版本 :CUDA 11.6.2 python版本 :3.9 TensorRT安装版本 :8.5.1.7 在使用TensorRT-8.5.1.7,发布模型和推理发布的trt模型时出现警告,TensorRT was linked against cudnn 8.6.0 but loaded cudnn 8.3.2 (类似问题见文章 [1] )

-

【Pytorch报错】RuntimeError:cuDNN error:CUDNN_STATUS_INTERNAL_ERROR 高效理解记录及解决!

明明跑了一段时间?跑过一次完整的?怎么就出现这个报错呢?代码也未改动?而这就是现实! 观察显卡使用情况,多人共用同一服务器,项目各自运行,会抢占显存,进而报错! 多个项目运行,占用增加,导致内存用完报错,还是很真实的! 文件是否设置了CUDA_VISIBLE_DE

-

uniapp打包H5出现Please enable JavaScript to continue

这个问题困扰了我2天的时间。几乎看完了所有的文档。网上各种配置,各种说法,这里做一个统一的归纳汇总。 这里说明一下,调试是调试,打包是打包,谁的问题,就看谁。 调试的问题请看 uniapp跨域的问题 的文章,在我的列表里面找。 下面说,当界面出现这个原因的解

-

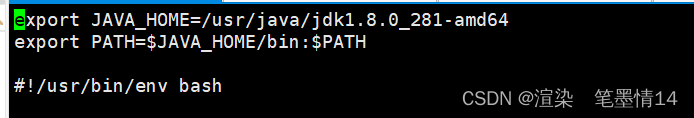

出现ZooKeeper JMX enabled by default这种错误的解决方法

学习以来遇到的bug/问题专栏 文章目录 系列文章专栏 前言 一 问题描述 二 解决方法 2.1 可能的原因分析 2.2 小编的问题解决方法 First:检查/etc/profile里面zookeeper的环境变量配置 Second:检查 zookeeper/conf/zoo.cfg里面的dataDir的路径 总结 本文主要介绍出现ZooKeeper JMX enabled by defaultU